-

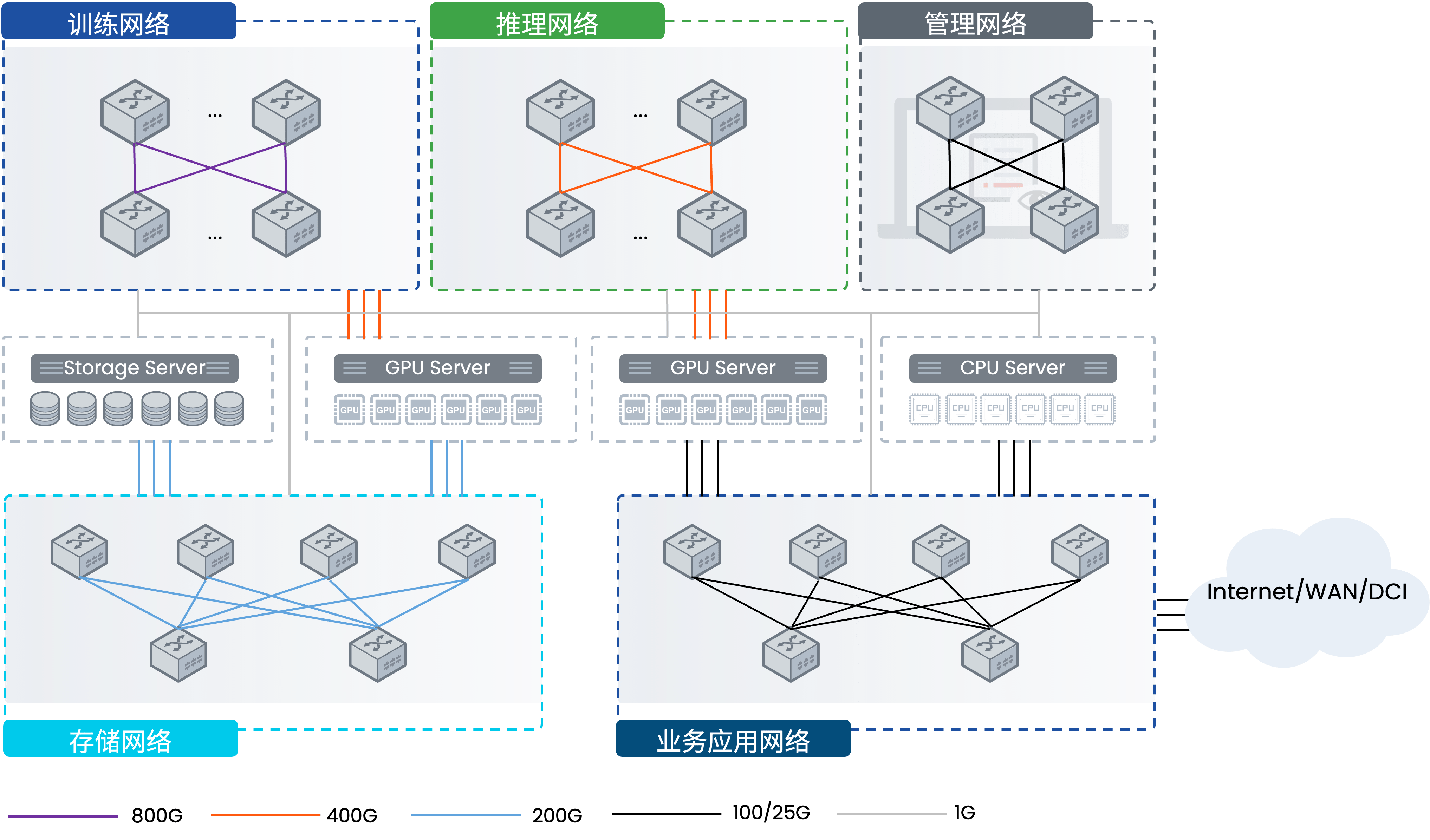

基于CX8/7/6(-N系列)数据中心交换机,搭建800G/400G/200G网络连接GPU集群

-

基于CX6/5(-N系列)数据中心交换机,搭建200G/100G网络连接存储集群

-

基于CX5/3(-N系列)数据中心交换机,搭建100G/25G网络连接CPU集群

-

基于CX2(-M系列)云化园区交换机,搭建25G/1G网络,管理集群和网络的所有设备

方案亮点

开放、中立的网络基础设施

星融元AI/ML网络解决方案的开放性确保用户能够重用已有的系统(K8s、Prometheus等)对网络进行管理,无需重复投入;星融元以“中立的网络供应商参与AI生态”的理念为用户提供专业的网络方案,帮助用户规避“全栈方案锁定”的风险。

提升大模型训练效率

CX-N数据中心交换机的单机转发时延(400ns)低至业界平均水平的1/4~1/5,将网络时延在AI/ML应用端到端时延中的占比降至最低,同时多维度的高可靠设计确保网络在任何时候都不中断,帮助大模型的训练大幅度降低训练时间、提升整体效率。

大幅度降低TCO

与业界其他方案不同,CX-N系列数据中心交换机标配全端口支持RoCEv2、智能负载均衡、BGP/EVPN、VXLAN等AI/ML网络必须的能力,并且在大规模运营网络中经过了充分的验证,用户无需再为这些能力支付额外的License费用。

一站式AI/ML网络

采用星融元的“AsterNOS网络操作系统 + CX-N数据中心交换机 + CX-M云化园区交换机”搭建承载AI/ML环境的所有网络模块,统一的软硬件系统、统一的部署逻辑、统一的运维逻辑,用户无需再为来自多供应商的网络支付额外的学习成本。

面向未来的投资保护

为了确保用户网络与最领先的以太网技术保持同步,星融元提供前后向兼容的200G/400G/800G网络能力,已加入超以太网联盟(UEC)并率先支持UEC定义的当前规范,积极参与新一代AI以太网规范的讨论与制定。

关键技术

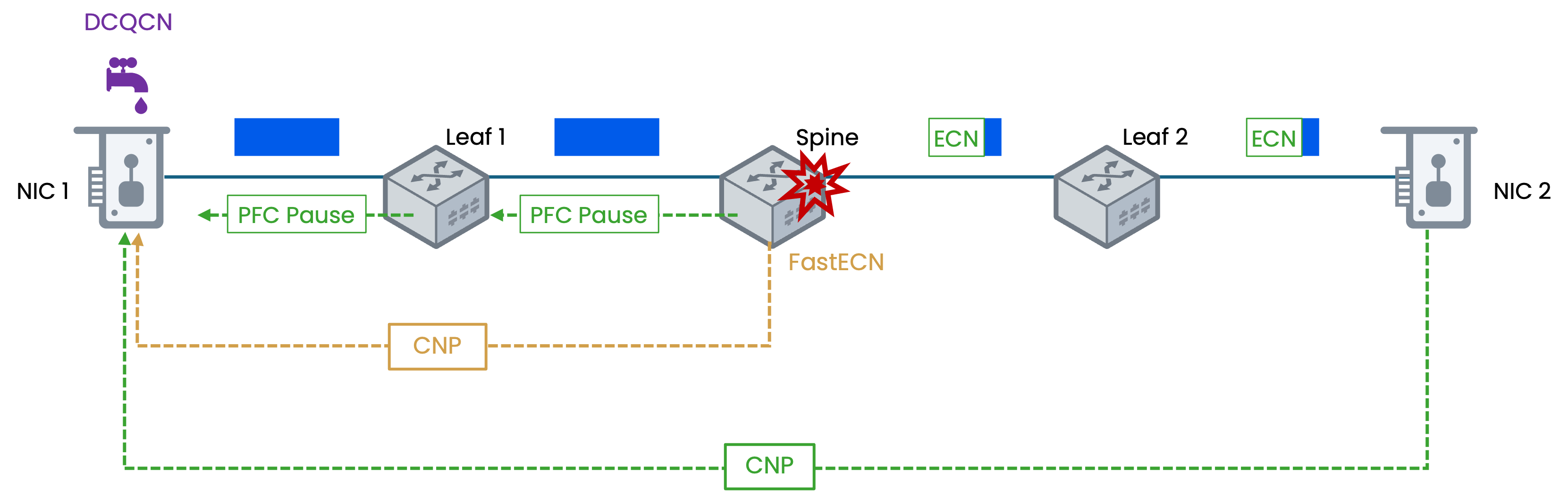

RoCEv1/v2 – PFC, ECN/Fast ECN, ETS,DCQCN, DCBX

- 逐跳提供基于队列优先级的流量控制

- 在交换机侧检测拥塞并通知发送端降低发送速率

- 为RoCE网络上的不同业务流量合理分配带宽,提高带宽利用率

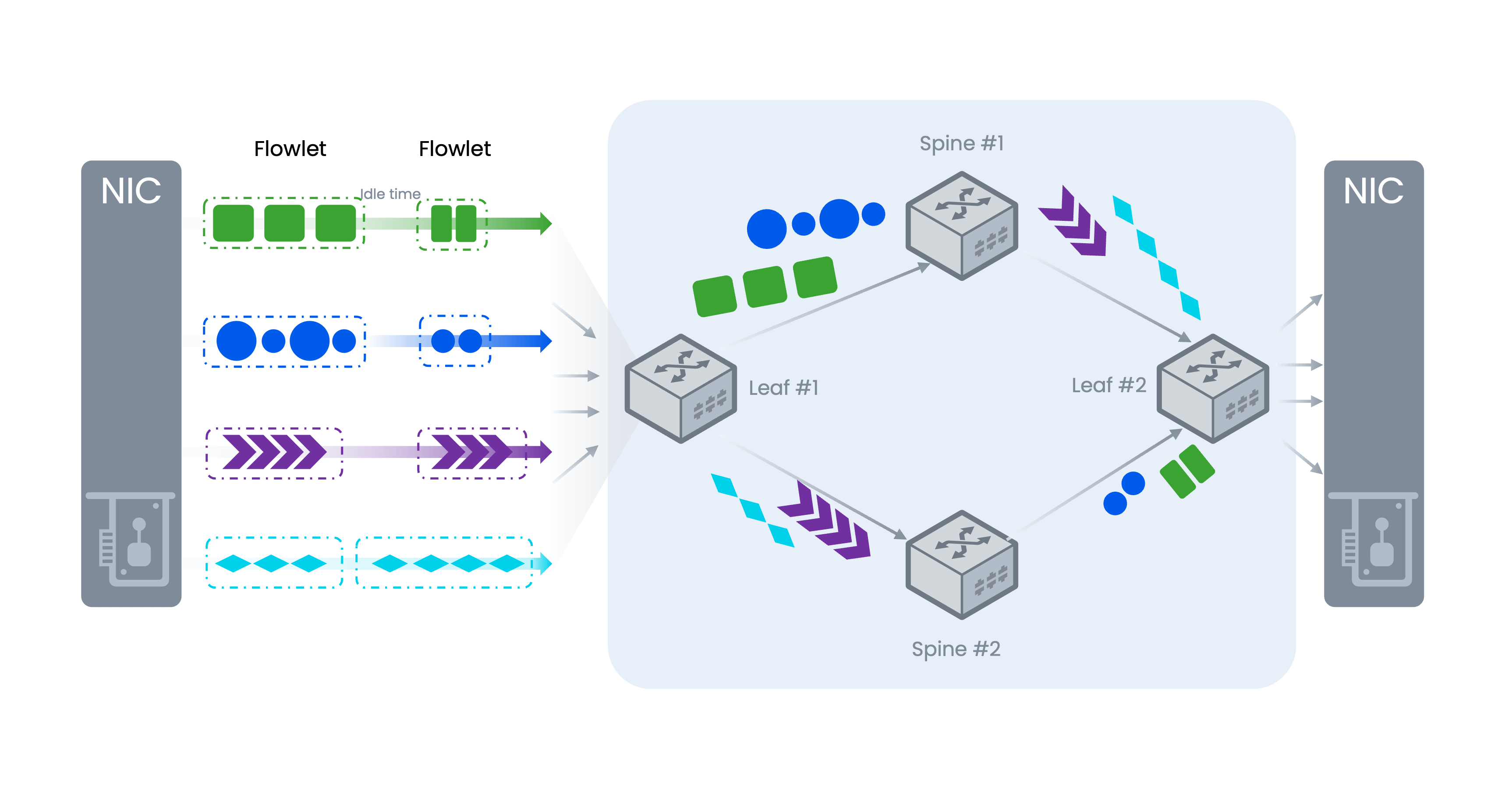

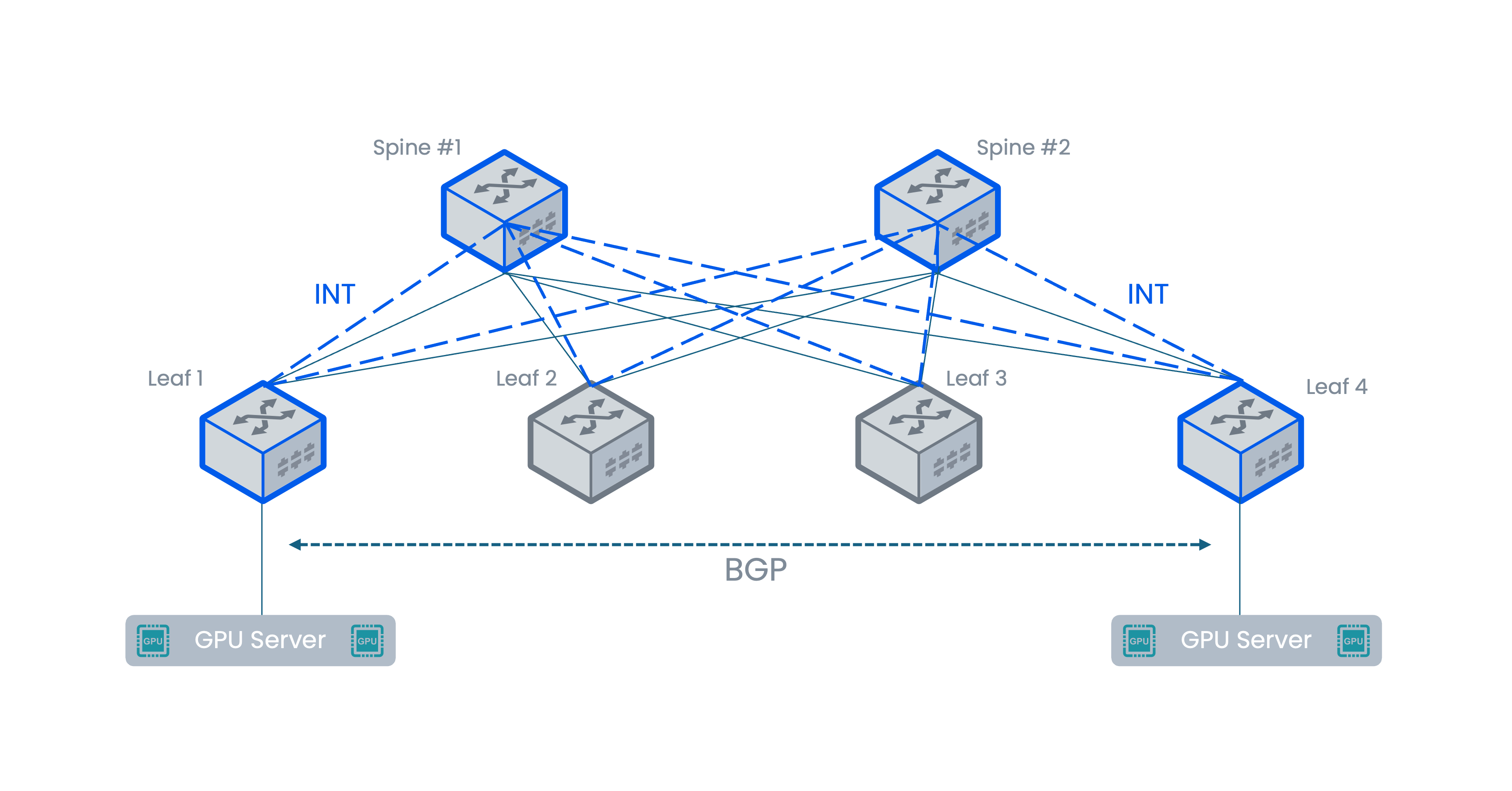

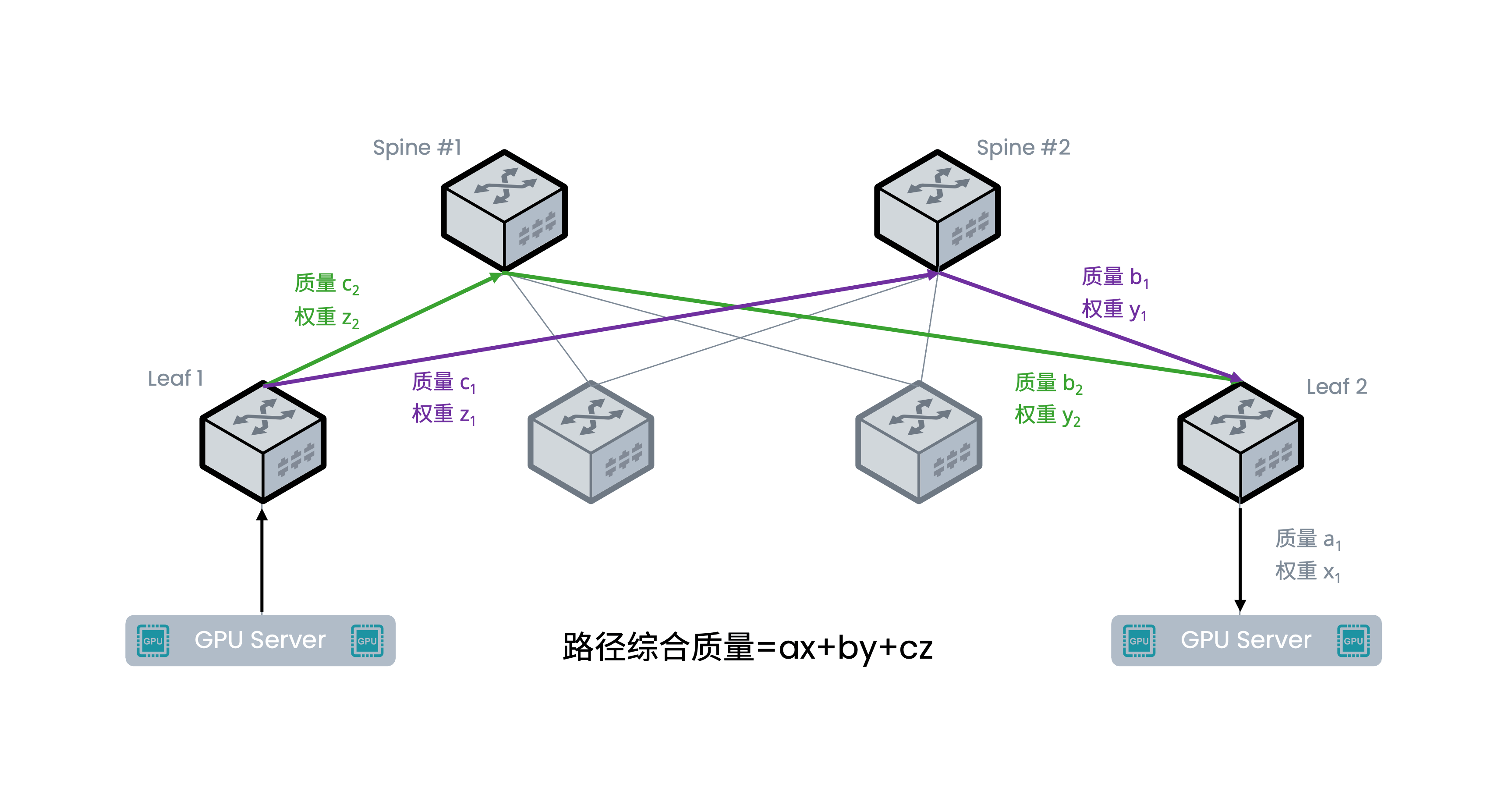

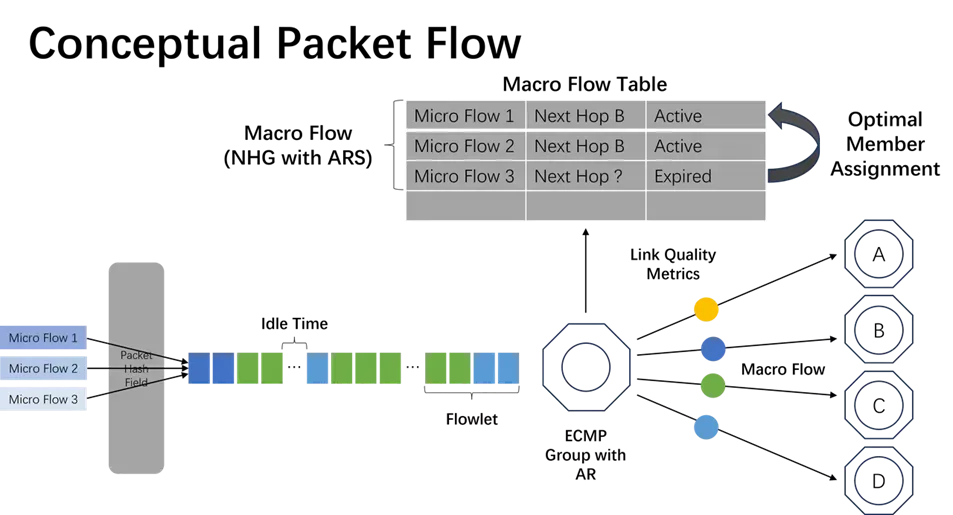

自适应路由切换(ARS)

自适应路由切换(ARS)是一种基于感知路由的负载均衡技术,通过使用组网中交换机感知到的路径质量,来调整本地交换机的路径选择,并支持动态加权负载均衡方式平衡流量负载。这种动态智能选路技术以 BGP 为基础,通过 BGP 扩展能力,定义了一个新的扩展社区属性,基于多维度高精度测量值综合评价路径质量,通过 BGP 协议的扩展社区属性进行传递,用于指导后续业务流量的转发,提高整网负载均衡效率,减少应用响应时间。

EasyRoCE Toolkit

依托开源、开放的网络架构与技术,为AI 智算、高性能计算等场景的RDMA 融合以太网(RoCE)提供的一系列实用特性和小工具。从前期规划实施到日常运维监控, EasyRoCE 简化了各环节的复杂度并改善了操作体验,更提供二次开发和集成空间,供网络架构师充分利用开放网络的最新技术成果。

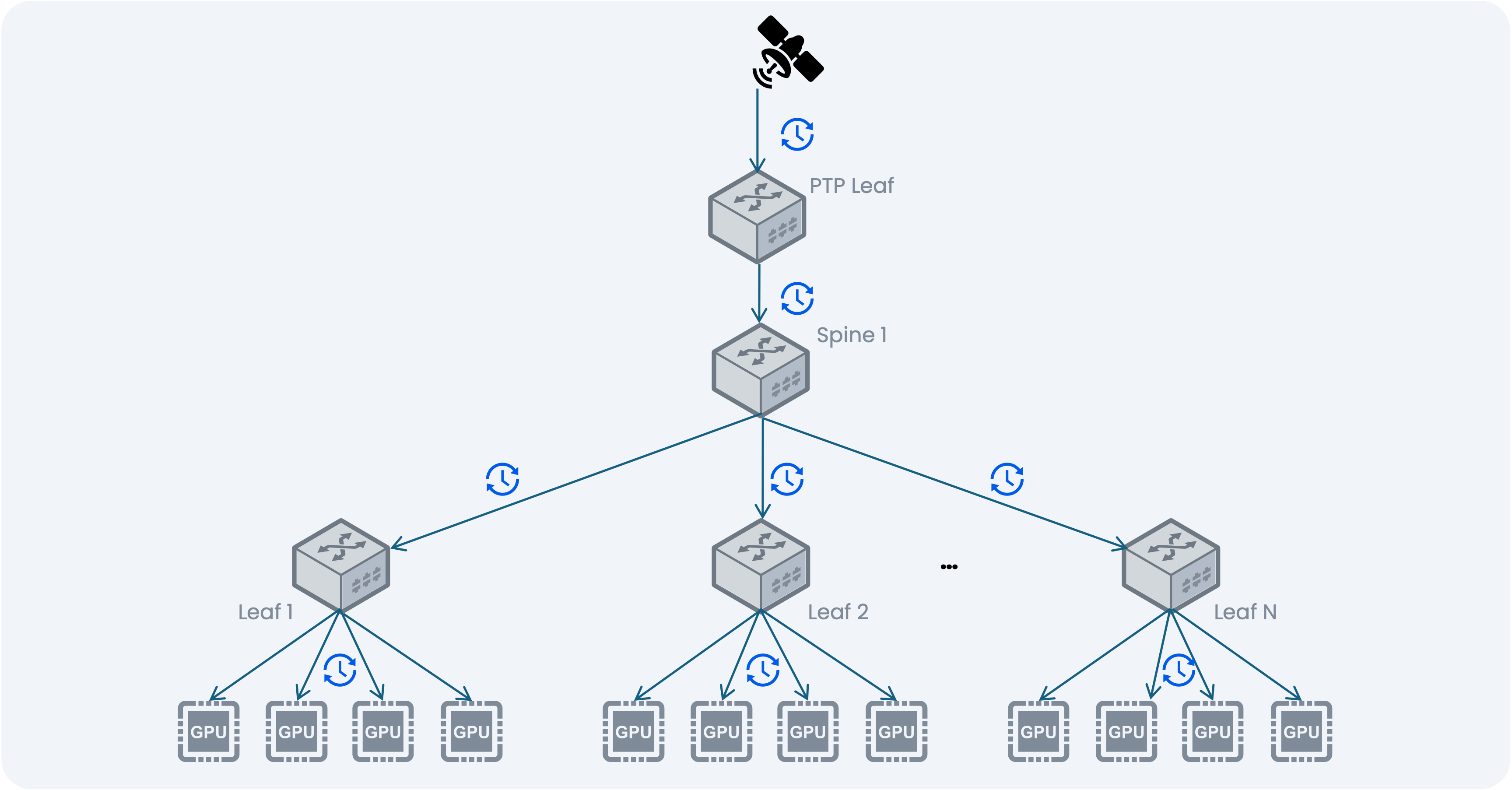

高精度时间同步

- 通过PTP网络同步所有 GPU 之间的时钟

- 交换机可作为 Master Clock 并支持 SyncE

- 硬件时间戳确保高达 20 ns 时钟同步精度

- 加速 GPU 并行计算,缩短作业完成时间

新闻动态

-

2026-01-16

-

2025-08-12

-

2025-08-07

-

2025-07-15