DPU智能网卡VNF功能卸载验证

——OVS、vFW与SSL加解密的卸载

Helium智能网卡VNF功能卸载验证

1 验证方案介绍

本篇Helium智能网卡(下文统一简称为“智能网卡”)解决方案,是为了验证其对VNF功能的卸载能力。整个验证过程涵盖三个功能点,即:1.智能网卡对OVS的卸载;2.智能网卡对基于虚拟机的VNF(vFW)功能卸载;3.智能网卡对基于容器的VNF(SSL加解密)功能卸载。

2 硬件与软件环境

验证过程中涉及到的硬件和软件环境如表2-1和表2-2所示。

| 名称 | 型号 | 硬件指标 | 数量 | 备注 |

|---|---|---|---|---|

| 智能网卡 | EC2004Y | 【参见产品彩页】 | 1 | / |

| 服务器 | X86 | 需兼容全高尺寸网卡 | 2 | / |

| 光模块 | 25G | SFP28 | 2 | / |

| 光纤 | 多模 | 10G/25G适用 | 1 | / |

| 软件 | 版本 | 备注 |

|---|---|---|

| 宿主机操作系统 | CentOS 7.8.2003 | 无 |

| 智能网卡操作系统 | debian10_ec96_V1.1R6.tar | 无 |

| DPDK | EC96_DPDK19.11_V1.1R5.tar.gz | 无 |

| ovs | ovs_V1.1R6.bin | 智能网卡的应用 |

| 智能网卡驱动 | EC96_Driver_V1.1R5.tar.gz | 宿主机的驱动 |

| vhost-user | vhost-ec2004Y | 宿主机的驱动 |

3 验证思路与结果

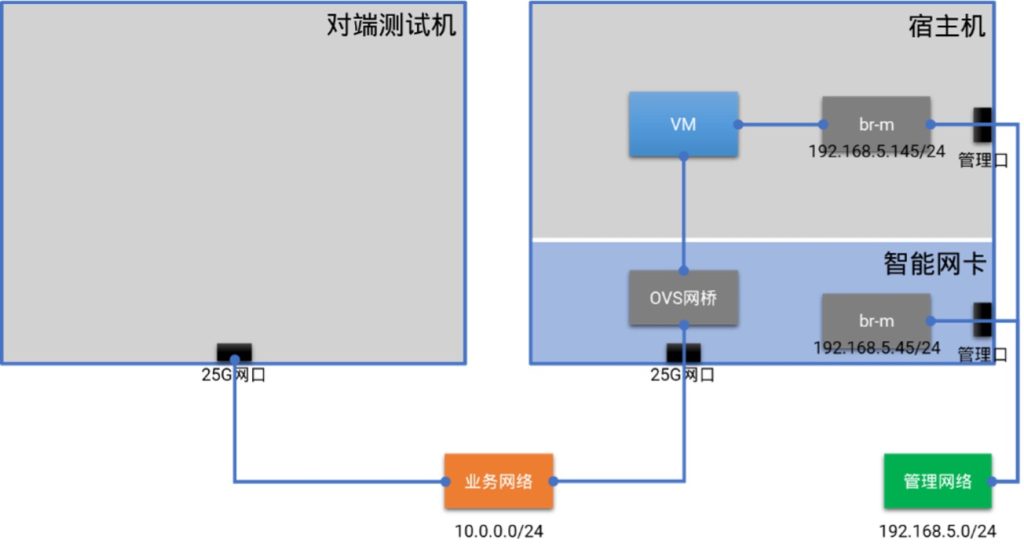

3.1 将OVS卸载到智能网卡

参考研发提供的用户手册《EC2004Y网卡安装手册VX.Y.Z》,将智能网卡正确安装到服务器中,在智能网卡的操作系统安装完毕后,进行管理网口配置、驱动安装调试等基本配置操作。

完成以上基本配置后,在智能网卡侧运行OVS,创建测试网桥,然后在宿主机侧启动两台虚拟机连接到测试网桥上。经过验证测试,两台虚拟机之间可以通过位于智能网卡侧的OVS网桥进行通信,证明OVS卸载到智能网卡后可以正常提供服务。

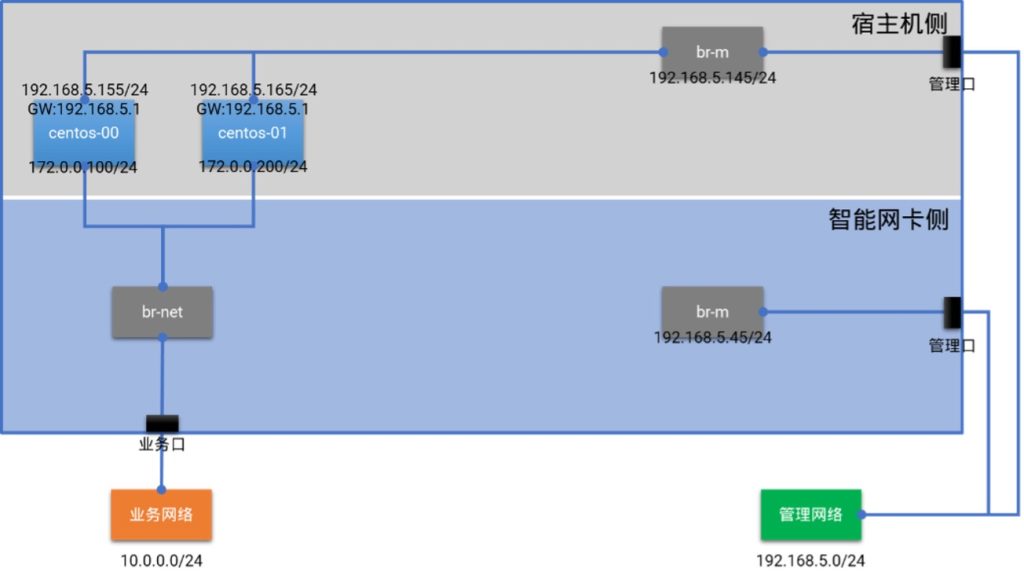

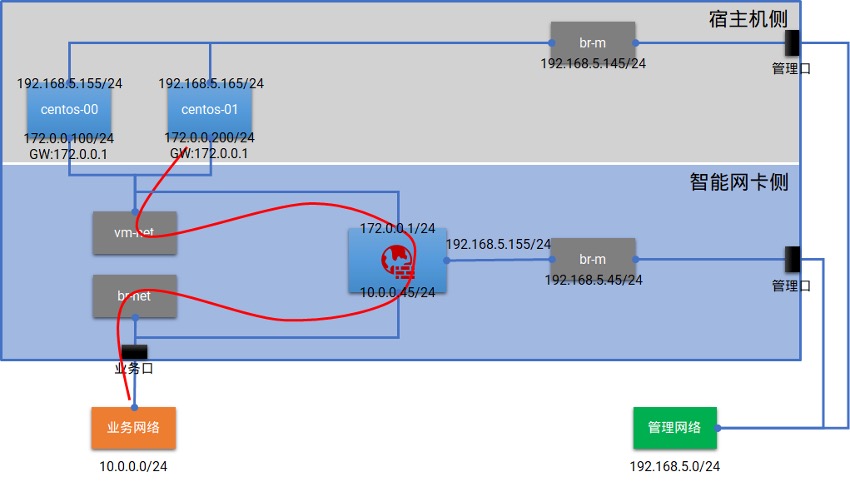

3.2 基于虚拟机的vFW卸载

为了验证智能网卡对基于虚拟机的VNF卸载能力,本方案将在宿主机侧启动两台虚拟机作为租户的业务实例,在智能网卡侧运行CentOS虚拟机,配置相应的iptables规则作为VPC网关与防火墙。

经过验证测试,成功地将防火墙功能卸载至智能网卡。由上图可知,租户的VPC网段为172.0.0.0/24,实例的网关设置为VPC网关172.0.0.1。当智能网卡上运行的防火墙收到业务实例访问其他网段的流量时,会对流量按预设规则进行过滤转发,而且在转发到业务网络前会进行一次SNAT,使得租户VPC内的实例可以访问到业务网络。

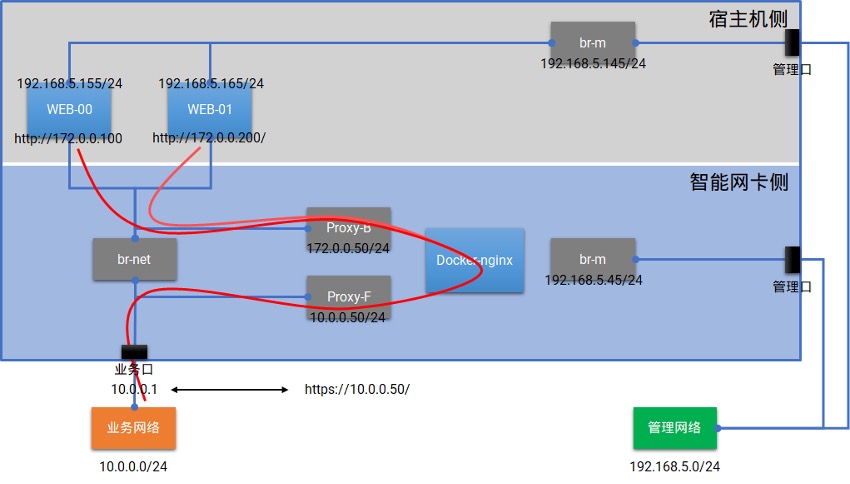

3.3 基于容器的SSL加解密卸载

为了验证智能网卡对基于容器的VNF卸载能力,本方案将在宿主机侧启动两台虚拟机作为WEB后端,在智能网卡侧运行nginx容器作为SSL加解密的前端和负载均衡器,用https://10.0.0.50/这个域名对业务网的其他用户提供HTTPS服务。

经过验证测试,成功地将SSL加解密功能卸载至智能网卡。当nginx容器从智能网卡的25G业务口收到来自客户端10.0.0.1访问https://10.0.0.50/的HTTPS流量时,会将其转换为HTTP流量发送至位于宿主机的WEB节点中,后端WEB节点的选择采用轮询算法,因此在客户端10.0.0.1上多次访问,会交替收到WEB-00和WEB-01响应的页面。

4 验证方案的详细配置流程

4.1 将OVS卸载到智能网卡

- 4.1.1 安装并对智能网卡进行基本配置

参考研发提供的用户手册《EC2004Y网卡安装手册VX.Y.Z》,将智能网卡正确安装到服务器中,并在智能网卡的操作系统安装完毕后,进行管理网口配置、驱动安装调试等基本配置操作。

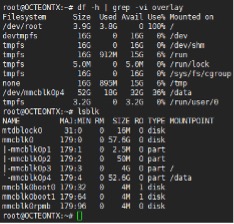

# 本方案中配置num_vfs参数为4,因此在宿主机上可以看到如下四个PCIe网络设备。

[root@asterfusion ~]# lspci -nn -d 177d:b203

03:02.0 Network controller [0280]: Cavium, Inc. Device [177d:b203]

03:02.1 Network controller [0280]: Cavium, Inc. Device [177d:b203]

03:02.2 Network controller [0280]: Cavium, Inc. Device [177d:b203]

03:02.3 Network controller [0280]: Cavium, Inc. Device [177d:b203]

# 智能网卡的管理网口接入管理网192.168.5.0/24,配置的管理IP为192.168.5.45。

- 4.1.2 安装OVS

# 拷贝OVS安装文件到网卡data目录,进行安装。

root@OCTEONTX:/data# chmod +x ovs_V1.1R6.bin

root@OCTEONTX:/data# ./ovs_V1.1R6.bin

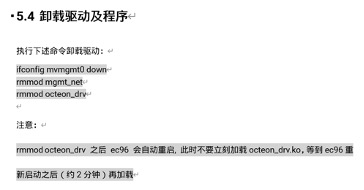

- 4.1.3 验证OVS

# 启动OVS

root@OCTEONTX:/data# cd ovs_install

root@OCTEONTX:/data/ovs_install# chmod +x ovs_start.sh

root@OCTEONTX:/data/ovs_install# ./ovs_start.sh

# 验证OVS和DPDK的版本

root@OCTEONTX:/data/ovs_install# ovs-vsctl get Open_vSwitch . dpdk_initialized

true

root@OCTEONTX:/data/ovs_install# ovs-vsctl get Open_vSwitch . dpdk_version

"DPDK 19.11.0"

root@OCTEONTX:/data/ovs_install# ovs-vswitchd --version

ovs-vswitchd (Open vSwitch) 2.11.1

DPDK 19.11.0

- 4.1.4 在智能网卡侧配置管理网与业务网的网桥

# 创建并配置管理网的网桥,并将智能网卡的管理网IP放到此网桥上

root@OCTEONTX:~# ovs-vsctl add-br br-m -- set bridge br-m datapath_type=netdev

root@OCTEONTX:~# ip add del dev eth4 192.168.5.45/24

root@OCTEONTX:~# ovs-vsctl add-port br-m eth4

root@OCTEONTX:~# ip link set dev br-m up

root@OCTEONTX:~# ip add add dev br-m 192.168.5.45/24

root@OCTEONTX:~# ip route add default via 192.168.5.1 dev br-m

# 创建并配置业务网的网桥,将智能网卡的物理网口eth0连接到此网桥上

root@OCTEONTX:~# ovs-vsctl add-br br-net -- set bridge br-net datapath_type=netdev

root@OCTEONTX:~# ovs-vsctl add-port br-net eth0 -- set Interface eth0 type=dpdk options:dpdk-devargs=0002:02:00.0

root@OCTEONTX:~# ip link set dev br-net up

- 4.1.5 在宿主机侧创建两台虚拟机,连接到智能网卡侧的业务网桥

# 将vhost-ec2004Y驱动上传到宿主机,并在screen中保持运行状态。

[root@asterfusion ~]# screen -S vhost-ec96

[root@asterfusion ~]# ./vhost-ec2004Y -l0-7 -w 0000:03:02.0 -w 0000:03:02.1 -- -s /tmp/vhost-user-0.sock -s /tmp/vhost-user-1.sock -c --mergeable 1 --stats 1 -t 0

使用组合键Ctrl + A,然后再使用Ctrl + D将screen保存到后台继续运行。

[root@asterfusion ~]# ls -lh /tmp/vhost-user-*

srwxrwxr-x 1 qemu qemu 0 Aug 23 14:33 /tmp/vhost-user-0.sock

srwxrwxr-x 1 qemu qemu 0 Aug 23 15:08 /tmp/vhost-user-1.sock

# 修改虚拟机的xml配置文件,添加一个vhost-user的虚拟网卡。

# centos-00:

<domain type='kvm'>

<name>centos-00</name>

<devices>

<emulator>/usr/libexec/qemu-kvm</emulator>

……

<interface type='vhostuser'>

<mac address='52:54:00:c7:ac:00'/>

<source type='unix' path='/tmp/vhost-user-0.sock' mode='server'/>

<model type='virtio'/>

<address type='pci' domain='0x0000' bus='0x03' slot='0x02' function='0x0'/>

</interface>

……

</devices>

</domain>

# centos-01:

<domain type='kvm'>

<name>centos-01</name>

<devices>

<emulator>/usr/libexec/qemu-kvm</emulator>

……

<interface type='vhostuser'>

<mac address='52:54:00:c7:ac:01'/>

<source type='unix' path='/tmp/vhost-user-1.sock' mode='server'/>

<model type='virtio'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/>

</interface>

……

</devices>

</domain>

# 创建两台CentOS7虚拟机并启动。

[root@asterfusion ~]# virsh define centos-00.xml

[root@asterfusion ~]# virsh define centos-01.xml

[root@asterfusion ~]# virsh start centos-00

[root@asterfusion ~]# virsh start centos-01

[root@asterfusion ~]# virsh list --all

Id Name State

----------------------------------------------------

13 centos-00 running

14 centos-01 running

# 将虚拟机连接到宿主机侧的管理网桥。

[root@asterfusion ~]# ip link add centos-00-m type veth peer name centos-00-m-s

[root@asterfusion ~]# ip link add centos-01-m type veth peer name centos-01-m-s

[root@asterfusion ~]# ovs-vsctl add-br br-m

[root@asterfusion ~]# ip link set dev br-m up

[root@asterfusion ~]# ip add add dev br-m 192.168.5.145/24

[root@asterfusion ~]# ip route add default via 192.168.5.1 dev br-m

[root@asterfusion ~]# ovs-vsctl add-port br-m centos-00-m-s

[root@asterfusion ~]# ovs-vsctl add-port br-m centos-01-m-s

[root@asterfusion ~]# virsh attach-interface centos-00 --type direct --source centos-00-m --config

[root@asterfusion ~]# virsh attach-interface centos-00 --type direct --source centos-00-m --live

[root@asterfusion ~]# virsh attach-interface centos-01 --type direct --source centos-01-m --config

[root@asterfusion ~]# virsh attach-interface centos-01 --type direct --source centos-01-m --live

[root@asterfusion ~]# ip link set dev centos-00-m up

[root@asterfusion ~]# ip link set dev centos-01-m up

[root@asterfusion ~]# ip link set dev centos-00-m-s up

[root@asterfusion ~]# ip link set dev centos-01-m-s up

# 分别给两台虚拟机配置业务IP。

# centos-00:

[root@centos-00 ~]# ip link set dev eth0 up

[root@centos-00 ~]# ip add add dev eth0 172.0.0.100/24

# centos-01:

[root@centos-01 ~]# ip link set dev eth0 up

[root@centos-01 ~]# ip add add dev eth0 172.0.0.200/24

# 分别给两台虚拟机配置管理IP。

# centos -00:

[root@centos-00 ~]# ip link set dev eth1 up

[root@centos-00 ~]# ip add add dev eth1 192.168.5.155/24

[root@centos-00 ~]# ip route add default via 192.168.5.1 dev eth1

# centos-01:

[root@centos-01 ~]# ip link set dev eth1 up

[root@centos-01 ~]# ip add add dev eth1 192.168.5.165/24

[root@centos-01 ~]# ip route add default via 192.168.5.1 dev eth1

# 在智能网卡侧将虚拟机使用的两个VF绑定到业务网桥br-net。

root@OCTEONTX:~# ovs-vsctl add-port br-net sdp1 -- set Interface sdp1 type=dpdk options:dpdk-devargs=0002:0f:00.2 mtu_request=9000

root@OCTEONTX:~# ovs-vsctl add-port br-net sdp2 -- set Interface sdp2 type=dpdk options:dpdk-devargs=0002:0f:00.3 mtu_request=9000

- 4.1.6 验证宿主机侧两台虚拟机的连通性

# 经过验证两台虚拟机能够经过智能网卡侧的网桥br-net正常通信。

# centos-00:

[root@centos-00 ~]# ping 172.0.0.200 -c 4

PING 172.0.0.200 (172.0.0.200) 56(84) bytes of data.

64 bytes from 172.0.0.200: icmp_seq=1 ttl=64 time=0.220 ms

64 bytes from 172.0.0.200: icmp_seq=2 ttl=64 time=0.164 ms

64 bytes from 172.0.0.200: icmp_seq=3 ttl=64 time=0.140 ms

64 bytes from 172.0.0.200: icmp_seq=4 ttl=64 time=0.132 ms

--- 172.0.0.200 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3000ms

rtt min/avg/max/mdev = 0.132/0.164/0.220/0.034 ms

[root@centos-00 ~]#

# centos-01:

[root@centos-01 ~]# ping 172.0.0.100 -c 4

PING 172.0.0.100 (172.0.0.100) 56(84) bytes of data.

64 bytes from 172.0.0.100: icmp_seq=1 ttl=64 time=0.159 ms

64 bytes from 172.0.0.100: icmp_seq=2 ttl=64 time=0.163 ms

64 bytes from 172.0.0.100: icmp_seq=3 ttl=64 time=0.179 ms

64 bytes from 172.0.0.100: icmp_seq=4 ttl=64 time=0.180 ms

--- 172.0.0.100 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 2999ms

rtt min/avg/max/mdev = 0.159/0.170/0.180/0.013 ms

[root@centos-01 ~]#

4.2 基于虚拟机的vFW卸载

本小节的所有操作,都是基于4.1小节的配置环境进行,因此基础的操作步骤不再赘述。

- 4.2.1 在智能网卡侧配置网桥vm-net,并将宿主机侧的两台虚机连接到此网桥

# 在智能网卡侧创建网桥vm-net。

root@OCTEONTX:~# ovs-vsctl add-br vm-net -- set bridge vm-net datapath_type=netdev

# 将VF从br-net网桥上删除。

root@OCTEONTX:~# ovs-vsctl del-port br-net sdp1

root@OCTEONTX:~# ovs-vsctl del-port br-net sdp2

# 将VF连接到vm-net网桥。

root@OCTEONTX:~# ovs-vsctl add-port vm-net sdp1 -- set Interface sdp1 type=dpdk options:dpdk-devargs=0002:0f:00.2 mtu_request=9000

root@OCTEONTX:~# ovs-vsctl add-port vm-net sdp2 -- set Interface sdp2 type=dpdk options:dpdk-devargs=0002:0f:00.3 mtu_request=9000

- 4.2.2 在智能网卡侧创建虚拟机,并分别连接到网桥vm-net和br-net

# 在智能网卡侧安装虚拟化软件包。

root@OCTEONTX:~# apt install -y qemu qemu-utils qemu-efi-arm qemu-efi-aarch64 qemu-system-arm qemu-system-common qemu-system-data qemu-system-gui

# 准备虚拟机的镜像和xml文件,结果如下。

root@OCTEONTX:/data# mkdir libvirt && cd libvirt

root@OCTEONTX:/data/libvirt# tree

.

|-- images

| |-- CentOS-7-aarch64-GenericCloud-2009.qcow2

| `-- QEMU_EFI.fd

`-- xml

|-- centos-00.xml

`-- default-net.xml

2 directories, 4 files

root@OCTEONTX:/data/libvirt# cat xml/centos-00.xml

<domain type='qemu'>

<name>centos-00</name>

<uuid>dc042799-4e06-466f-8fce-71ac2105f786</uuid>

<metadata>

<libosinfo:libosinfo xmlns:libosinfo="http://libosinfo.org/xmlns/libvirt/domain/1.0">

<libosinfo:os id="http://centos.org/centos/7.0"/>

</libosinfo:libosinfo>

</metadata>

<memory unit='KiB'>2097152</memory>

<currentMemory unit='KiB'>2097152</currentMemory>

<vcpu placement='static'>2</vcpu>

<os>

<type arch='aarch64' machine='virt-4.2'>hvm</type>

<loader readonly='yes' type='pflash'>/usr/share/AAVMF/AAVMF_CODE.fd</loader>

<nvram>/var/lib/libvirt/qemu/nvram/centos-00_VARS.fd</nvram>

<boot dev='hd'/>

</os>

<features>

<acpi/>

<gic version='2'/>

</features>

<cpu mode='custom' match='exact' check='none'>

<model fallback='allow'>cortex-a57</model>

</cpu>

<clock offset='utc'/>

<on_poweroff>destroy</on_poweroff>

<on_reboot>restart</on_reboot>

<on_crash>destroy</on_crash>

<devices>

<emulator>/usr/bin/qemu-system-aarch64</emulator>

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2'/>

<source file='/data/libvirt/images/CentOS-7-aarch64-GenericCloud-2009.qcow2'/>

<target dev='vda' bus='virtio'/>

<address type='pci' domain='0x0000' bus='0x04' slot='0x00' function='0x0'/>

</disk>

<controller type='pci' index='0' model='pcie-root'/>

<controller type='pci' index='1' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='1' port='0x8'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x0' multifunction='on'/>

</controller>

<controller type='pci' index='2' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='2' port='0x9'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x1'/>

</controller>

<controller type='pci' index='3' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='3' port='0xa'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x2'/>

</controller>

<controller type='pci' index='4' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='4' port='0xb'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x3'/>

</controller>

<controller type='pci' index='5' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='5' port='0xc'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x4'/>

</controller>

<controller type='pci' index='6' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='6' port='0xd'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x5'/>

</controller>

<controller type='pci' index='7' model='pcie-root-port'>

<model name='pcie-root-port'/>

<target chassis='7' port='0xe'/>

<address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x6'/>

</controller>

<controller type='virtio-serial' index='0'>

<address type='pci' domain='0x0000' bus='0x03' slot='0x00' function='0x0'/>

</controller>

<serial type='pty'>

<target type='system-serial' port='0'>

<model name='pl011'/>

</target>

</serial>

<console type='pty'>

<target type='serial' port='0'/>

</console>

<channel type='unix'>

<target type='virtio' name='org.qemu.guest_agent.0'/>

<address type='virtio-serial' controller='0' bus='0' port='1'/>

</channel>

<memballoon model='virtio'>

<address type='pci' domain='0x0000' bus='0x05' slot='0x00' function='0x0'/>

</memballoon>

<rng model='virtio'>

<backend model='random'>/dev/urandom</backend>

<address type='pci' domain='0x0000' bus='0x06' slot='0x00' function='0x0'/>

</rng>

</devices>

</domain>

# 创建虚拟机并启动。

root@OCTEONTX:/data/libvirt# virsh define centos-00.xml

root@OCTEONTX:/data/libvirt# virsh start centos-00

root@OCTEONTX:/data/libvirt# virsh list --all

Id Name State

---------------------------

30 centos-00 running

# 将虚拟机分别连接网桥vm-net、br-net和br-m。

root@OCTEONTX:/data/libvirt# ip link add centos-if-in type veth peer name centos-if-in-sw

root@OCTEONTX:/data/libvirt# ip link add centos-if-ou type veth peer name centos-if-ou-sw

root@OCTEONTX:/data/libvirt# ip link add centos-m type veth peer name centos-m-sw

root@OCTEONTX:/data/libvirt# ip link set dev centos-m up

root@OCTEONTX:/data/libvirt# ip link set dev centos-m-sw up

root@OCTEONTX:/data/libvirt# ip link set dev centos-if-in up

root@OCTEONTX:/data/libvirt# ip link set dev centos-if-in-sw up

root@OCTEONTX:/data/libvirt# ip link set dev centos-if-ou up

root@OCTEONTX:/data/libvirt# ip link set dev centos-if-ou-sw up

root@OCTEONTX:/data/libvirt# ovs-vsctl add-port vm-net centos-if-in-sw

root@OCTEONTX:/data/libvirt# ovs-vsctl add-port br-net centos-if-ou-sw

root@OCTEONTX:/data/libvirt# ovs-vsctl add-port br-m centos-m-sw

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-if-in --config

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-if-in --live

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-if-ou -m --config

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-if-ou -m –live

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-m -m --config

root@OCTEONTX:/data/libvirt# virsh attach-interface centos-00 --type direct --source centos-m -m --live

- 4.2.3 在智能网卡侧的虚拟机上配置防火墙规则

# 配置虚拟机各个网卡的IP地址。

root@OCTEONTX:~# virsh console centos-00

Connected to domain centos-00

Escape character is ^]

[root@firewall ~]# ip link set dev eth0 up

[root@firewall ~]# ip link set dev eth1 up

[root@firewall ~]# ip link set dev eth2 up

[root@firewall ~]# ip add add dev eth0 172.0.0.1/24

[root@firewall ~]# ip add add dev eth1 10.0.0.45/24

[root@firewall ~]# ip add add dev eth2 192.168.5.155/24

[root@firewall ~]# ip route add default via 10.0.0.1 dev eth1

# 开启虚拟机的报文转发功能。

[root@firewall ~]# echo '1' > /proc/sys/net/ipv4/ip_forward

# 设置防火墙的测试规则:丢弃实例172.0.0.100的所有报文。

[root@firewall ~]# iptables -nvL

Chain INPUT (policy ACCEPT 332K packets, 135M bytes)

pkts bytes target prot opt in out source destination

Chain FORWARD (policy ACCEPT 7158 packets, 545K bytes)

pkts bytes target prot opt in out source destination

7305 544K DROP all -- * * 172.0.0.100 0.0.0.0/0

Chain OUTPUT (policy ACCEPT 20823 packets, 1740K bytes)

pkts bytes target prot opt in out source destination

# 设置防火墙的SNAT规则。

[root@firewall ~]# iptables -nvL -t nat

Chain PREROUTING (policy ACCEPT 11048 packets, 828K bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 16 packets, 784 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 9639 packets, 725K bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 9639 packets, 725K bytes)

pkts bytes target prot opt in out source destination

6188 470K SNAT all -- * eth1 172.0.0.0/24 0.0.0.0/0 to:10.0.0.45

- 4.2.4 验证卸载结果

# 在centos-00上Ping位于业务网络上的“外网网关”10.0.0.1,无法通信。

[root@centos-00 ~]# route -n

Kernel IP routing table

Destination Gateway Genmask Flags Metric Ref Use Iface

0.0.0.0 172.0.0.1 0.0.0.0 UG 0 0 0 eth0

172.0.0.0 0.0.0.0 255.255.255.0 U 0 0 0 eth0

192.168.5.0 0.0.0.0 255.255.255.0 U 0 0 0 eth1

[root@centos-00 ~]# ping 10.0.0.1 -c 4

PING 10.0.0.1 (10.0.0.1) 56(84) bytes of data.

--- 10.0.0.1 ping statistics ---

4 packets transmitted, 0 received, 100% packet loss, time 2999ms

[root@centos-00 ~]#

# 在centos-01上Ping位于业务网络上的“外网网关”10.0.0.1,通信正常。

[root@centos-01 ~]# route -n

Kernel IP routing table

Destination Gateway Genmask Flags Metric Ref Use Iface

0.0.0.0 172.0.0.1 0.0.0.0 UG 0 0 0 eth0

172.0.0.0 0.0.0.0 255.255.255.0 U 0 0 0 eth0

192.168.5.0 0.0.0.0 255.255.255.0 U 0 0 0 eth1

[root@centos-01 ~]# ping 10.0.0.1 -c 4

PING 10.0.0.1 (10.0.0.1) 56(84) bytes of data.

64 bytes from 10.0.0.1: icmp_seq=1 ttl=63 time=1.07 ms

64 bytes from 10.0.0.1: icmp_seq=2 ttl=63 time=1.04 ms

64 bytes from 10.0.0.1: icmp_seq=3 ttl=63 time=1.04 ms

64 bytes from 10.0.0.1: icmp_seq=4 ttl=63 time=1.04 ms

--- 10.0.0.1 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3003ms

rtt min/avg/max/mdev = 1.042/1.052/1.075/0.041 ms

[root@centos-01 ~]#

4.3 基于容器的SSL加解密卸载

本小节的所有操作,都是基于4.1小节的配置环境进行,因此基础的操作步骤不再赘述。

- 4.3.1 在宿主机侧启动两台虚拟机,并分别连接到管理网和业务网

# 修改xml文件,将4.1小节创建的虚拟机重命名后用作WEB后端。

[root@asterfusion ~]# virsh define WEB-00.xml

[root@asterfusion ~]# virsh define WEB-01.xml

[root@asterfusion ~]# virsh start WEB-00

[root@asterfusion ~]# virsh start WEB-01

[root@asterfusion ~]# virsh list --all

Id Name State

----------------------------------------------------

13 WEB-00 running

14 WEB-01 running

[root@asterfusion ~]#

- 4.3.2 将宿主机侧的两台虚拟机配置为WEB后端

# 分别在两台虚拟上安装httpd服务并创建index页面。

# WEB-00:

[root@WEB-00 ~]# getenforce

Disabled

[root@WEB-00 ~]# yum update && yum install -y httpd

[root@WEB-00 ~]# cd /var/www/html/

[root@WEB-00 html]# echo "I'm end server: 172.0.0.100" > index.html

[root@WEB-00 html]# systemctl restart httpd

[root@WEB-00 html]# systemctl enable httpd

# WEB-01:

[root@WEB-01 ~]# getenforce

Disabled

[root@WEB-01 ~]# yum update && yum install -y httpd

[root@WEB-01 ~]# cd /var/www/html/

[root@WEB-01 html]# echo "I'm end server: 172.0.0.200" > index.html

[root@WEB-01 html]# systemctl restart httpd

[root@WEB-01 html]# systemctl enable httpd

- 4.3.3 在智能网卡侧创建两个网桥用于前后端网络IP的挂载

# 将卸载SSL的容器前端IP设为10.0.0.50/24,后端IP设为172.0.0.50/24。

root@OCTEONTX:~# ip link add nginx-host type veth peer name nginx-ovs

root@OCTEONTX:~# ip link set dev nginx-host up

root@OCTEONTX:~# ip link set dev nginx-ovs up

root@OCTEONTX:~# ip link add proxy-host type veth peer name proxy-ovs

root@OCTEONTX:~# ip link set dev proxy-host up

root@OCTEONTX:~# ip link set dev proxy-ovs up

root@OCTEONTX:~# ovs-vsctl add-port br-net proxy-host

root@OCTEONTX:~# ovs-vsctl add-port br-net proxy-ovs

root@OCTEONTX:~# ovs-vsctl add-br Proxy-B -- set bridge Proxy-B datapath_type=netdev

root@OCTEONTX:~# ovs-vsctl add-br Proxy-F -- set bridge Proxy-F datapath_type=netdev

root@OCTEONTX:~# ovs-vsctl add-port Proxy-B nginx-host

root@OCTEONTX:~# ovs-vsctl add-port Proxy-F proxy-host

root@OCTEONTX:~# ip link set dev Proxy-B up

root@OCTEONTX:~# ip link set dev Proxy-F up

root@OCTEONTX:~# ip add add dev Proxy-B 172.0.0.50/24

root@OCTEONTX:~# ip add add dev Proxy-F 10.0.0.50/24

- 4.3.4 在智能网卡侧进行基于容器的SSL加解密卸载

# 准备nginx的目录以及配置文件。

root@OCTEONTX:~# cd /data/

root@OCTEONTX:/data# mkdir nginx && cd nginx

root@OCTEONTX:/data/nginx# mkdir config data logs ssl

root@OCTEONTX:/data/nginx# ll

total 20K

drwxr-xr-x 3 root root 4.0K Sep 18 01:54 config

drwxr-xr-x 2 root root 4.0K Sep 17 08:06 data

drwxr-xr-x 2 root root 4.0K Sep 18 02:15 logs

drwxr-xr-x 2 root root 4.0K Sep 18 02:02 ssl

# 创建自签名证书。

root@OCTEONTX:/data/nginx# cd ssl/

root@OCTEONTX:/data/nginx/ssl# openssl genrsa -des3 -out server.key 2048

root@OCTEONTX:/data/nginx/ssl# openssl req -new -key server.key -out server.csr

root@OCTEONTX:/data/nginx/ssl# openssl rsa -in server.key -out server_nopwd.key

root@OCTEONTX:/data/nginx/ssl# openssl x509 -req -days 365 -in server.csr -signkey

# 准备完成后的nginx目录以及相关配置。

root@OCTEONTX:/data/nginx# tree

.

|-- config

| |-- conf.d

| | `-- default.conf

| `-- nginx.conf

|-- data

| `-- index.html

|-- logs

| |-- access.log

| `-- error.log

|-- ssl

| |-- server.crt

| |-- server.csr

| |-- server.key

| `-- server_nopwd.key

`-- start-n.sh

5 directories, 10 files

root@OCTEONTX:/data/nginx# cat data/index.html

I'm SSL Proxer

root@OCTEONTX:/data/nginx# cat config/conf.d/default.conf

upstream end_server {

server 172.0.0.100:80 weight=1 max_fails=3 fail_timeout=15s;

server 172.0.0.200:80 weight=1 max_fails=3 fail_timeout=15s;

}

server {

listen 443 ssl;

server_name localhost;

ssl_certificate /ssl/server.crt;

ssl_certificate_key /ssl/server_nopwd.key;

ssl_session_cache shared:SSL:1m;

ssl_session_timeout 5m;

ssl_protocols SSLv2 SSLv3 TLSv1.2;

ssl_ciphers HIGH:!aNULL:!MD5;

ssl_prefer_server_ciphers on;

location / {

root /usr/share/nginx/html;

index index.html index.htm;

proxy_pass http://end_server/;

proxy_set_header Host $host:$server_port;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

proxy_ignore_client_abort on;

}

# 在智能网卡的操作系统上运行nginx容器。

root@OCTEONTX:/data/nginx# docker run -d --network host --name nginx-00 -v /data/nginx/data:/usr/share/nginx/html:rw -v /data/nginx/config/nginx.conf:/etc/nginx/nginx.conf/:rw -v /data/nginx/config/conf.d/default.conf:/etc/nginx/conf.d/default.conf:rw -v /data/nginx/logs:/var/log/nginx/:rw -v /data/nginx/ssl:/ssl/:rw nginx

- 4.3.5 卸载结果验证

# 从业务网中的一台服务器访问https://10.0.0.50/,卸载成功则会返回后端WEB提供的页面。

[root@compute-01 ~]# ip a | grep -i "enp2s0f0"

8: enp2s0f0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000

inet 10.0.0.1/24 scope global enp2s0f0

[root@compute-01 ~]# curl --insecure https://10.0.0.50/

I'm end server: 172.0.0.100

[root@compute-01 ~]# curl --insecure https://10.0.0.50/

I'm end server: 172.0.0.200

5 在服务器与智能网卡中运行VNF的异同

VNF通常以虚拟机或者容器的形式进行部署。关于安装部署,对于服务器与Helium智能网卡基本没区别,只要有对应版本的可以安装运行,配置方式、命令行等基本一致。

关于软件资源,由于目前x86架构的服务器占比极高,各种操作系统、容器服务、Hypervisor软件、镜像、应用等均会提供x86版本。对于Helium智能网卡这个arm架构平台,在操作系统、容器服务、Hypervisor等方面,大多数流行的产品也已经提供了arm版本。但是,对于各种应用软件、容器镜像等只有少部分支持arm版本,如果客户原先跑在x86平台的VNF软件没有arm版本,则需要先由研发完成移植、测试等工作。

移植工作涉及到代码层面,因此一定是需要研发进行的。因为从x86向arm进行代码移植有两个方面的问题,一是这两种CPU在处理某些类型的溢出时,行为不同,二是这两种CPU采用不同的指令集,即复杂指令集与精简指令集,因此他们的机器指令不能完全一一对应,如果项目嵌入汇编进行加速,则代码的移植会更麻烦。

6 验证总结与建议

6.1 智能网卡VNF卸载解决方案的验证总结

通过前文所述的验证测试操作,证明Helium智能网卡可以完成对OVS的卸载、对基于虚拟机的VNF(vFW)功能的卸载、对基于容器的VNF(SSL加解密)功能的卸载。未来再配合Helium智能网卡SoC的协处理器,不仅能对VNF进行卸载,还能进一步提升VNF应用的处理性能。

6.2 智能网卡在运维体验方面的一些建议

1.智能网卡操作系统的默认硬盘分区给根目录的空间不够,很容易用满,建议系统给根目录更大的容量,或者引入逻辑卷机制方便客户根据情况灵活调整各分区容量。

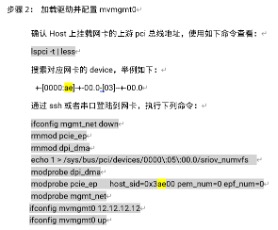

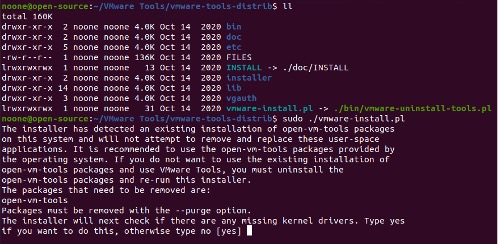

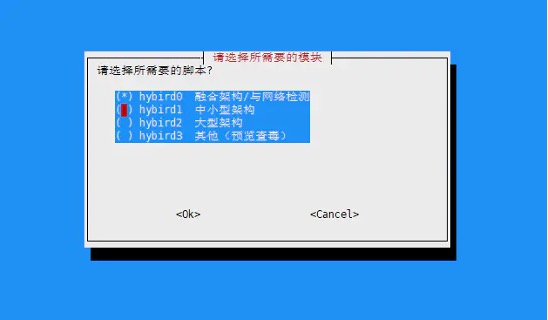

2.初始化网络配置与安装智能网卡驱动程序的过程,是否可以进一步优化,对运维人员将一步步的命令行操作屏蔽掉,使用交互的命令行或图形化脚本的方式进行安装。

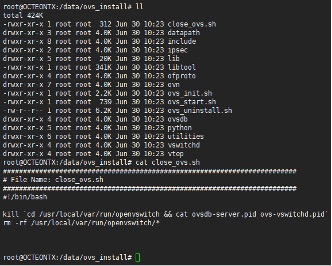

#现有安装方式的部分步骤:

#交互式命令行或图形化脚本示例(使用交互式命令行安装的vmware-tools与图形化示例):

3.在宿主机上卸载智能网卡的驱动时,会使得智能网卡重启,是否可以进一步优化,在宿主机上进行卸载或更新驱动的操作时不用让智能网卡重启一次。

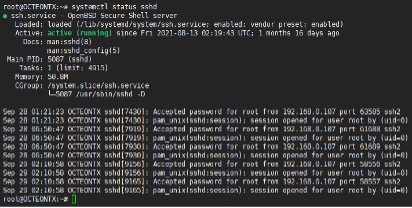

4.目前智能网卡中OVS安装后,进程的启停操作通过定制的脚本完成,是否进一步优化,当完成OVS的安装后使用systemd来管理OVS的服务进程。

# 目前OVS服务进程的启停通过Shell脚本完成:

# 智能网卡系统中,使用systemd管理的服务示例(SSH服务):

如有其它问题,请填写右侧需求表单联系我们。www.asterfusion.com

更多产品信息:Helium DPU网卡