-

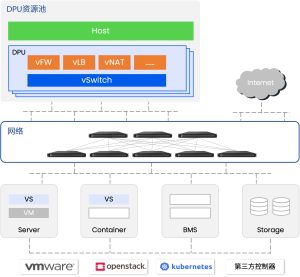

服务器CPU负责管理面业务及部分实时性要求不高的复杂计算业务

-

Helium DPU负责网络数据转发面和控制面业务,并通过硬件加速协处理器进行加速处理

-

多块Helium DPU存储的数据通过PCIe共享到同一台服务器,实现资源共享

-

所有资源由云管平台纳管,完成计算、网络资源的统一管理和按需分配

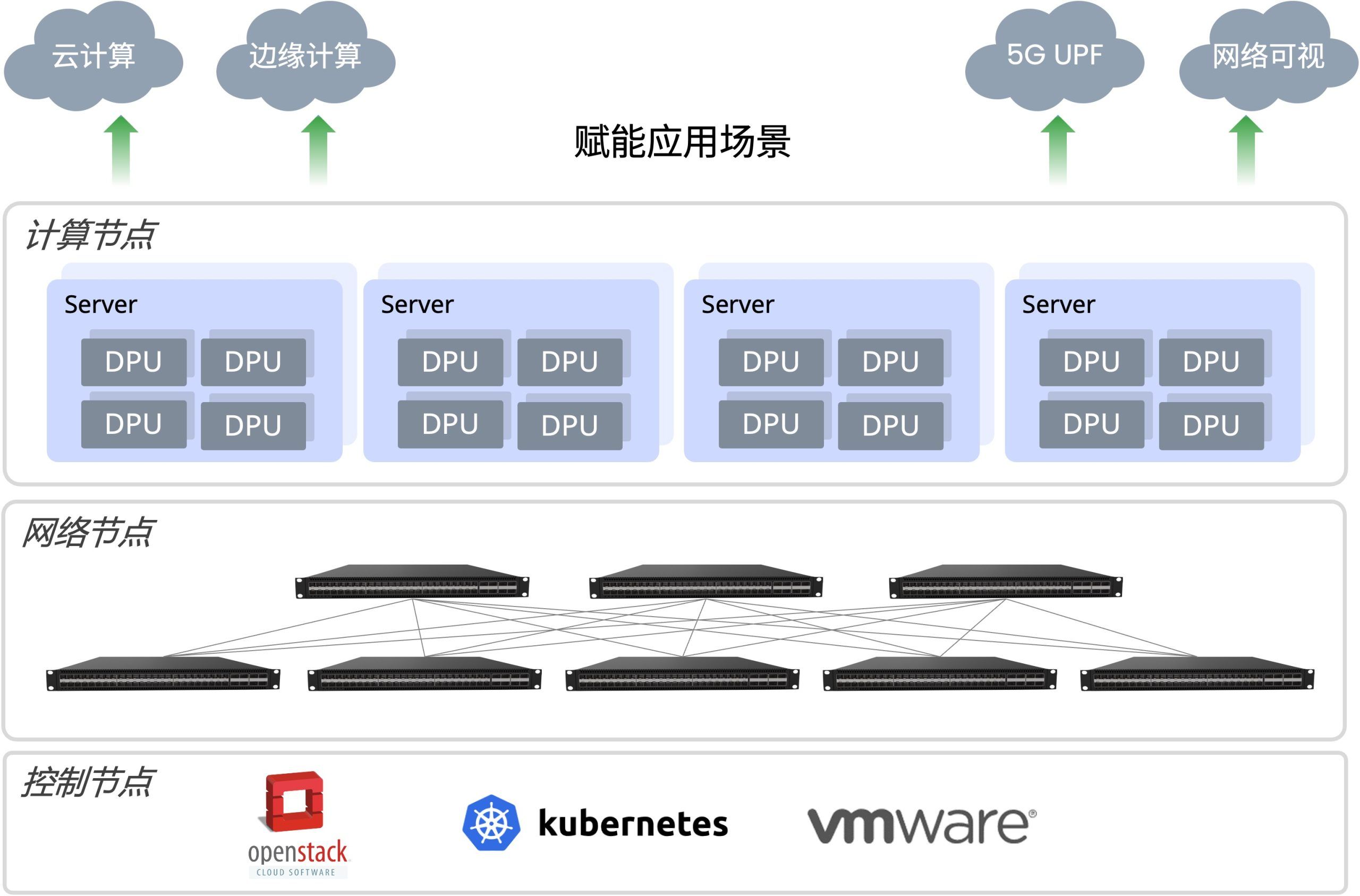

Helium DPU资源池解决方案采用标准服务器+多块Helium DPU卡的形式为客户打造高性能算力资源池。其中DPU卡负责网络数据转发及大部分计算类业务,服务器CPU完成控制面以及实时性要求不高的复杂计算业务,并且将原本独立部署在各个服务器的网络功能池化到各块DPU卡上,进而实现优化资源分配,简化运维管理的目标

降低总体拥有成本

- 通过标准物理服务器+DPU 智能网卡替代传统纯服务器的建设方案,可节省最多2/3机架空间,节省客户后期最高2/3的能耗支出。

- 由服务器CPU完成所有网络设备的管理面功能,智能网卡负责数据面及部分控制面功能,可实现存算分离、资源共享,大幅度提升计算资源管理分配效率,缩短管理配置和资源分配周期,减少客户在运管方面的投入。

提高投资回报率

- 通过智能网卡硬件卸载数据面处理业务,实现数据处理效率的提升,为客户业务提供高性能、大带宽、低延时的网络环境;同时采用资源池方案,保证算力扩展更加灵活,客户业务不必受限于网络和计算资源瓶颈,实现快速发展。

- 解决方案基于开源开放的生态及全套的软件开发环境,客户移植应用的周期≤7天,开发周期缩短一半,可保证客户业务快速上线,避免因开发周期过长造成的损失,保证对市场需求的及时响应。

方案亮点

提高单位空间算力上限, 以处理vFW为例,2U尺寸的24核X86服务器处理性能为120Gbps,而2U服务器+8块DPU卡的处理性能为480Gbps,在同等的空间内实现了4倍的性能提升

卸载加速虚拟网络,Helium DPU智能网卡支持DPDK、VPP加速包处理框架,同时内置包解析、加解密、压缩解压缩、QoS等硬件加速引擎。可针对虚拟网络及NFV进行卸载加速,有效提升虚拟网络性能,满足5G、AI/ML等业务对网络的要求

缩短应用开发周期,Helium DPU卡为客户准备好了全套的开发套件,客户无需关注底层开发环境,即可进行上层应用的开发及移植

最佳实践

边缘计算

5G时代基础网络设施迎来又一波现代化改造,随着物联网、智能驾驶等业务的兴起,算力在边缘的需求愈演愈烈,运营商及云服务商纷纷将工作负载及服务从核心迁移到边缘。但边缘机房受限于空间、能耗等限制,无法进行大规模的算力扩展,只能承载有限的计算业务,无法满足日益增长的算力需求。

采用DPU资源池方案承载5G边缘网络业务,可降低边缘机房运营成本,同时提供更高效的算力扩展。此外,DPU资源池方案还可满足超大带宽、超低延时、海量接入的边缘网络要求,赋能IoT、智能驾驶、VR/AR等边缘需求业务。

云计算

云计算场景下,云服务商采用CPU软件模拟的方式实现虚拟网络及虚拟网络功能。这种实现方式虽然保证了云计算对资源灵活管理和分配的需求,但也极大的提高了“数据中心税”。并且软件模拟实现的网络功能性能较低,如需保证高性能的网络服务,又必须增加设备投入,带来成本的增加。

采用DPU资源池方案,硬件卸载云网OVS及VNF,由Helium DPU卡进行加速处理,可以有效降低“数据中心税”,实现超高性能、按需扩展的云计算网络服务。

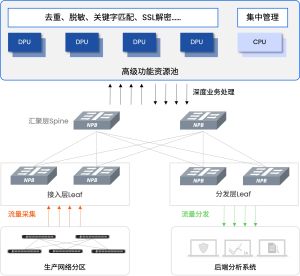

可视网络前端

随着各行各业客户线上业务的发展壮大,业务对网络的监管与安全需求进一步提升,为可视网络部署带来更多挑战。为满足后端系统的监控需求,输出定制化的数据源,可视网络前端通常需要部署高级功能设备来进行深度业务处理,比如去重、脱敏、关键字匹配等。但传统高级业务处理与基本汇聚分流绑定的方案,带来了大量的资源浪费,且无法实现高级功能业务的按需分配及灵活扩展。

采用DPU资源池方案,将可视网络前端的高级功能业务进行池化,分解到Helium DPU卡上完成,可以实现高级功能业务的独立部署、按需分配、灵活扩展,降低客户总体拥有成本。

运营商信令关联打标

运营商信令监测业务需要对5G移动核心网的各接口的信令协议进行解码及跟踪识别,并以此为基础,提取和还原指定的信令报文。传统的信令解决方案通常采用集成高性能计算模块的框式分流设备进行一体化处理,但该解决方案存在一系列问题。

Helium DPU卡通过搭载我司智能分流操作系统,可支持丰富的移动互联网特性,支持3GPP、3GPP2规范中的相关信令报文的识别和分流处理:

- 4G网络S11口、S1-MME/S1-U/S6a等接口协议的识别

- 5G网络N2/N3/N4/N8/N11/N12等接口协议的识别

Helium DPU单卡业务处理能力可达80Gbps,2U服务器最多支持插8块卡,整机最高可提供640Gbps的信令处理能力。采用DPU资源池方案处理运营商信令业务,可提供更高的性能、更低的建设成本、更低的功耗以及更灵活的扩展性。

近期动态

现场直击!看星融元如何探索开放网络新境界