零基础看懂 RADIUS:像“数字门卫”一样精准管理企业网络接入认证

近期文章

什么是 RADIUS 协议?网络世界的“数字门卫”

RADIUS 的定义与核心职能

为什么现代企业仍离不开 RADIUS?

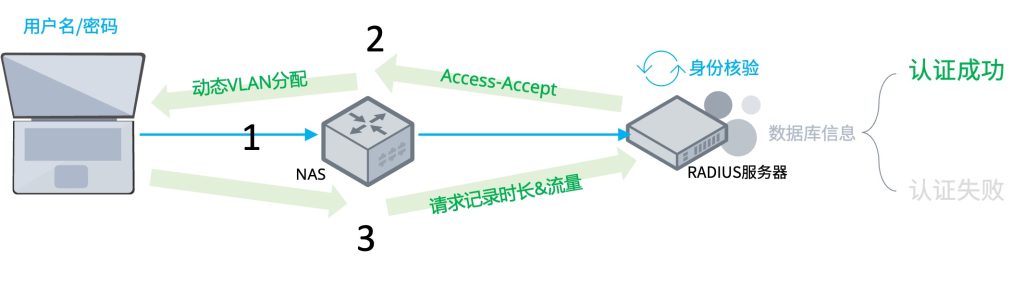

RADIUS 接入认证的工作原理详解

| 功能 | 描述 |

|---|---|

| 认证 (Authentication) | 确认你是谁。检查你的用户名和密码(或其他凭据)是否正确。 |

| 授权 (Authorization) | 决定你能干什么。比如,普通员工只能访问内网,而管理员可以访问核心服务器。 |

| 计费 (Accounting) | 记录你干了什么。统计你的上线时间、流量使用情况,或者单纯记录登录日志。 |

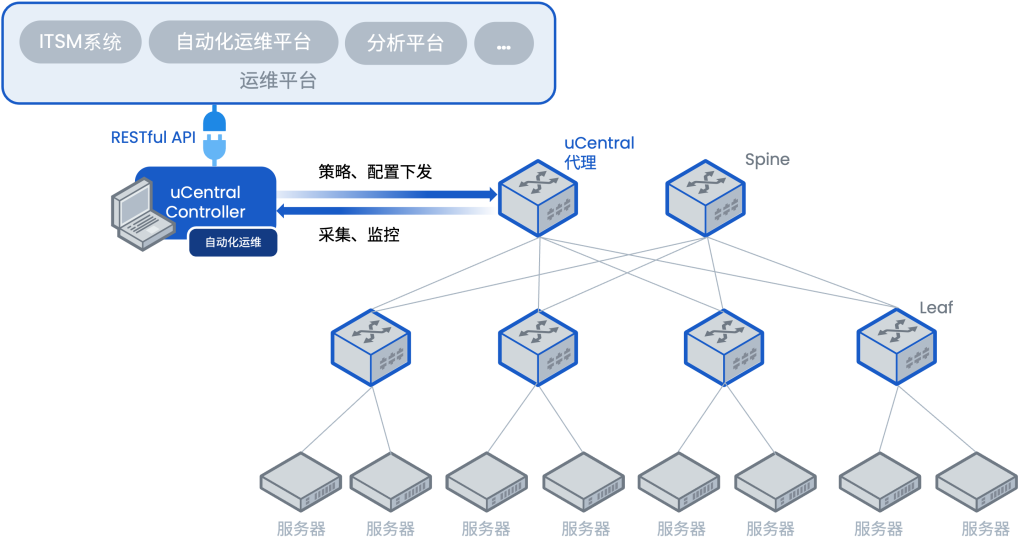

客户端/服务器(C/S)架构的运作流程

RADIUS 采用典型的 C/S 架构,其工作逻辑可分为四个关键步骤:

1. 发起连接:用户在需要接入的网络设备(如Wi-Fi)上输入用户名和密码。

2. 客户端转发请求:网络接入设备(NAS),例如无线控制器、交换机等,作为RADIUS的客户端,将用户的认证信息打包成”认证请求包”发送给RADIUS服务器。(这一步中,用户密码会经过加密处理)

3. 服务器核验身份:RADIUS服务器接收到请求后,会检查用户信息是否与自己的数据库匹配。

- 认证成功:如果信息正确,服务器会返回”认证接受包”。这个包里不仅包含”允许接入”的指令,还会附带用户的授权信息(如网络权限),RADIUS将认证和授权合并为一步。

- 认证失败:如果信息错误,服务器返回”认证拒绝包”,拒绝用户接入。

4. 执行授权与计费:RADIUS客户端(NAS)根据服务器返回的指令执行操作,允许或拒绝用户。如果允许接入,客户端还会向服务器发送”计费开始请求”,服务器确认后开始记录。当用户断开连接时,计费停止。

核心应用场景:企业级 Wi-Fi 与 802.1X

在现代办公环境中,RADIUS 配合 802.1X 认证框架实现了精细化的权限管理 。这种方案不再依赖单一的共享密钥,而是让每个用户拥有独立的账号。

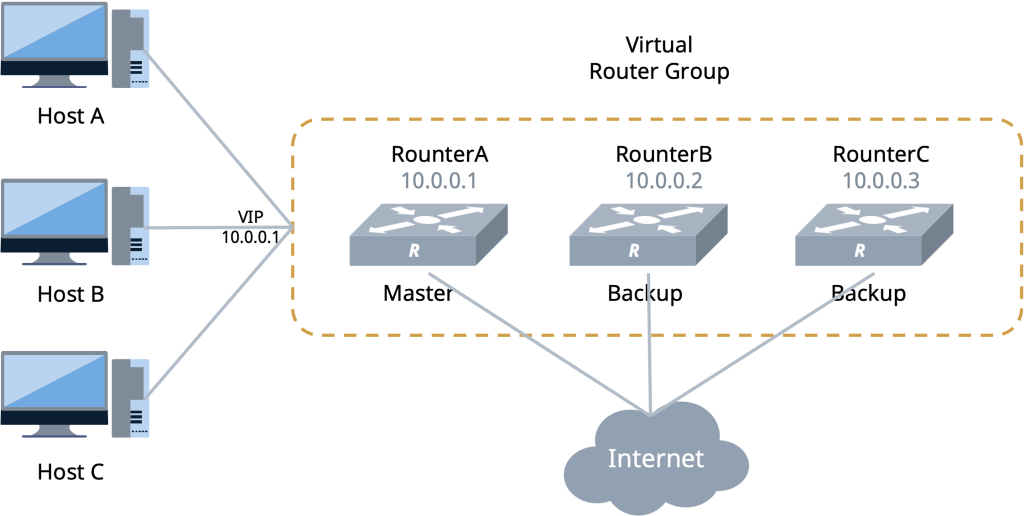

无线接入中的三个关键角色

- 申请者(Supplicant): 员工的笔记本或手机,需运行支持 802.1X 的客户端。

- 认证者(Authenticator): 通常指无线接入点(AP),在通过验证前拦截访问请求并转发身份信息。

- 认证服务器(Authentication Server): 即 RADIUS 服务器,负责核实凭证并告知 AP 是否放行。

此外,RADIUS 还常用于双因素认证(MFA)场景,为企业网络额外增加一道锁。

核心应用场景:双因素认证(MFA)

在传统的认证中,RADIUS 仅核对“用户名 + 密码”。但在 MFA 场景下,RADIUS 协议被扩展用于处理多阶段验证。

企业 VPN 远程接入安全

这是 RADIUS MFA 最广泛的应用。

- 现状:仅靠静态密码极易被暴力破解或因员工泄露而失守。

- 解决方案:VPN 网关作为 RADIUS 客户端 ,将认证请求转发给集成了 MFA 插件的 RADIUS 服务器。只有当员工在手机 App 上点击“允许”后,VPN 隧道才能成功建立。

关键基础设施的 SSH 登录

对于核心服务器或交换机的管理,企业通常配置 RADIUS 认证以替代本地账户。

- 精细控制:通过 RADIUS 授权功能,可以决定该用户登录后是具备“只读”权限还是“管理员”权限。

- 安全加固:强制要求在输入密码后进行动态令牌校验,防止运维账号被盗导致的大规模内网渗透。

未来网络安全的基石

无论是简单的 Wi-Fi 接入还是复杂的跨区域 VPN 办公,RADIUS 凭借其成熟的 AAA 机制和高效的接入认证流程,始终是构建安全、透明、可审计的网络准入环境的基石。