提升企业网络WiFi体验,如何科学部署无线网络?

更多相关内容

Wi-Fi 一直是企业网络的重要组成部分。对于许多企业网络环境来说,WiFi 是大多数终端设备的主要接入方式。当终端用户连接到一个稳定的无线局域网时,最好的感知就是没有感知——因为一切都能顺畅运行。这就意味着无线局域网必须可靠,其设置必须能够支持运营目标,而这些目标可能因个别网络情况而异。

无线接入点的部署

任何无线局域网的成功配置都取决于从物理和逻辑角度对组成网络的接入点进行的科学布置。通常情况下,我们需要关注以下几点:

以空间需求和业务目的驱动 Wi-Fi 规划和设备选型

好的 Wi-Fi 设置并不是随随便便就能实现的,尤其是在大型或技术复杂的环境中。有时,IT 团队会将无线接入点(AP)安装在简单方便的区域,而不是将接入点放置在需要达到最佳性能的地方。一旦出现这种情况,最终用户体验不佳几率就会成倍增加。

不同的网络目的通常会产生不同的网络设计和接入点布局。例如,使用基于 Wi-Fi 的定位服务、提供访客访问的WLAN和为终端提供服务的 WLAN 会产生不同的设计,正确的 Wi-Fi 接入点布置取决于每个网络设置的政策、具体情况和运营目标。

灵活规划无线接入点的物理位置

不同组织在规划无线接入点的布置和物理安全时并没有一套统一的指导方针或建议可供遵循。比如有些环境需要带锁的机柜或单独的隔绝外部的空间。而在另一些环境中,机柜则是一种浪费,因为机柜的成本甚至都会高于无线接入点本身,或者已有安全摄像头覆盖了该区域,或者该空间本就不对公众开放。

在放置无线接入点时,经常出现的错误是过分关注隐藏无线AP,这使得以后很难对其进行维护。另一个错误是将接入点安装在易受攻击的区域,它们可能会被容易被非官方人员操作修改或被机器或其他设备以外撞到。

根据业务类型考虑接入点的合理布局

如今,大多数无线网络都是多用途的,它们可能会生成不同的SSID分别用于提供语音服务,供访客或受管理的企业笔记本电脑接入使用,但所有这些其实都由相同的接入点设备提供服务。每个 SSID 通常相当于一个特定的虚拟局域网,需要根据使用该 SSID 的客户类型进行安全配置。

严格控制设备管理权限

在企业网络环境中,很少会在客户端设备使用的网络上管理 AP。AP、交换机、闭路电视摄像机和一系列其他设备通常在严格控制的 IP 地址空间内进行管理,无论是使用防火墙还是访问控制列表,这些设备通常都与互联网和网络的其他部分隔绝,只有一小部分管理员可以访问这些设备,而且只有在满足双因素身份验证要求后才能访问。

监测非法接入点

无论 WLAN 如何满足操作要求,有些人可能会将无线路由器或 AP 连接到企业网络内的局域网,而他们根本没有必要这样做。个人的无知、对政策的无视或纯粹的恶意都可能促使非法无线网络设备的加入。无论这些设备出现的原因是什么,都必须提前制定应对策略。哪怕不并非寻找安全漏洞,不受控的无线接入点也会产生高强度干扰,阻碍合法用户使用企业 Wi-Fi 系统。

要最大限度地减少非法接入设备的出现,首先要制定并传达明确的政策。在这之后检测是关键,这就需要持续监控 Wi-Fi 频谱,查找可疑的信号来源。

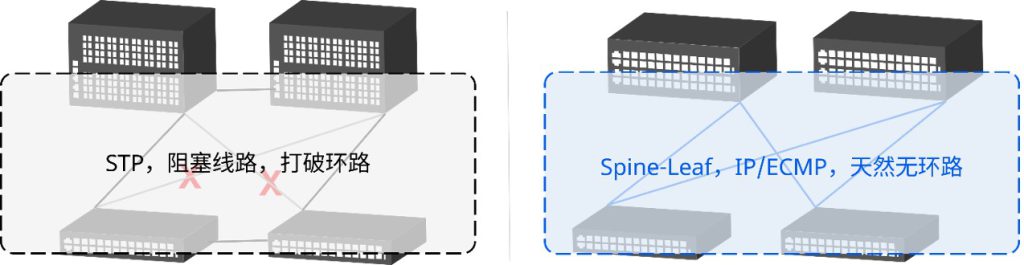

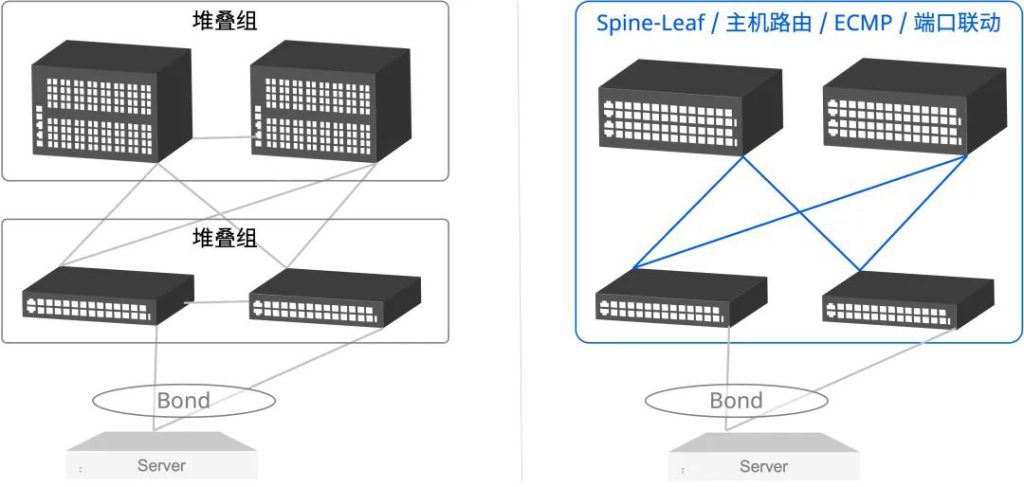

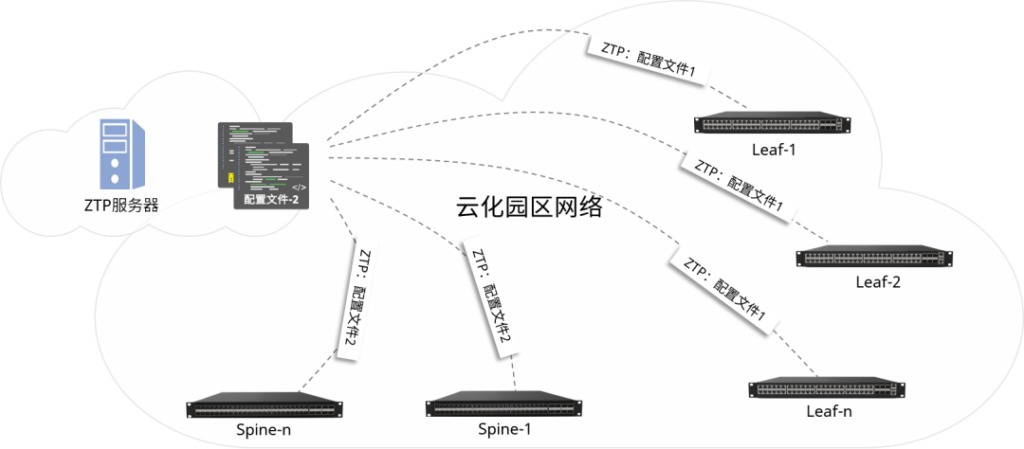

更深层次的优化思路——架构升级

在无线接入点部署以外,我们也可以深层次地从网络架构的优化来提升无线网络的使用体验,并简化企业网络中的安全管理。例如采用分布式网关提升无线漫游的效率,简化前期部署和后期的动态维护工作。此外,架构本身自带的内生安全特性也可大大减少手动配置安全策略等枯燥又易错的运维工作。

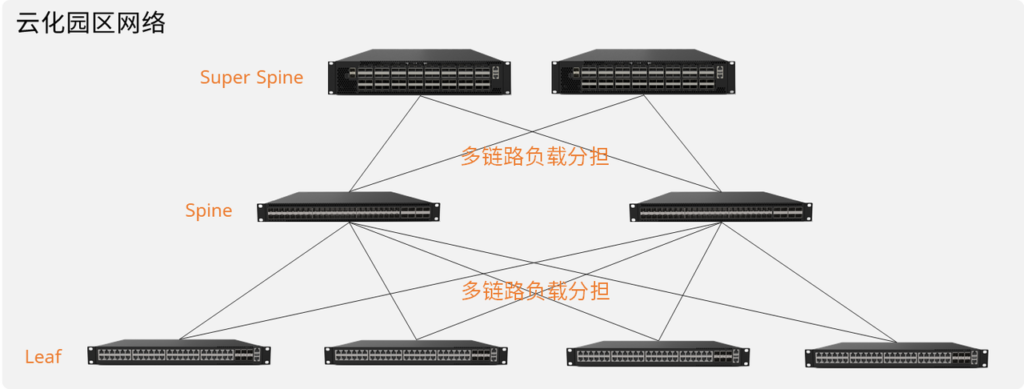

什么是分布式网关?

星融元云化园区网络解决方案搭建是一个全三层的IP网络,一个子网的网关会以分布式的形式存在于每一个接入交换机上。它充分利用每一个接入层设备的能力,所有的跨子网转发动作在最近的分布式网关上完成,让网关功能不再成为压垮网络中某一台设备的潜在风险,同时大幅度提升整网的转发效率。

-图1.png)

对比传统的无线方案,设备发生AP漫游后的流量不再需要绕道转发,也无需在配置前期考虑网络划分的问题——网络管理员只需要在网络初始化时一次性配置好所有分布式网关的信息即可,无需在运行过程中动态调整,进一步降低运维的复杂度。

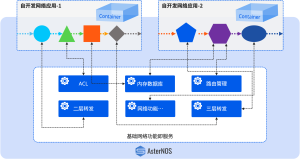

接入终端安全控制

结合认证系统和内生安全特性,星融元云化园区网络可以提供多种接入终端安全管理能力,智能保障园区网络的安全性。例如:交换机将主动跟踪任何接入终端与DHCP服务器之间的交互过程,并自动学习设备信息,非法终端产生的网络流量将在接入端口被直接丢弃,不再依赖手动配置安全策略。

-图2.png)

-图3-1024x220.png)

-图1.png)

-图2.png)

-图3-1024x389.png)

-图4.png)

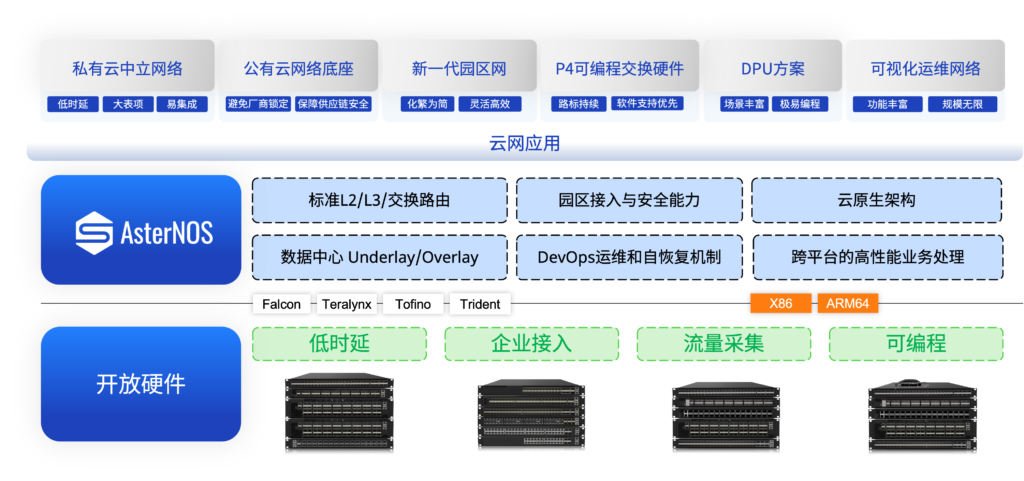

NetDevOps对网络提出了软件编程、软件定义、按需定制、运营优化的要求,而开放网络的理念与架构方法恰恰能够满足这些要求。NOS作为网络设备的“灵魂”,NetDevOps要求NOS从封闭、黑盒的体系向开放、透明的体系演进。

NetDevOps对网络提出了软件编程、软件定义、按需定制、运营优化的要求,而开放网络的理念与架构方法恰恰能够满足这些要求。NOS作为网络设备的“灵魂”,NetDevOps要求NOS从封闭、黑盒的体系向开放、透明的体系演进。

-图1-1024x486.png)

-图1.png)

随着数字化转型的需求变得日益明显,企业也需要重新考虑自身的网络基础设施。

随着数字化转型的需求变得日益明显,企业也需要重新考虑自身的网络基础设施。-图2-1024x471.png)

-图1-1024x504.png)

-图2-1024x422.png)

-图1-285x300.jpeg)

-图1.png)

-图2.png)

-图1-1024x515.png)