这款国产高性能DPU智能网卡,即将开源!

关注星融元

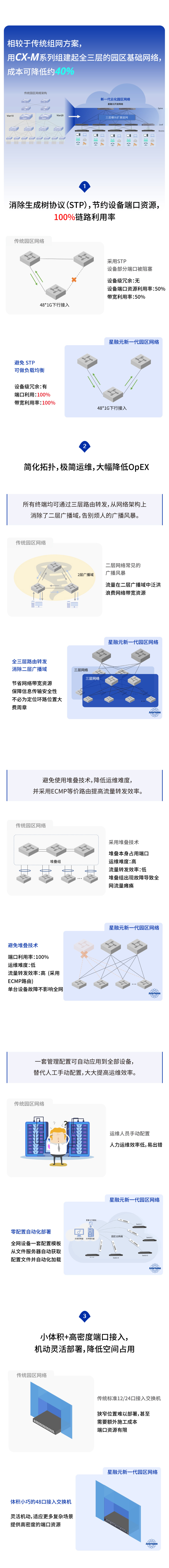

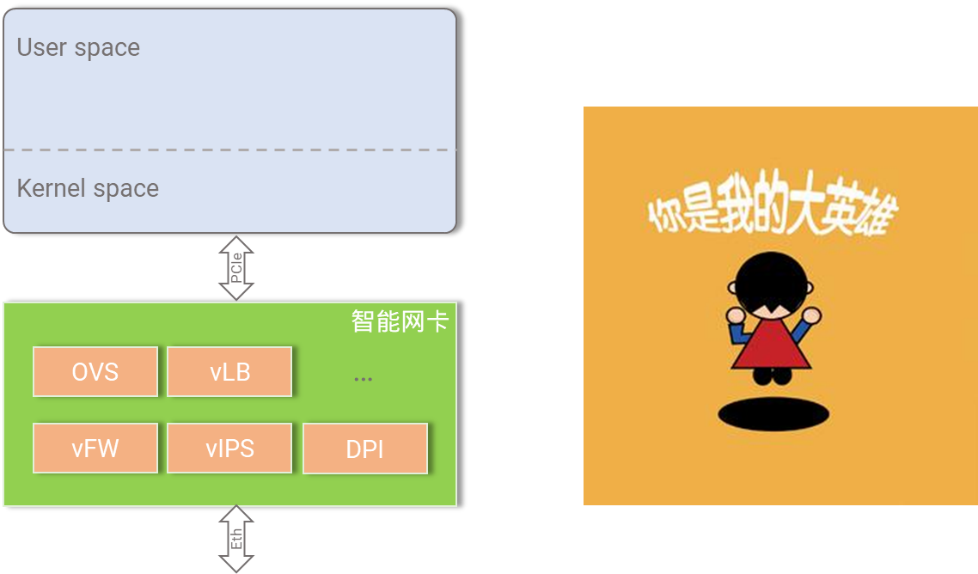

云数据中心的优化方向:从传统网卡升级到DPU架构的智能网卡

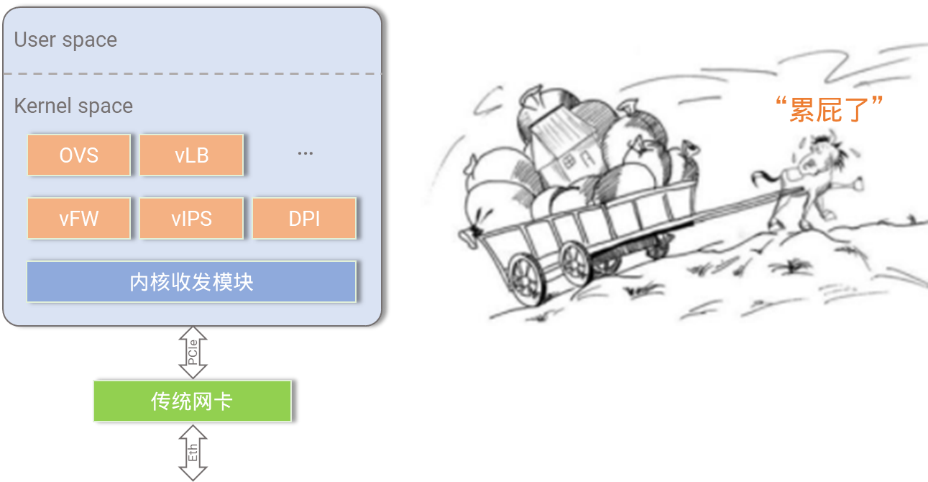

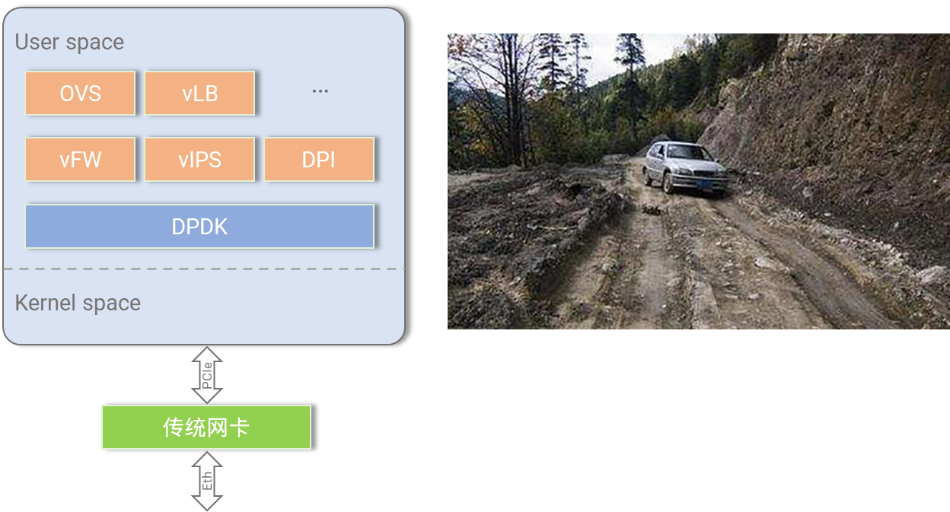

我们知道,各类智能网卡在服务器集群中的大规模部署,可以进一步降低数据中心建设和运营成本,更好地将服务器资源货币化。但仅从网卡层面来看,这个方案还存在不少优化空间。

- OVS卸载不完全。传统的智能网卡仅负责OVS转发面卸载,但控制面仍是主机CPU处理,所以需要去定义Host CPU的控制面和卸载到网卡上的数据面业务之间的传输接口和协议,实现起来比较复杂,定位问题困难;

- 虚拟网络功能卸载到网卡的难度大,很多网络功能(例如vLB,vNAT等)仍然在服务器上运行;

- 无法实现存储加速和扩展,造成了服务器的性能瓶颈;

- 部分传统网卡根本不具备编程能力,或者对芯片的编程难度大且生态缺失,开发门槛高,难以满足多样且多变的云业务需求。

全开放架构的DPU的智能网卡——星融元 Helium 系列

| Helium EC2004Y | Helium EC2002P | |

|---|---|---|

| 网络接口 | 4 x 25GE SFP28 | 2 x 100GE SFP28 |

| 主机接口 | PCIe x 8 Gen4.0 | PCIe x 16 Gen4.0 |

| 管理口 | 1 x Console Micro USB, 1 x GE RJ45 | 1 x Console Micro USB, 1 x GE RJ45 |

大Server中的小”Server”,帮助卸载服务器CPU负载

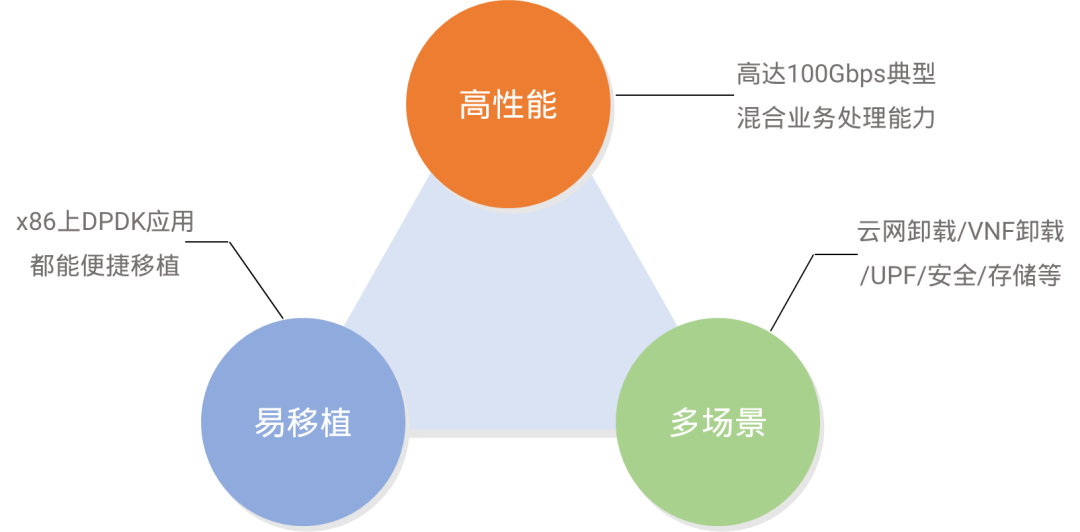

Helium 系列智能网卡采用DPU架构,集成了24核ARM和多样化的硬件加速协处理器,性能足够高,可以直接在网卡上运行各种网络功能虚拟化功能,释放宝贵的服务器资源。

Helium的典型业务性能数据参考:

- 纯转发:100Gbps线速转发(128字节包)

- OVS卸载性能:80Gbps

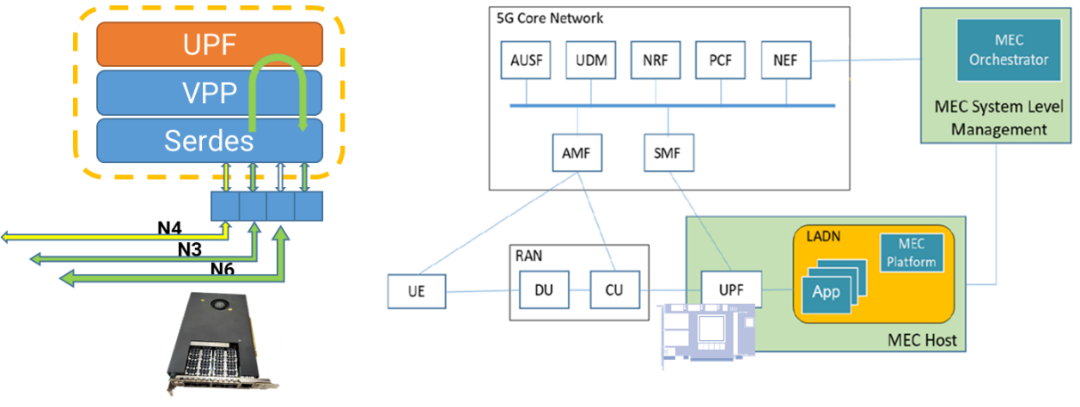

- 5G UPF性能:80Gbps

- IPsec性能:50Gbps

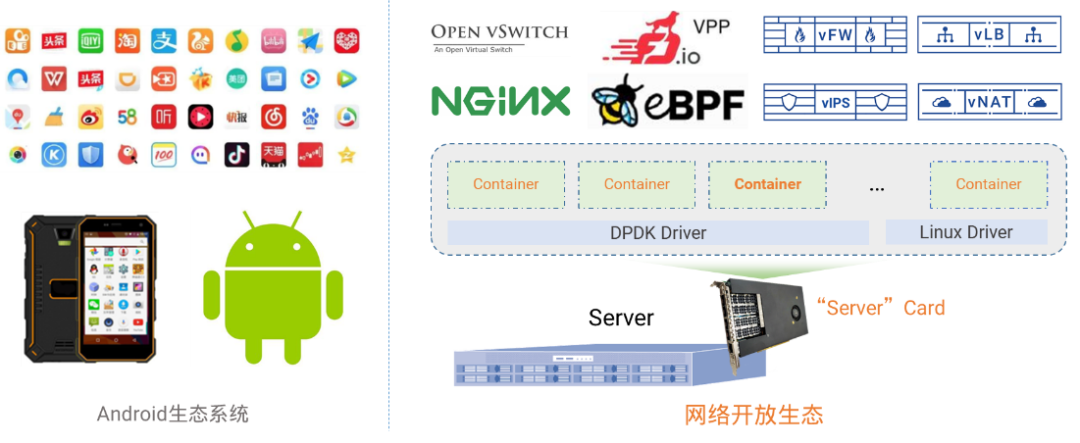

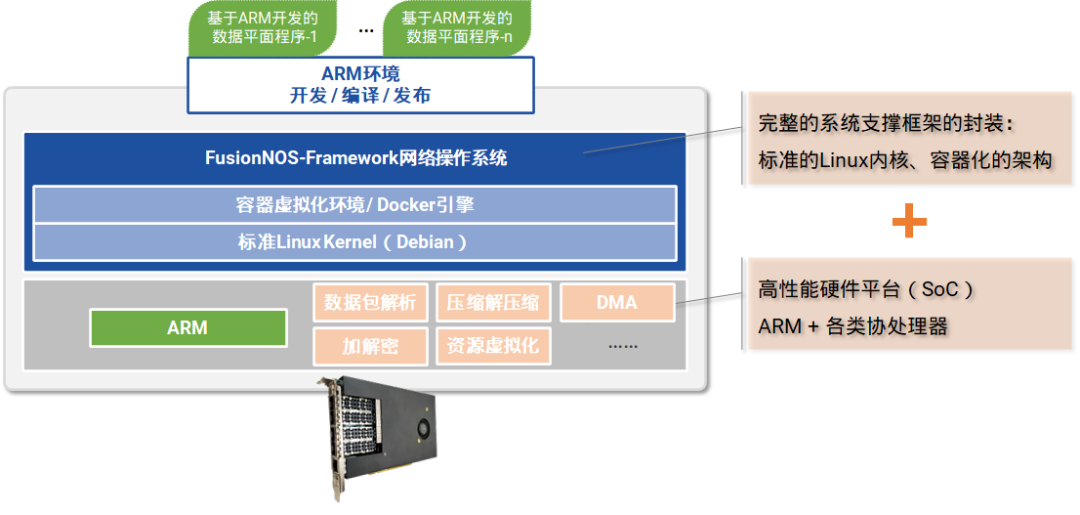

高度开源的软件架构, 打造开放兼容、自主可控的生态系统

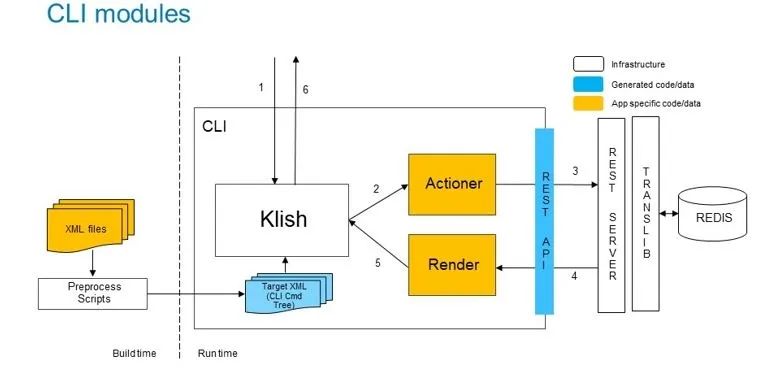

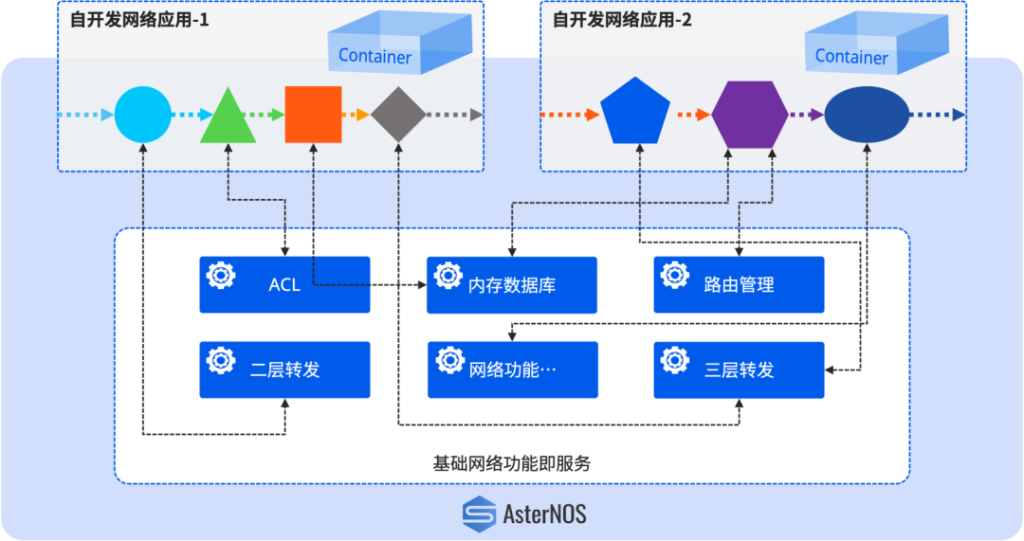

在通用的高性能硬件平台之上,星融元还提供了一套开放的软件开发环境——标准Linux内核+容器化架构,以及额外的DPDK/VPP开发套件(包含了最佳网络和安全处理所需的所有库和 API)。客户可以不考虑底层支撑框架直接开发上层应用;原先跑在x86上的DPDK应用和其他应用仅需简单编译便可移植到Helium DPU智能网卡上,并且按需组合使用。

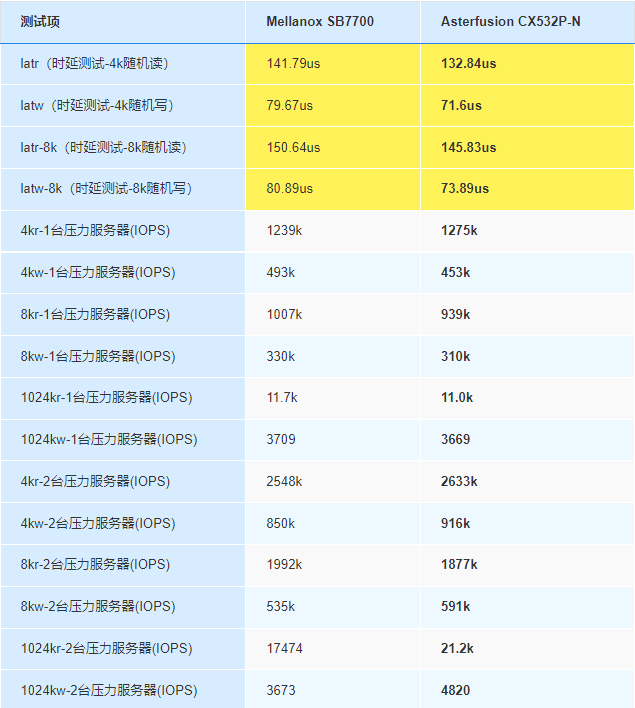

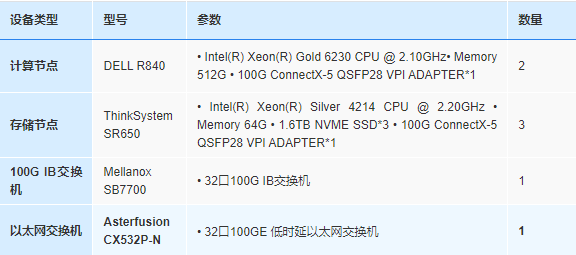

支持存储加速和远端云盘挂载,满足服务器灵活扩展存储的需求

支持SPDK软件加速、NVMe-oF(TCP)卸载,可缩短存储I/O路径、提高存储读写性能

大幅降低数据中心整体建设和运营成本

以某客户场景为例。在保证总接入用户数量的前提下,引入Helium智能网卡的建设方案相对于纯2U服务器的建设方案在机架空间占用、总功耗、成本上都具有明显优势。其中机架空间节省超过2/3,总功耗节省超过1/2,建设成本节省8万,同时机架平均每U接入的用户数有3倍以上的提升。

Helium DPU智能网卡上的应用性能表现

1、Open vSwitch(OVS)的全卸载

Helium智能网卡采用高性能DPU芯片,具备独立的CPU和内存,可轻松实现百万级流表以及OVS控制面和转发面的全卸载,无缝融入虚拟网络。

| 包长(字节) | 流量数 | 最大性能(Gbps) |

|---|---|---|

| 64 | 10K | 7 |

| 128 | 10K | 14 |

| 256 | 10K | 19 |

| 512 | 10K | 21 |

| 512 | 64K | 20 |

| 512 | 2M | 18 |

| 1024 | 10K | 25 |

2、硬件加速的网络功能虚拟化(NFV)卸载,性能远超x86服务器软件模拟

通过以下数据可以发现,在提供了更低转发时延和更高流新建会话数的情况下,Helium DPU智能网卡的功耗仅为服务器的1/6,购买成本节省超过1/3。

Helium DPU智能网卡与当前市面上的智能网卡对比

对比FPGA架构智能网卡

| FPGA架构智能网卡 | Helium DPU 智能网卡 | |

|---|---|---|

| 开发难度 | 开发难度较高,需厂商高度支持 | 标准Linux+容器化架构,额外的DPDK软件开发套件,易开发易移植 |

| 处理性能 | 集成了多核CPU,但核数有限(最高规格为16核,一般厂家平均为4或者8核),无法承载复杂的控制面功能 | 24核ARM处理器,多种硬件协处理器加速,可支持复杂的控制面业务卸载 |

| 采购成本 | FPGA架构核心器件的成本普遍较高,尤其是支持大容量内存的产品 | 内存可以扩展至64G,千万级会话表,性价比高 |

| 功耗对比 | 同规格的产品,功耗偏高 | 同规格的产品,功耗偏低 |

对比其他SoC架构的智能网卡

- 采用DPU架构的Helium智能网卡相比于普通的SoC架构网卡集成度更高,性能更强

- 更多的ARM核、更高的内存,支持复杂的控制面业务卸载以及千万级会话表项

- 更开放的生态,提供DPDK、VPP开发套件,标准的Linux操作系统,容器虚拟化环境,契合用户自定义的业务需求,覆盖更宽泛的应用场景。

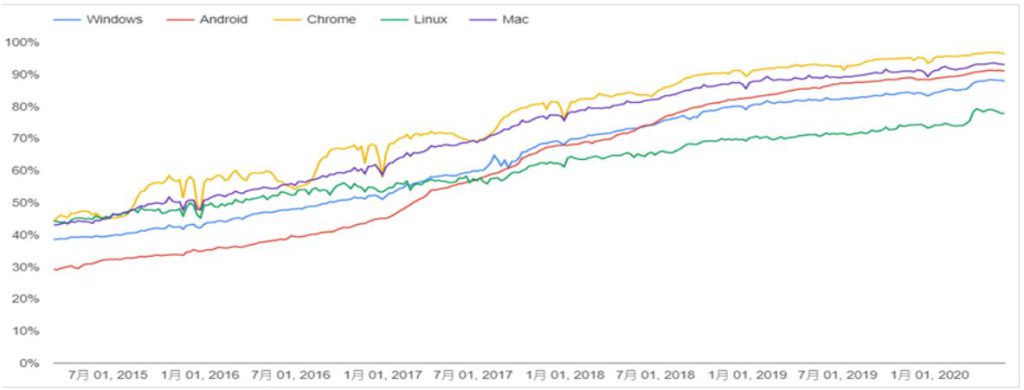

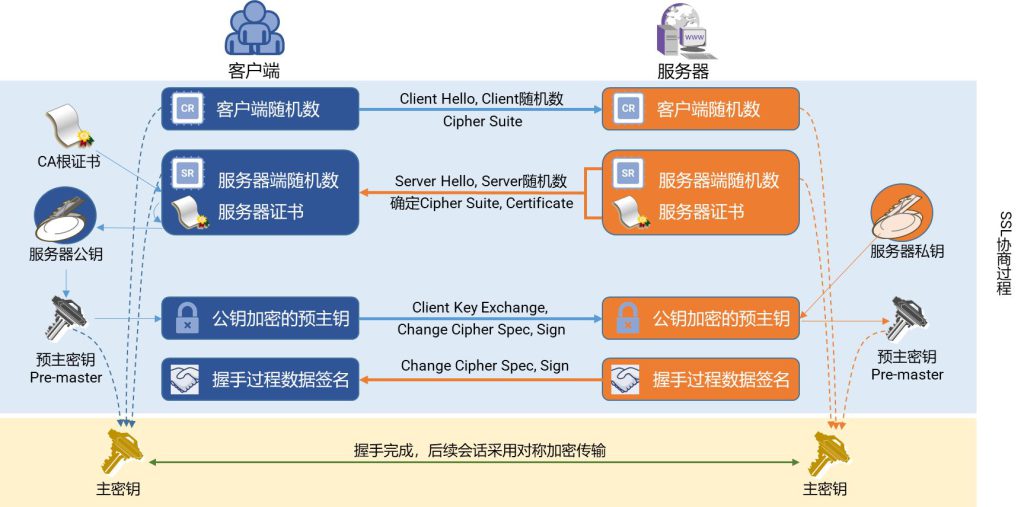

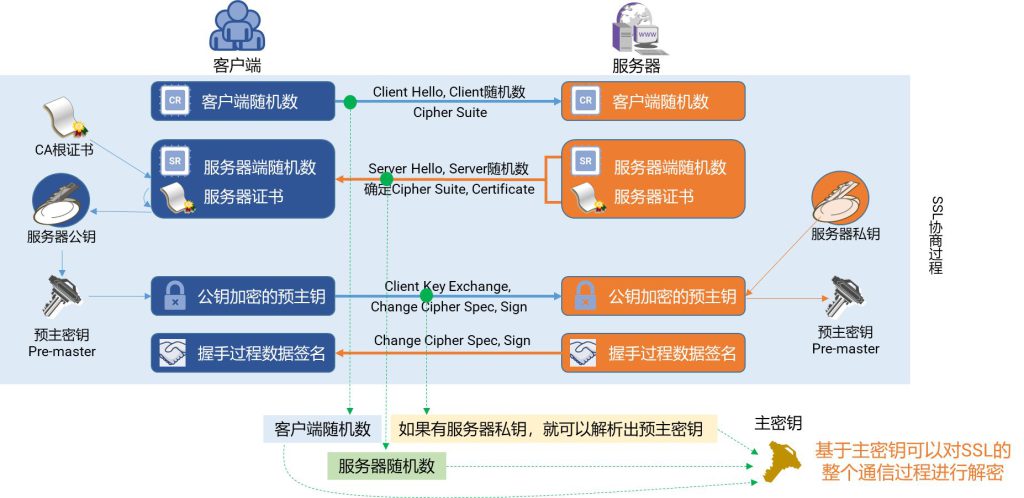

当前,我们在Helium DPU 智能网卡上已经完成了多种场景的功能验证,包括OVS、NVMe-oF(TCP)、LVS、5G UPF、SSL卸载等,保证了高质量、高可靠、高性能的用户体验。

关于Helium DPU智能网卡的开源工作

秉承开源开放的理念,星融元现已将Helium DPU智能网卡的产品资料和相关代码开放给生态内广大客户和合作伙伴,期待与您一同探索更多开放网络的应用场景。

-素材-6.jpg)

-图1-1024x483.jpg)

-图2-1024x492.jpg)

-图3-1024x803.jpg)

-图4-1024x391.jpg)

-图片-1-1024x311.jpg)

-图片-2-1024x688.jpg)

-图片-3-1024x541.jpg)

-图-1.png)

-图-2-876x1024.jpg)

-图-3-1024x485.jpg)

-图-4-1024x551.jpg)

-图-5-1024x662.jpg)

-图-6-1024x410.jpg)