全面升级!对比SDN园区方案,云化园区方案好在哪?

关注星融元

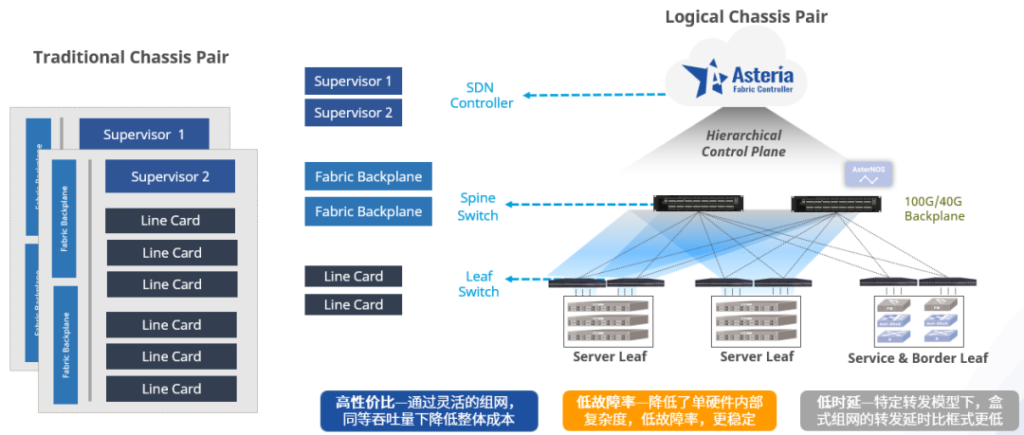

SDN的概念提出已十几年,至今却仍不温不火,当下主流的SDN控制器方案集网络的部署、配置、分析为一体,比起传统网络更具优越性,却并未获得市场成功。

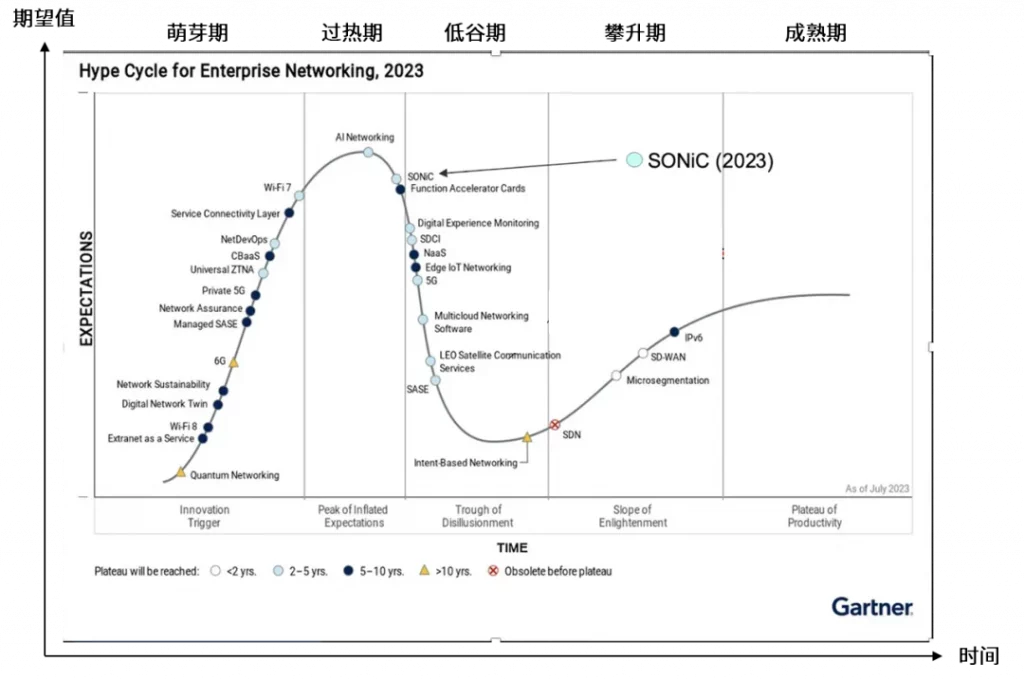

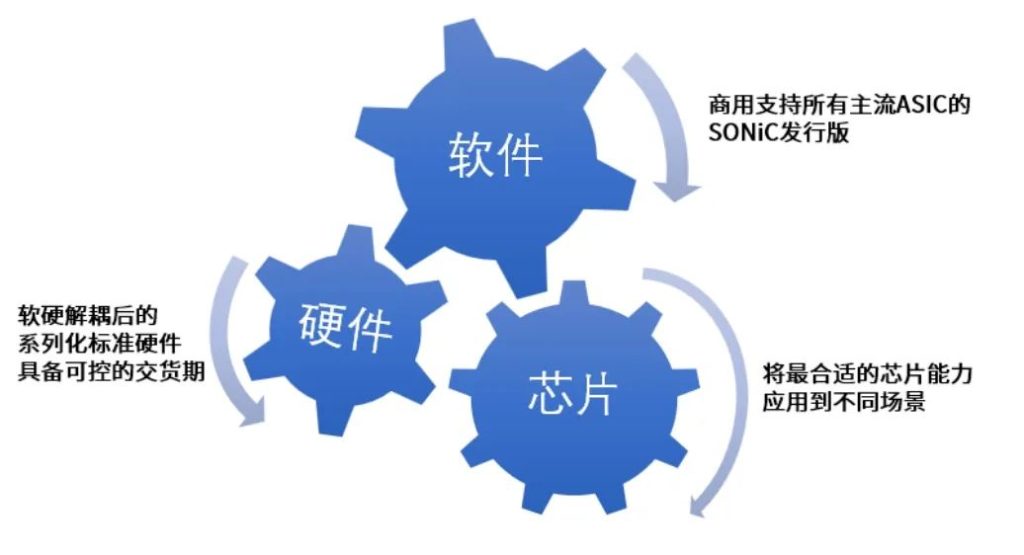

Gartner在2021和2023发布的《Hype Cycle for Enterprise Networking(企业网络技术成熟度曲线)》中,SDN技术因未能引发大量市场兴趣,被归为obsolete“过时”,相较于SDN,SONiC在园区网络建设中如火如荼。随着SONiC的广泛普及,客户可以按需从不同的基于SONiC的服务商获得网络服务,云化园区基于开源SONiC,这和SDN园区方案有着质的区别。

下文将全面对比星融元云化园区方案和SDN园区方案。

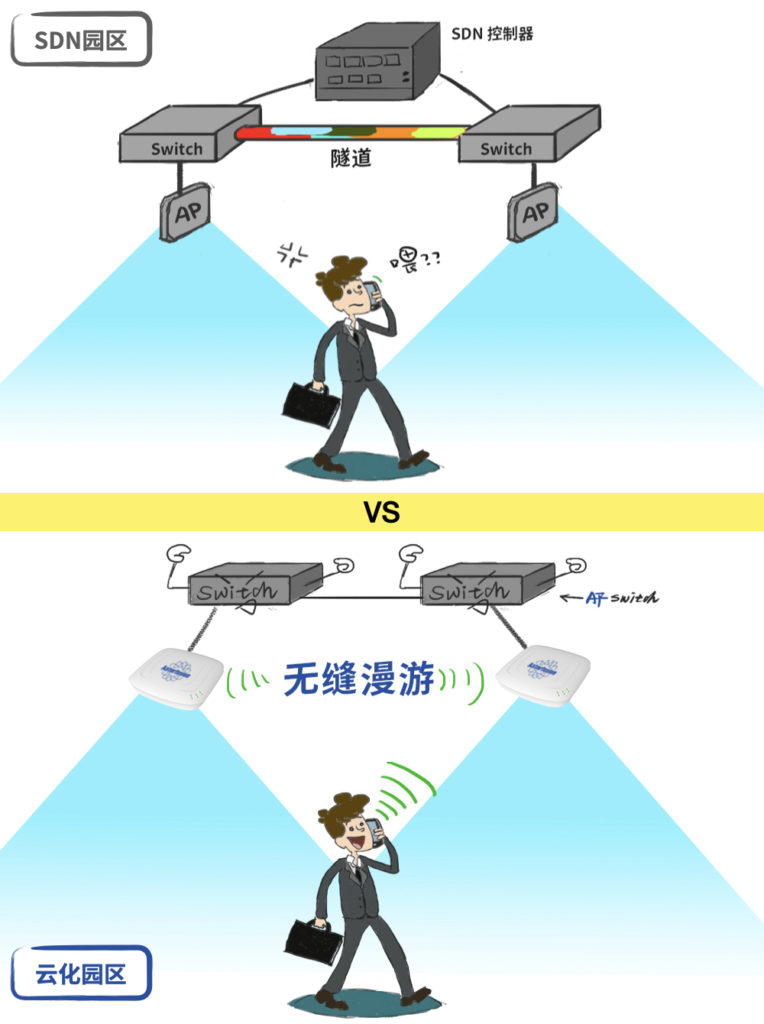

网随人动,策略随行

- 云化园区无需控制器,通过交换机组网和配置即可实现网随人动和策略随行,但SDN园区方案需要依赖SDN控制器。

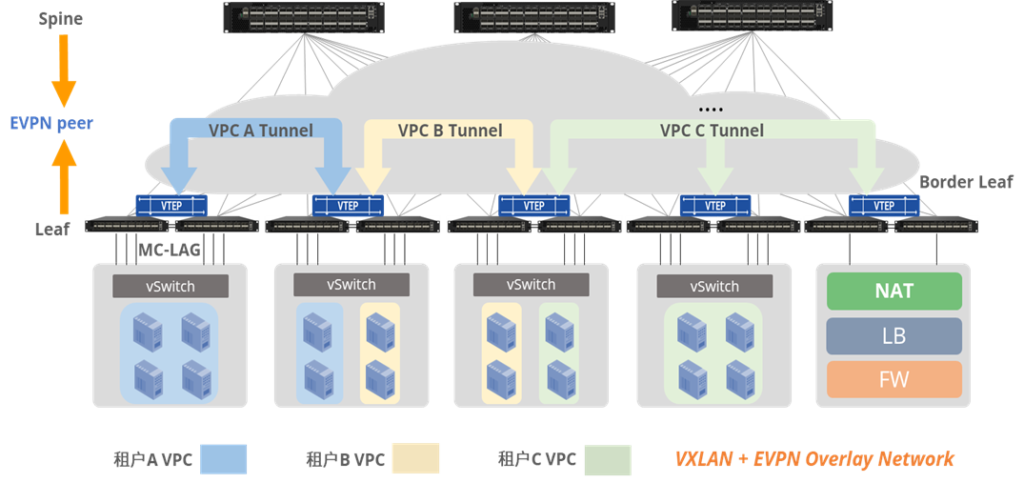

- SDN园区方案通过VxLAN实现网随人动和策略随行,涉及Underlay(物理网络)和Overlay(虚拟网络),不仅配置复杂,还涉及隧道封装和解封装,报文头开销更大,网络负担比较重,而云化园区只涉及Underlay,技术框架更简单,配置和部署更方便。

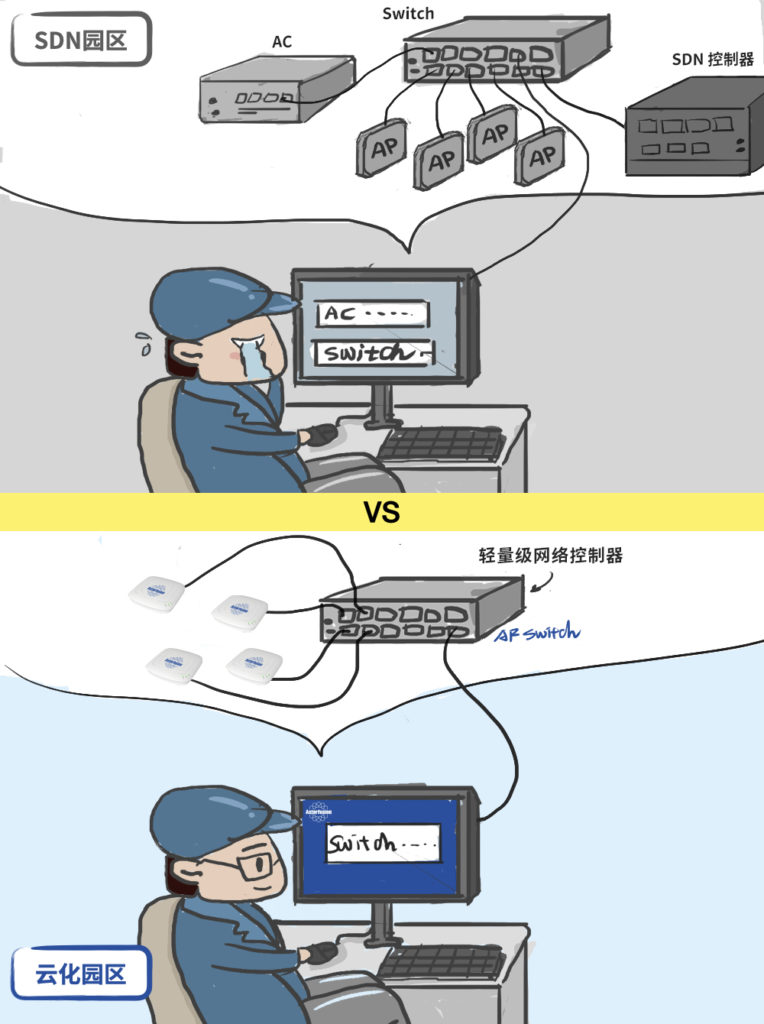

有线无线统一管理

云化园区通过一个符合TIP OpenWiFi标准的轻量级网络控制器即可实现有线无线统一管理,不再需要传统的AC控制器;SDN园区仍需要AC控制器负责AP上线,并且有线无线统一管理依赖于SDN控制器(SDN控制器调用AC控制器的API接口),方案更沉重。

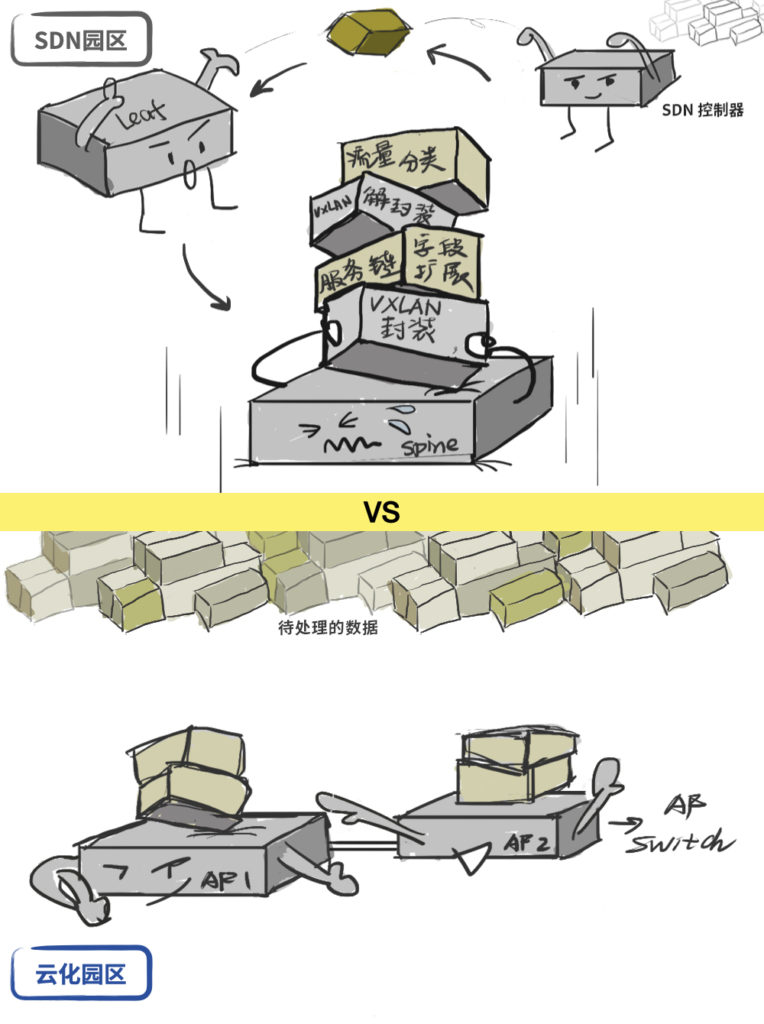

流量编排

- SDN园区的服务链功能需要SDN控制器、Leaf交换机、Spine交换机相互配合,缺一不可,而云化园区仅需一对流量编排交换机即可。

- SDN园区的服务链功能在原始流量之上封装了VxLAN,又在VxLAN之上扩展了服务链字段,报文开销大,网络负担沉重,而云化园区不对原始流量做任何改动,转发和处理更高效。

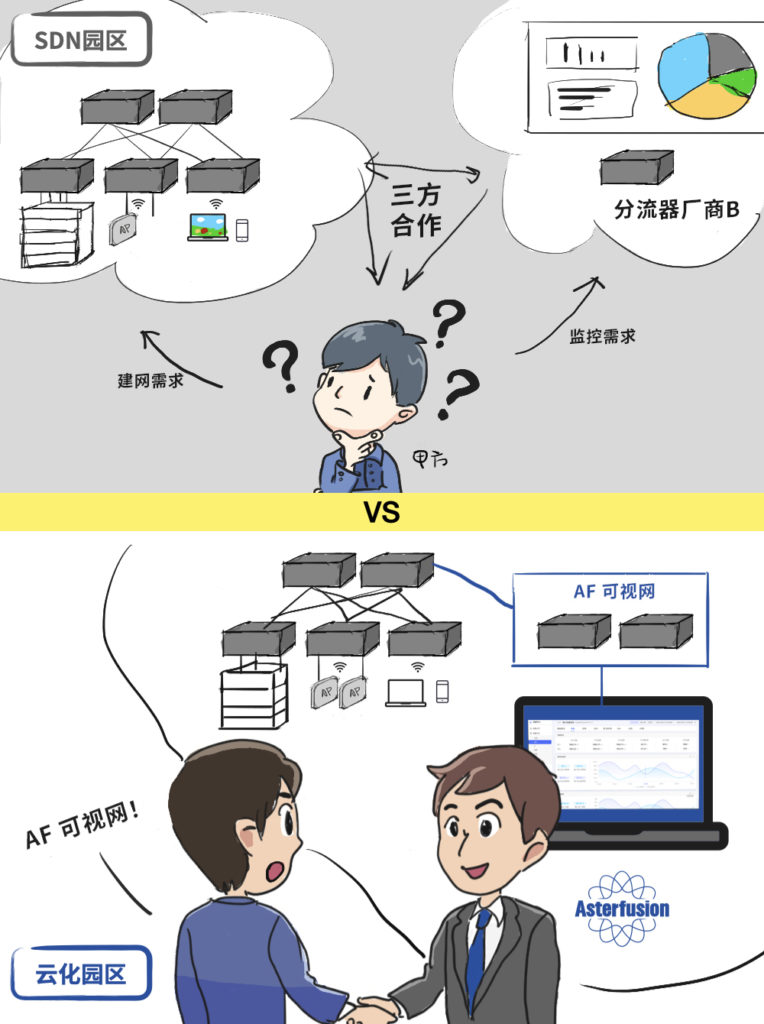

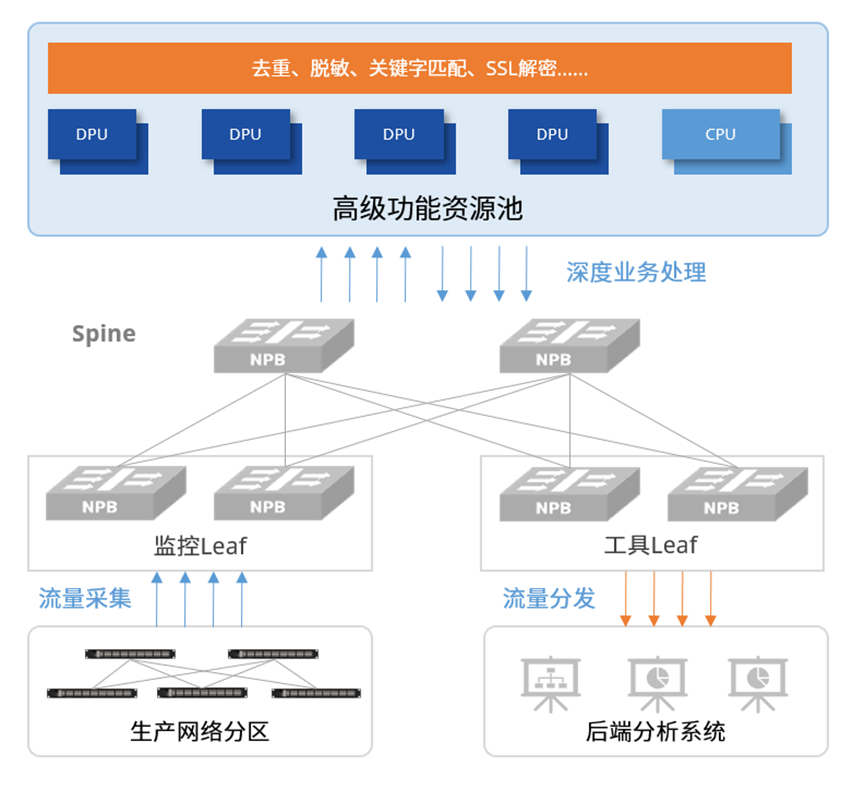

业务网与可视网相融合

- SDN园区方案的厂商是没有可视网方案的,一般与第三方进行方案集成和合作,而云化园区可以提供整套业务网+可视网的融合方案。

- 由于SDN园区方案采用VxLAN,在流量采集时还需考虑如何去除VxLAN的封装,对流量采集设备要求较高,而云化园区对原始流量未封装处理,对流量采集设备没有特殊要求。

- SDN园区方案需要对每一个Leaf交换机做流量采集,而云化园区仅需采集若干Leaf上联的Spine即可,采集点大大减少,节省可视网建设成本。

- 云化园区支持基于用户过滤流量,而SDN园区方案无法实现。

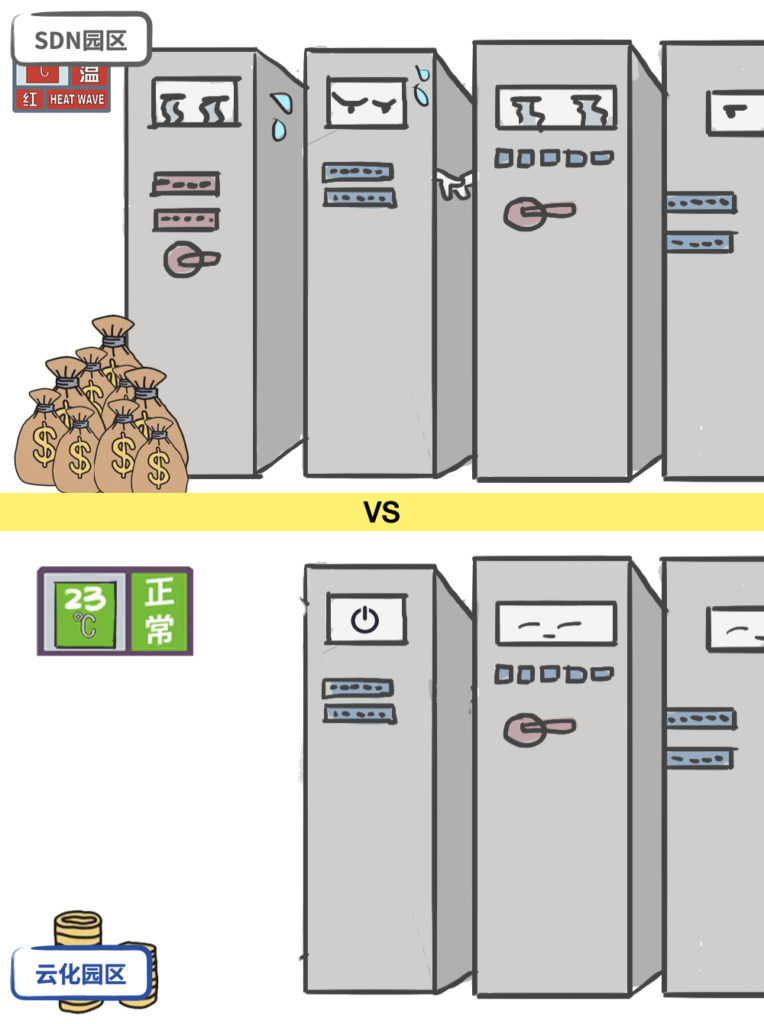

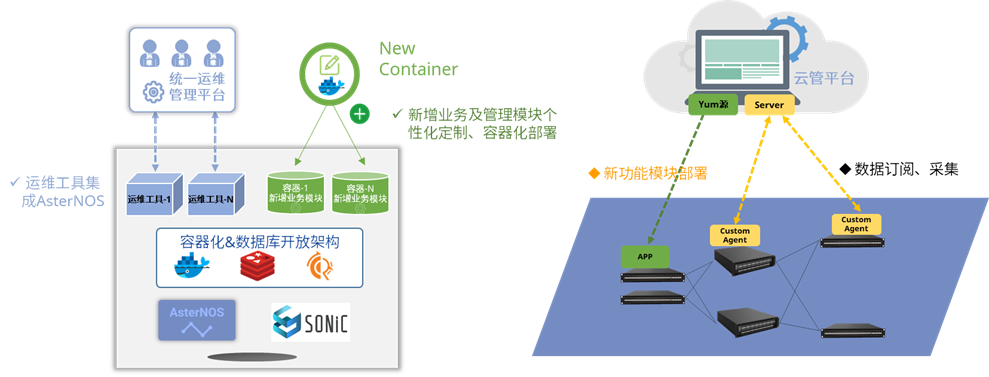

控制器成本

- 云化园区的控制器无需占用太多的服务器资源,部署成本更低。

- 云化园区的控制器更轻量级,功能精简实用,部署和配置简单,运维成本较低。

成本低、配置方便、原始流量转发处理更高效……与SDN园区方案相比,云化园区方案还在技术路线和开放性方面有所突破,更符合未来园区网络发展趋势,能够更好地满足不断增长的网络需求和日益复杂的应用场景。随着云化园区方案的推广和应用,将为园区的数字化转型和智能化发展提供有力支持。

| 对比维度 | SDN园区(如AD园区方案) | 云化园区 |

|---|---|---|

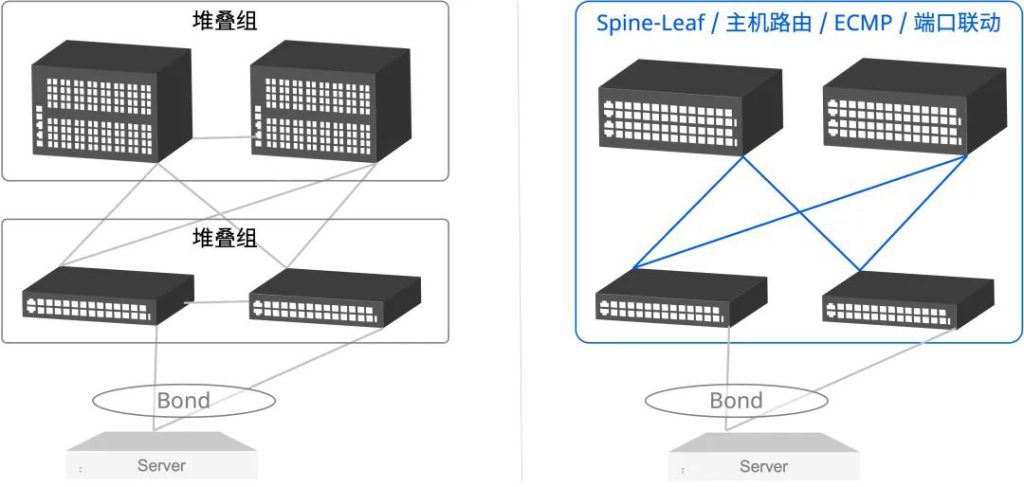

| 技术路线 | 1、基于VxLAN构建虚拟网络 2、通过沉重的SDN控制器进行管控 | 1、基于Leaf-Spine的全三层组网架构 2、通过轻量的云端面板管理 |

| 开放性 | 私有NOS和私有技术实现 | 有线/无线均采用开源开放的系统架构 |

星融元新一代云化园区方案已经推出,还在等什么?来试试吧!一起推动园区网络方案的新变革!

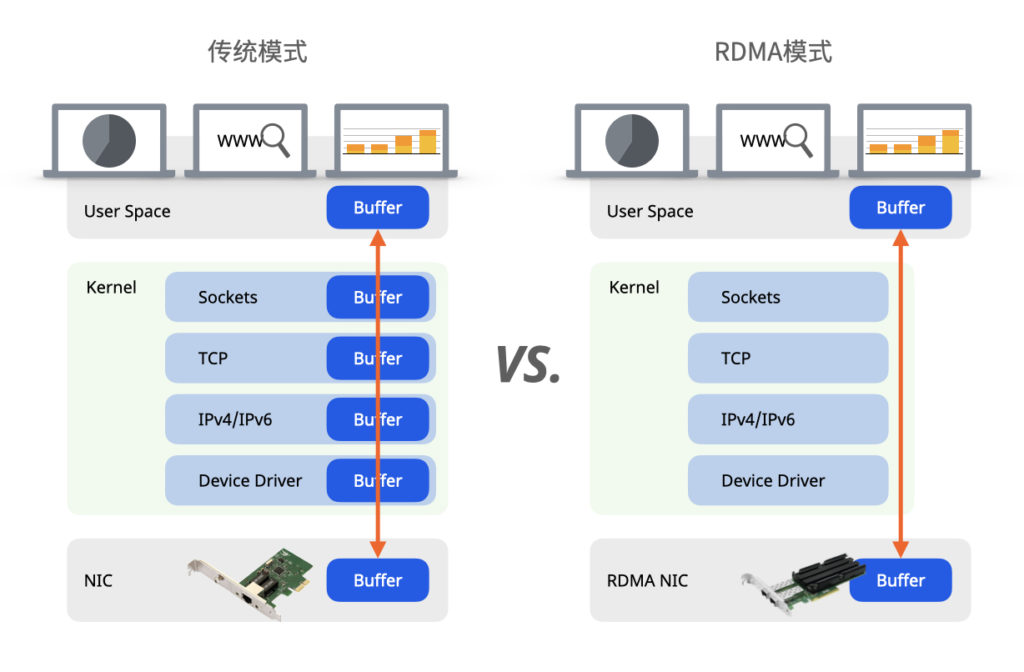

(2)通过Easy RoCE技术,

(2)通过Easy RoCE技术,

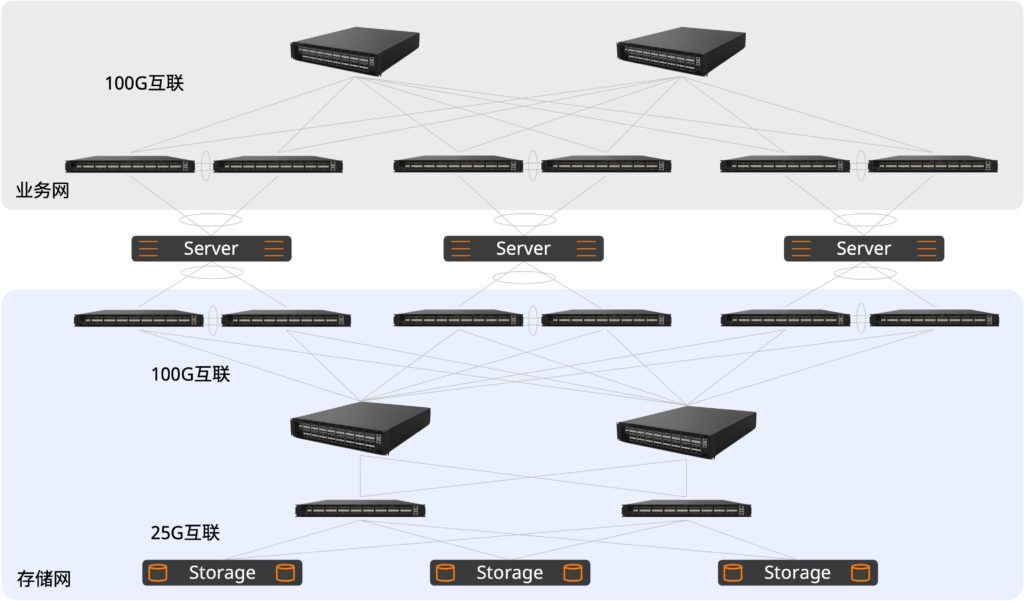

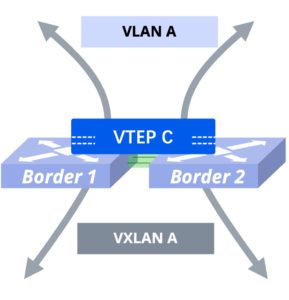

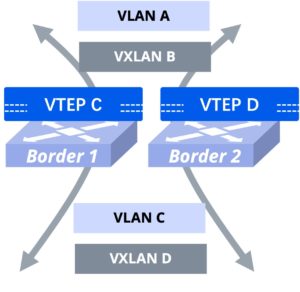

两台Border配置不同的VTEP地址,利用物理三层接口以及三层子接口和边界防火墙和边界路由器对接;同时组建MC-LAG系统,设置Monitor-Link上行口联动与OSS主机相连的下行端口,Border与OSS主机相连端口放通OSS业务VLAN,并在设备内部创建VLAN虚接口作为OSS主机的分布式网关。(该方案适用于防火墙主备场景以及采用动态路由协议的对接场景)

两台Border配置不同的VTEP地址,利用物理三层接口以及三层子接口和边界防火墙和边界路由器对接;同时组建MC-LAG系统,设置Monitor-Link上行口联动与OSS主机相连的下行端口,Border与OSS主机相连端口放通OSS业务VLAN,并在设备内部创建VLAN虚接口作为OSS主机的分布式网关。(该方案适用于防火墙主备场景以及采用动态路由协议的对接场景)