高效转发+智能管理:MPLS技术如何应对多业务挑战?

近期文章

随着现代企业园区网络和运营商级基础设施的不断发展,多协议标签交换 (MPLS) 已成为一项基础技术,这要归功于其高效的数据包转发、高级流量工程功能以及对多租户环境的强大支持。

什么是MPLS?

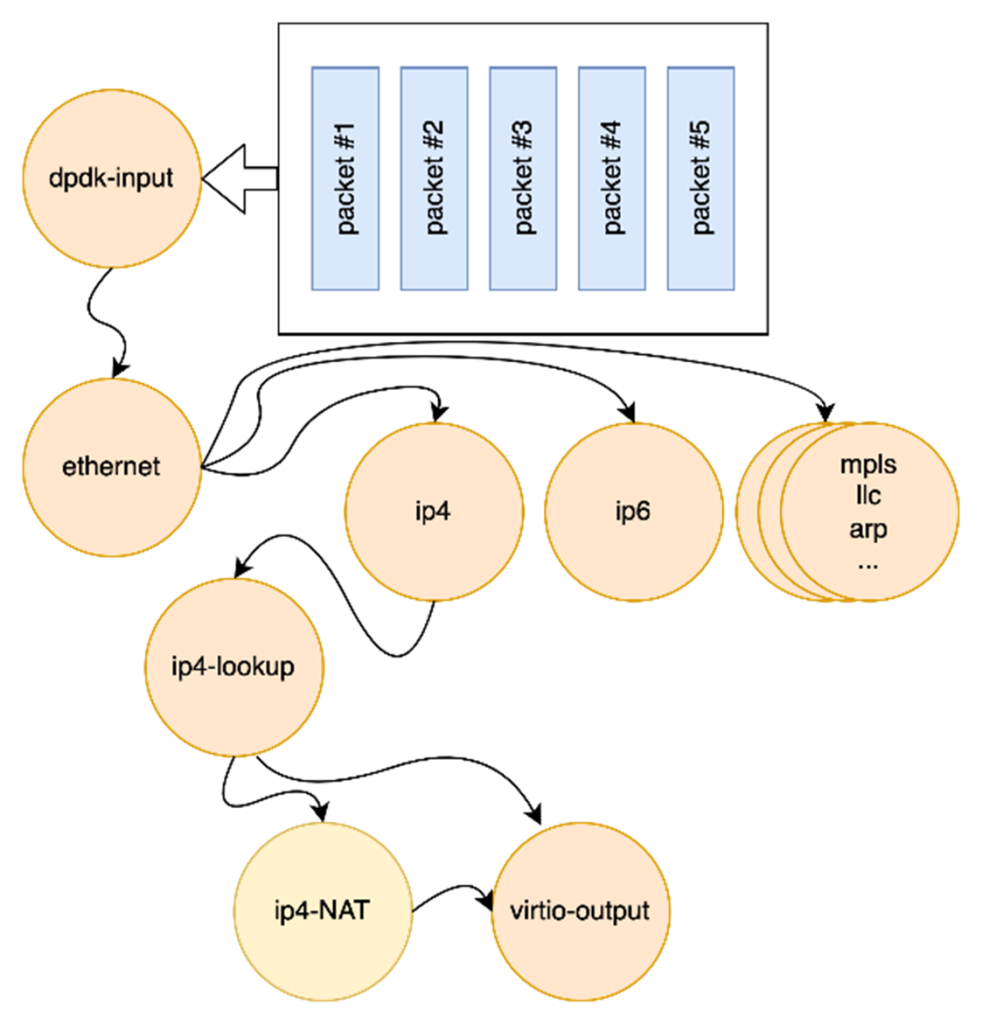

MPLS(多协议标签交换,Multiprotocol Label Switching)是一种基于标签的转发技术,结合了二层交换的简捷性与三层路由的灵活性。通过预分配的标签(Label)替代传统IP路由的逐跳查表,提升转发效率。

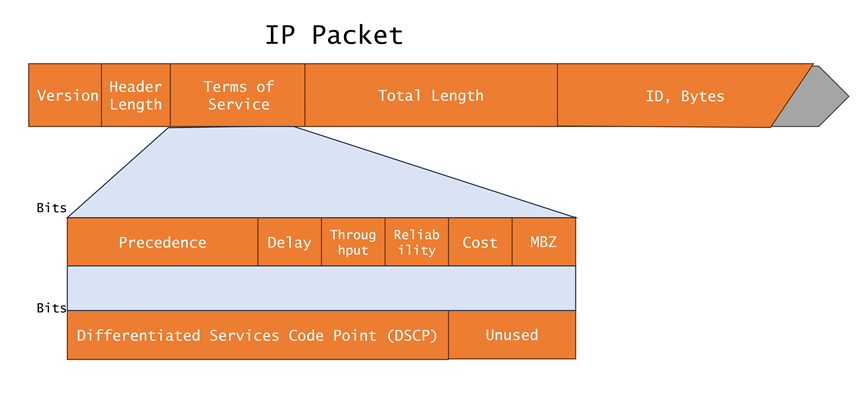

MPLS起源于IPv4(Internet Protocol version 4),其核心技术可扩展到多种网络协议,包括IPv6(Internet Protocol version 6)、IPX(Internet Packet Exchange)和CLNP(Connectionless Network Protocol)等。MPLS中的“Multiprotocol”指的就是支持多种网络协议。

由此可见,MPLS并不是一种业务或者应用,它实际上是一种隧道技术。这种技术不仅支持多种高层协议与业务,而且在一定程度上可以保证信息传输的安全性。

核心组件:LER(标签边缘路由器)、LSR(标签交换路由器)、FEC(转发等价类)。

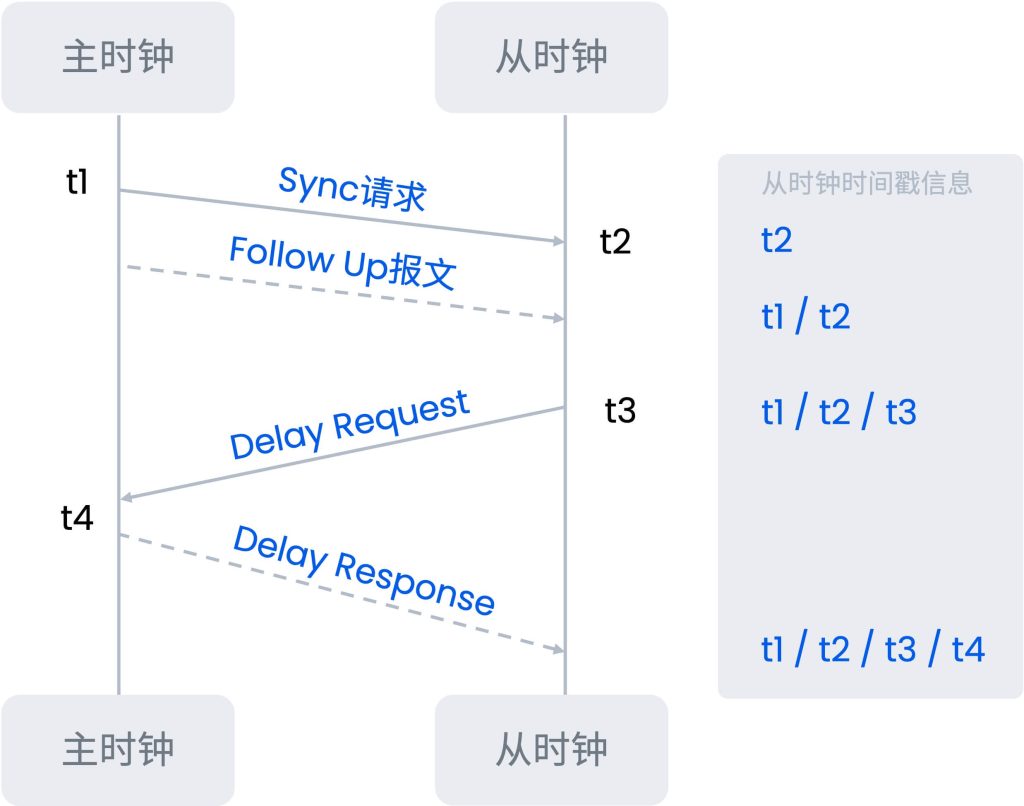

工作原理

- 标签分配:入口路由器(LER)为数据包分配标签,标签对应转发路径(LSP)。

- 标签交换:中间路由器(LSR)根据标签转发表(LFIB)快速转发,无需解析IP头部。

- 标签移除:出口路由器(LER)剥离标签,恢复原始IP数据包。

标签结构

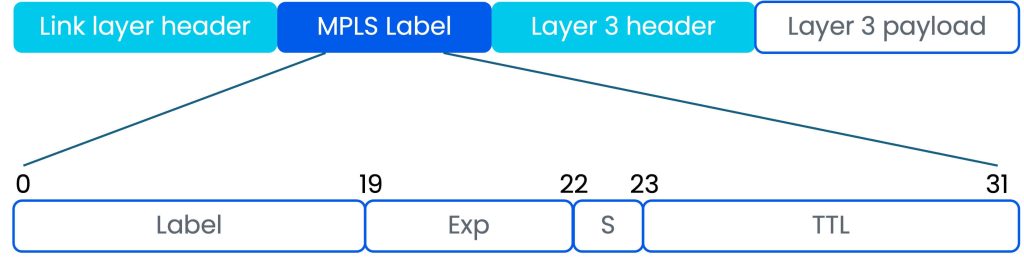

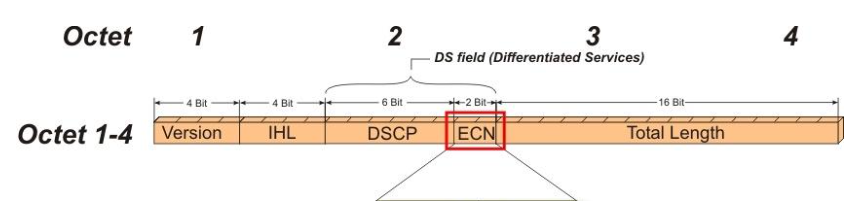

MPLS 标签是一个紧凑的 32 位报头,包含四个关键字段:

- 标签 (20 位) — 标识通过 MPLS 网络的路径 (LSP)

- EXP(3 位)— 用于 QoS(服务质量)标记或流量优先级

- S (1 bit) – 堆栈标志的底部;指示这是否是堆栈中的最后一个标签

- TTL(8 位)– 生存时间;通过限制数据包的生命周期来防止路由循环

为什么需要MPLS?

在传统IP网络架构中,基于三层路由的转发机制逐渐暴露很多问题。

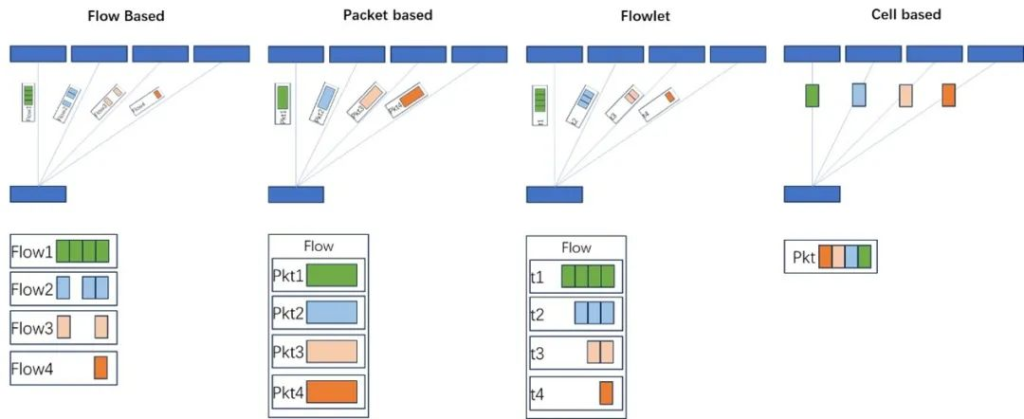

首先,转发效率低下的问题尤为突出,由于每台路由器都需要逐跳解析IP报文头部并查询路由表,这种反复查表的机制在大流量场景下会产生显著延迟,难以满足数据中心或运营商核心网的高吞吐需求。

其次,传统路由技术对路径控制能力薄弱,完全依赖OSPF、BGP等动态路由协议自动选路,既无法主动规避拥塞链路,也无法为特定业务指定优化路径,导致网络资源利用率低下。

更棘手的是多业务隔离难题,VLAN受限于4096个ID的规模上限,ACL策略管理复杂度随业务增长呈指数级上升,这种基于二层的隔离方案难以支撑跨地域、多租户的现代组网需求。

MPLS技术的核心功能

服务质量(QoS)

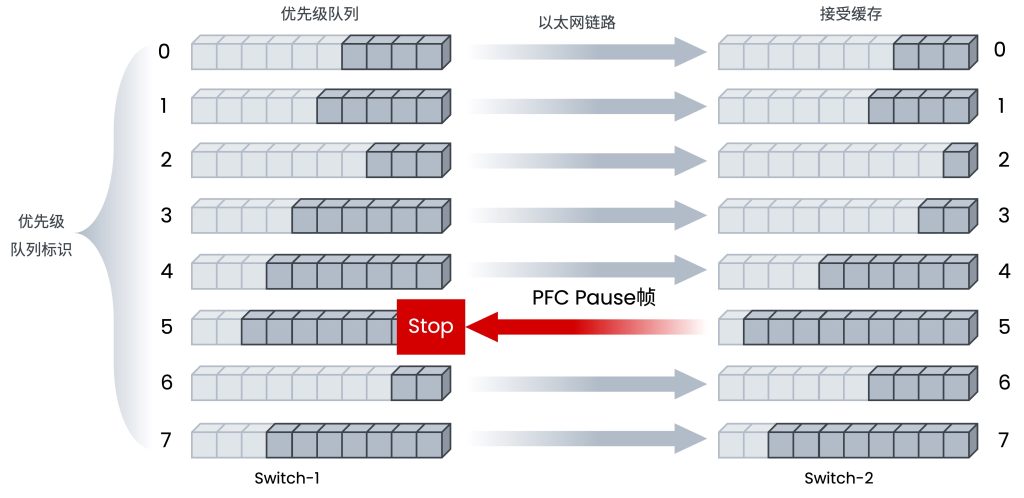

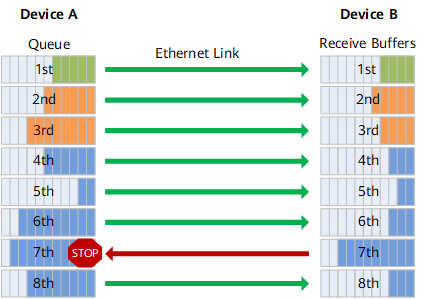

MPLS在QoS中的应用主要体现在其对网络流量优先级管理的精细化能力上,而EXP字段(Experimental Bits,后更名为Traffic Class字段)是两者结合的核心纽带。MPLS如何实现QoS保障?在MPLS网络入口(LER),根据业务类型(如语音、视频、普通数据)为流量分配EXP值,可通过手动配置或自动映射(如将IP层的DSCP值转换为EXP值)。LSR根据EXP值分为不同优先级队列,优先转发低延迟流量(SP)和按比例分配剩余带宽(WFQ)。当链路拥塞时,低EXP值的流量可能被丢弃(如TCP流量),而高EXP值的流量(如VoIP)始终保障带宽,此外,再结合RSVP-TE等协议实现关键业务(如语音、实时视频)的带宽保障和低抖动传输,构建起从转发效率到业务体验的全方位优化体系。

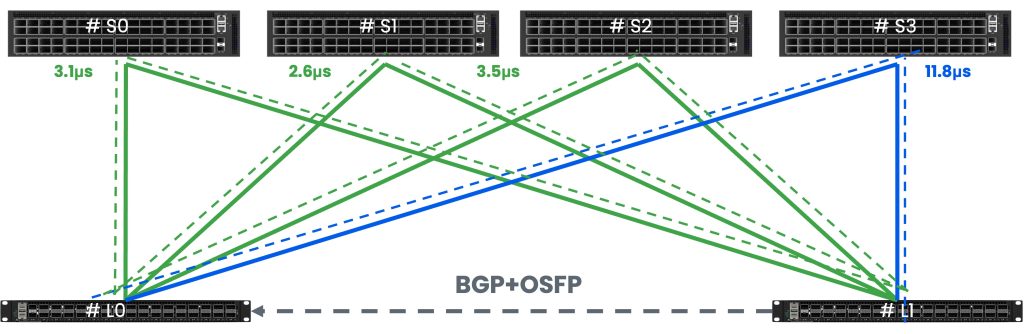

流量工程(TE)

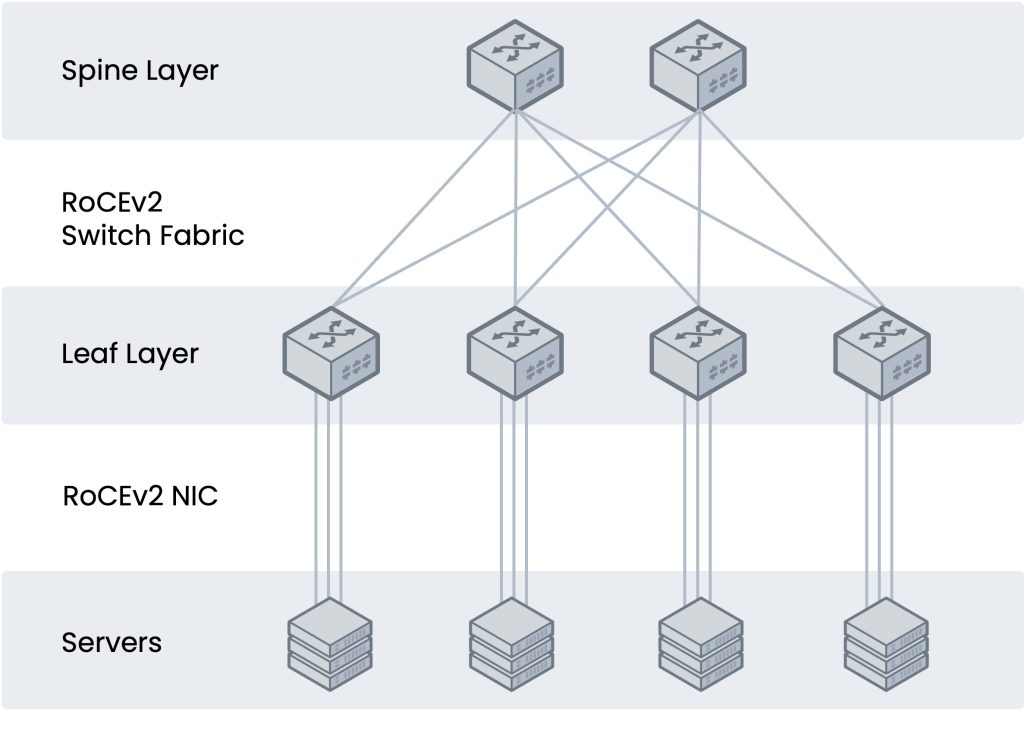

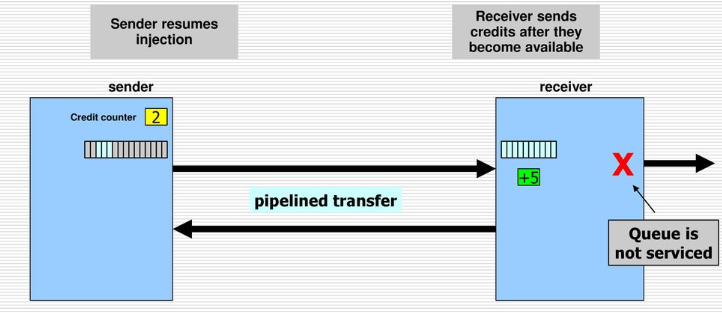

TE通过MPLS技术解决了传统IP网络无法实现的精细化流量控制需求,通过显式路径(Explicit Path)手动或策略驱动流量走向,均衡负载或避开瓶颈链路,从而优化网络性能。

业务隔离与VPN

传统VPN一般是通过GRE(Generic Routing Encapsulation)、L2TP(Layer 2 Tunneling Protocol)、PPTP(Point to Point Tunneling Protocol)等隧道协议来实现私有网络间数据在公网上的传送,而MPLS LSP是通过标签交换形成的隧道,数据报文不再经过封装或者加密,因此,用MPLS实现VPN具有天然的优势。

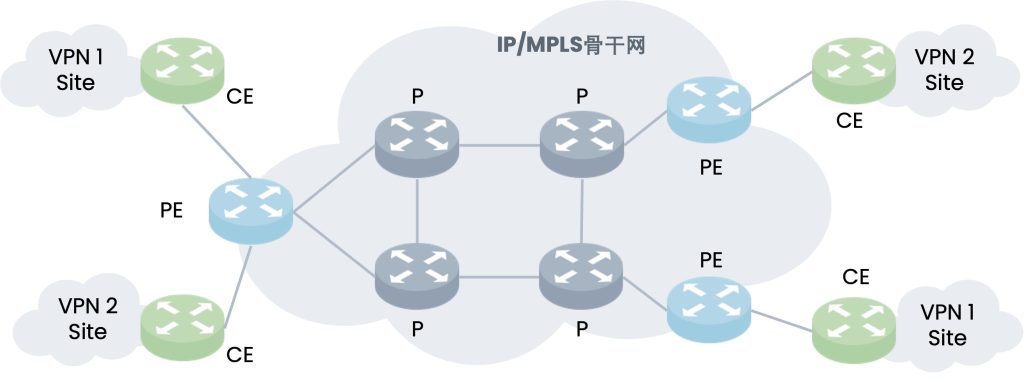

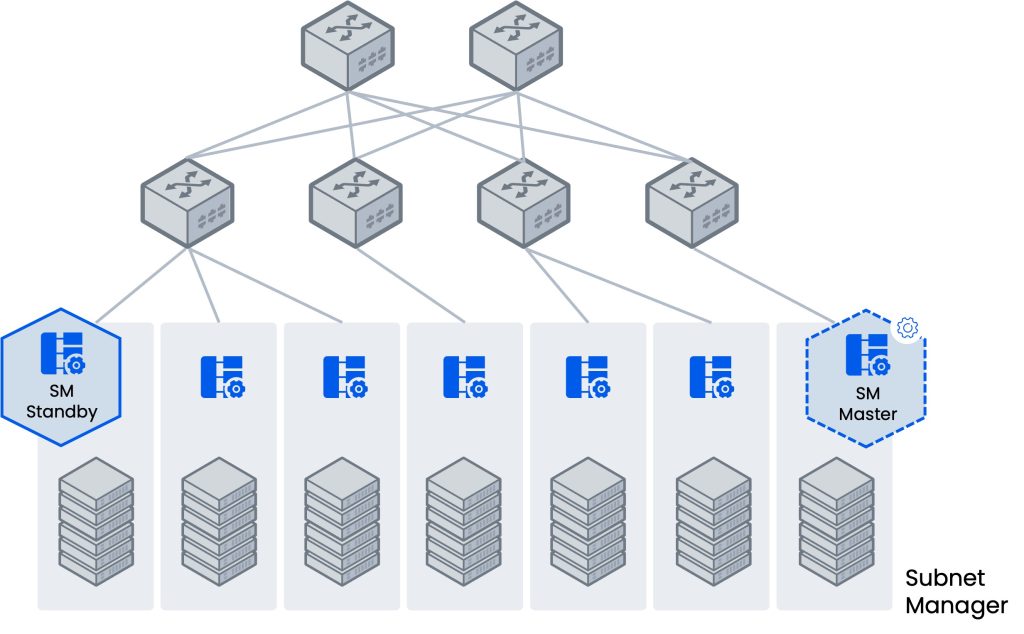

基于MPLS的VPN通过LSP将私有网络的不同分支联结起来,形成一个统一的网络,如图所示。基于MPLS的VPN还支持对不同VPN间的互通控制。这对于企业和运营商网络至关重要。

- CE(Customer Edge)是用户边缘设备,可以是路由器,也可以是交换机或主机。

- PE(Provider Edge)是IP/MPLS骨干网的边缘设备。

- P(Provider)是IP/MPLS骨干网的骨干设备,不与CE直接相连。P设备只需要具备基本MPLS转发能力,不维护VPN信息。

| 对比维度 | MPLS | 传统IP路由 | SD-WAN | Segment Routing |

|---|---|---|---|---|

| 转发效率 | 高(标签快速交换) | 低(逐跳查表) | 中(依赖隧道封装) | 高(类似MPLS) |

| 路径控制 | 支持显式路径和流量工程 | 依赖动态路由协议 | 动态智能选路 | 灵活源路由 |

| 多业务隔离 | 通过VPN实现逻辑隔离 | VLAN/ACL,扩展性差 | 有限(依赖Overlay) | 需结合其他技术(如VXLAN) |

| 部署成本 | 高(依赖专用设备和运营商专线) | 低 | 低(利用互联网链路) | 中(需升级硬件支持) |

| 适用场景 | 企业专网、运营商核心网 | 中小型园区网络 | 跨地域互联、云访问优化 | 数据中心、大规模骨干网 |

| 服务质量(QoS) | 强(基于EXP/DSCP优先级标记) | 弱 | 中(依赖链路质量监测) | 中(需策略配合) |

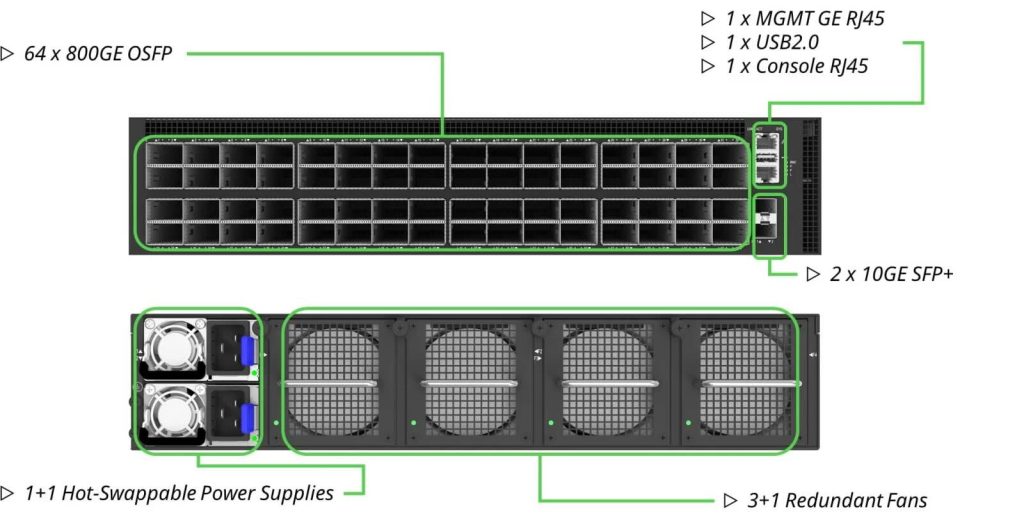

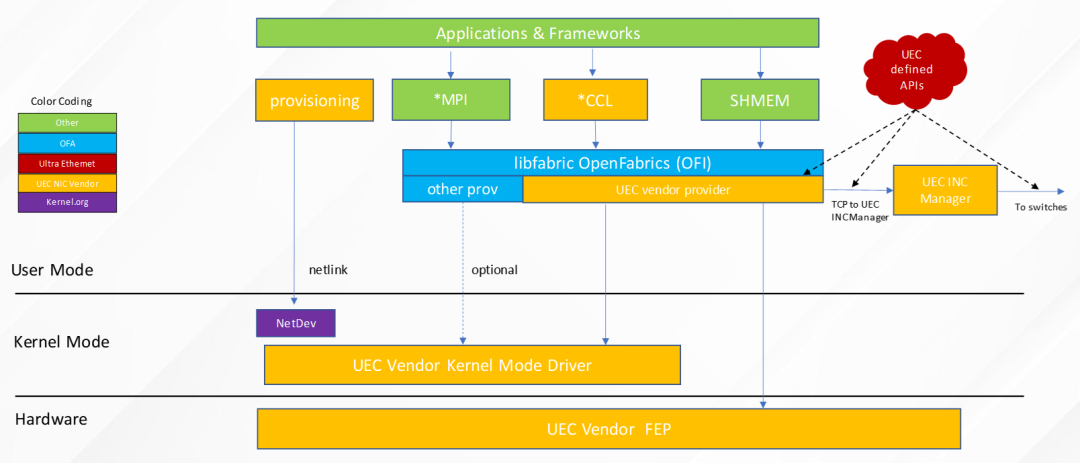

AsterNOS:软件定义架构下的MPLS转发技术革新

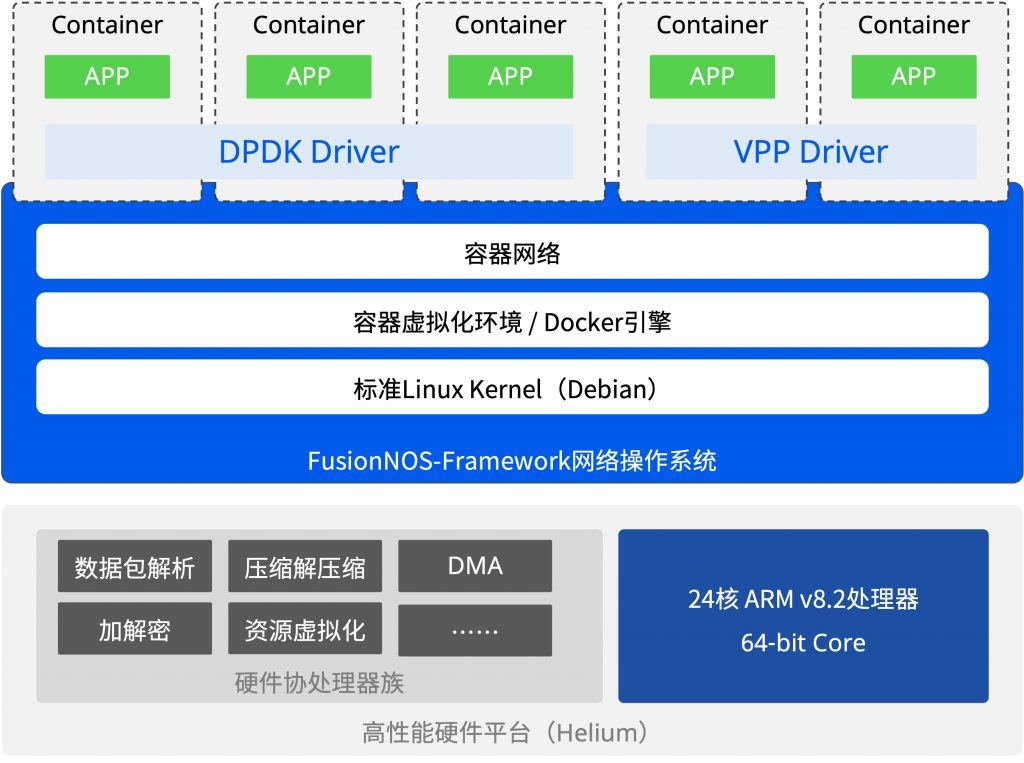

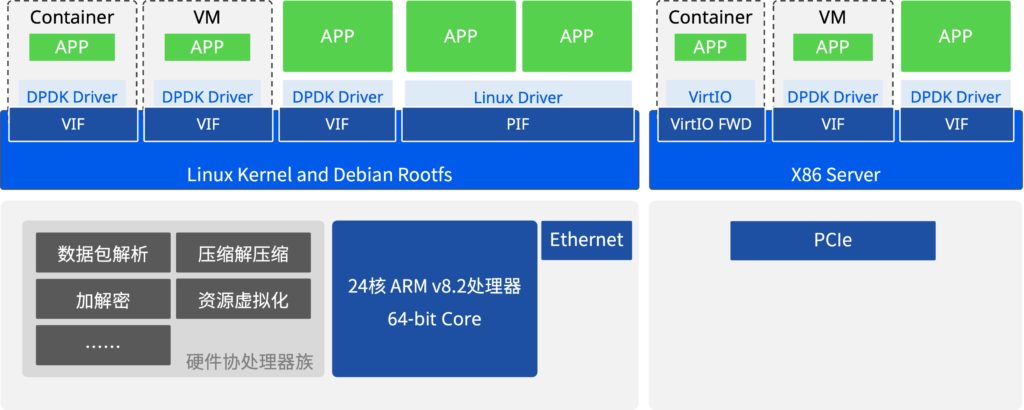

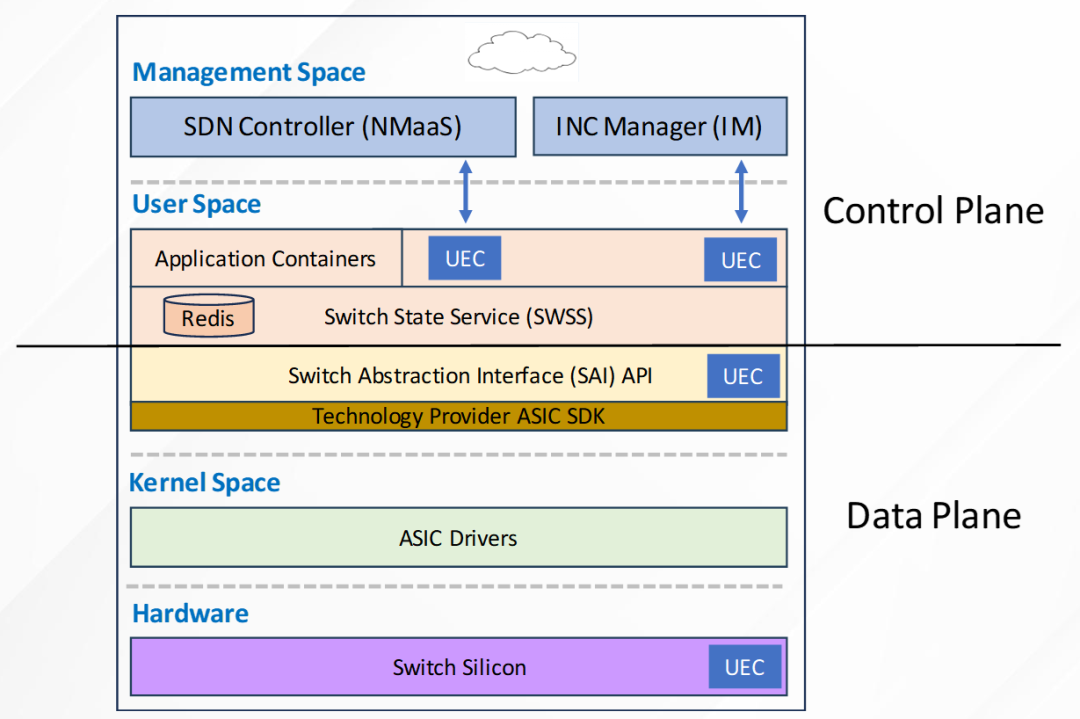

SONiC(Software for Open Networking in the Cloud) 是开源社区的网络操作系统,其核心目标是构建开放、解耦的云数据中心网络架构。作为全球首个完全开源的网络操作系统,SONiC基于Linux内核设计,支持标准化硬件(如白盒交换机)与容器化微服务架构,通过模块化组件(如SAI——交换机抽象接口)实现灵活的功能扩展。其开源特性吸引了全球云服务商、运营商及企业的广泛参与,逐步成为云原生网络的事实标准。

尽管社区版 SONiC 通过模块化设计为云数据中心提供了开放灵活的基础架构,但其在复杂协议支持上的短板始终制约着企业级场景的深度应用。以MPLS为例,社区版本需依赖第三方扩展或定制化开发,导致功能碎片化、性能不稳定,难以满足金融专网、跨云互联等高可靠性需求。

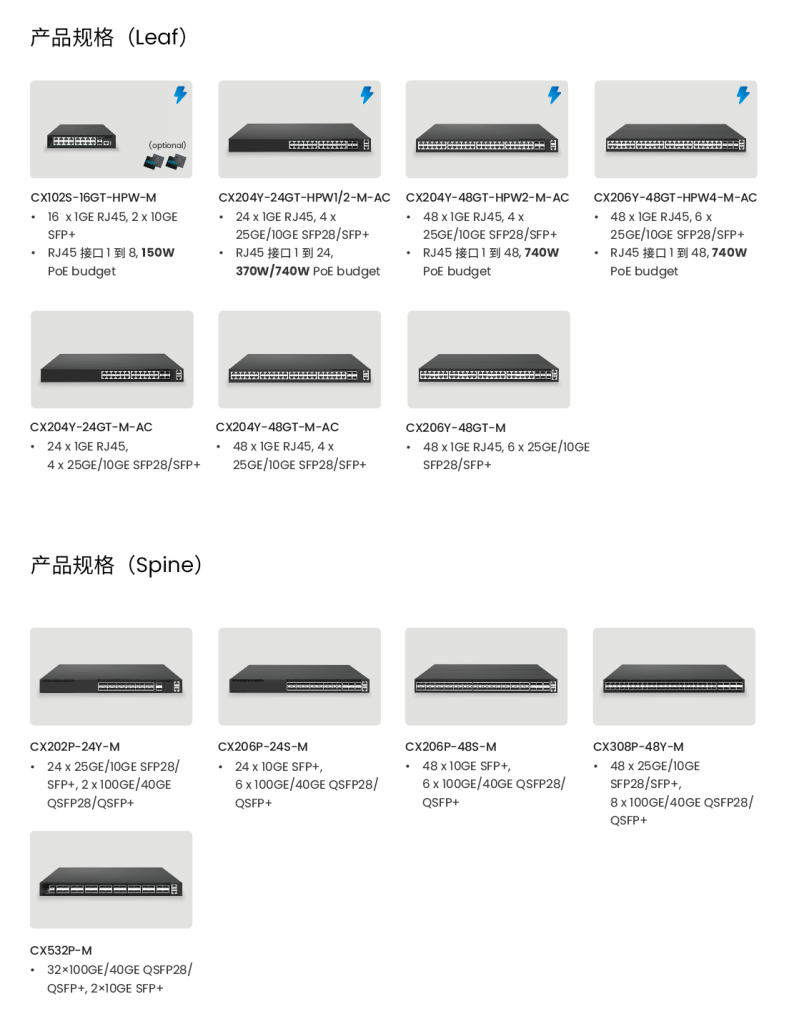

AsterNOS基于 SONiC 的开放式园区交换机的完整产品组合现在完全支持 MPLS,它提高了数据包转发速度,支持精细的流量控制,并支持多协议环境,使其成为电信、企业 WAN 和云数据中心中的大规模网络不可或缺的工具。

这种“开源基因+商业级能力”的融合,使得AsterNOS既能继承开源生态的灵活性,又能以超前技术布局填补开源生态与商业需求间的鸿沟。