AI时代,如何吃下数据传输这块蛋糕?

关注星融元

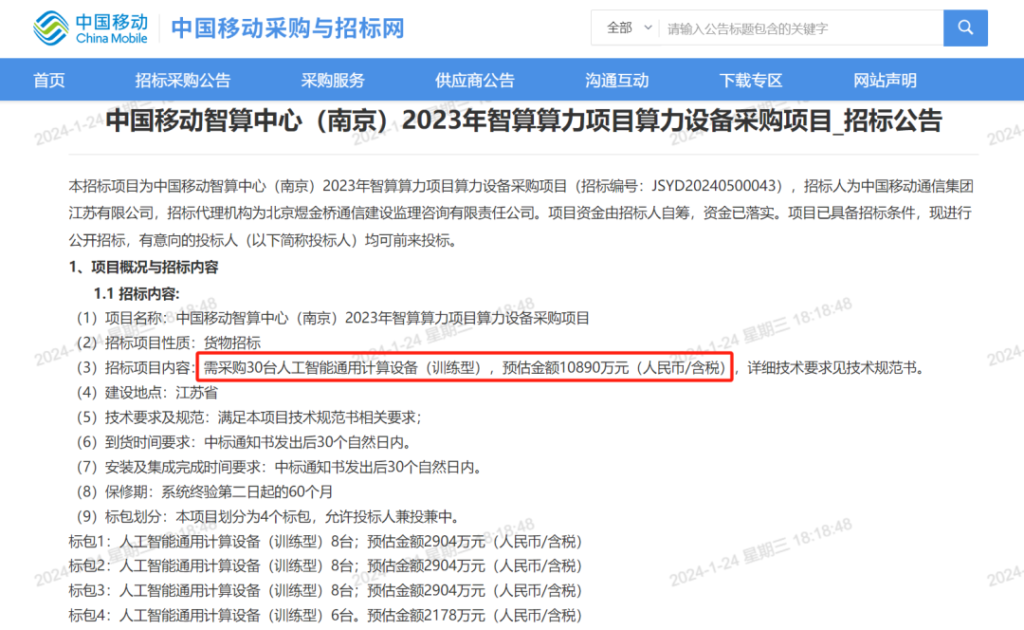

“30台AI服务器1个亿?这就是在抢钱啊!”

近日,中国移动江苏有限公司发布《中国移动智算中心(南京)2023年智算算力项目算力设备采购项目》招标公告,招标项目内容显示,需采购30台人工智能通用计算设备(训练型),预估金额10890万元(人民币/含税),单价限价363万元/台。

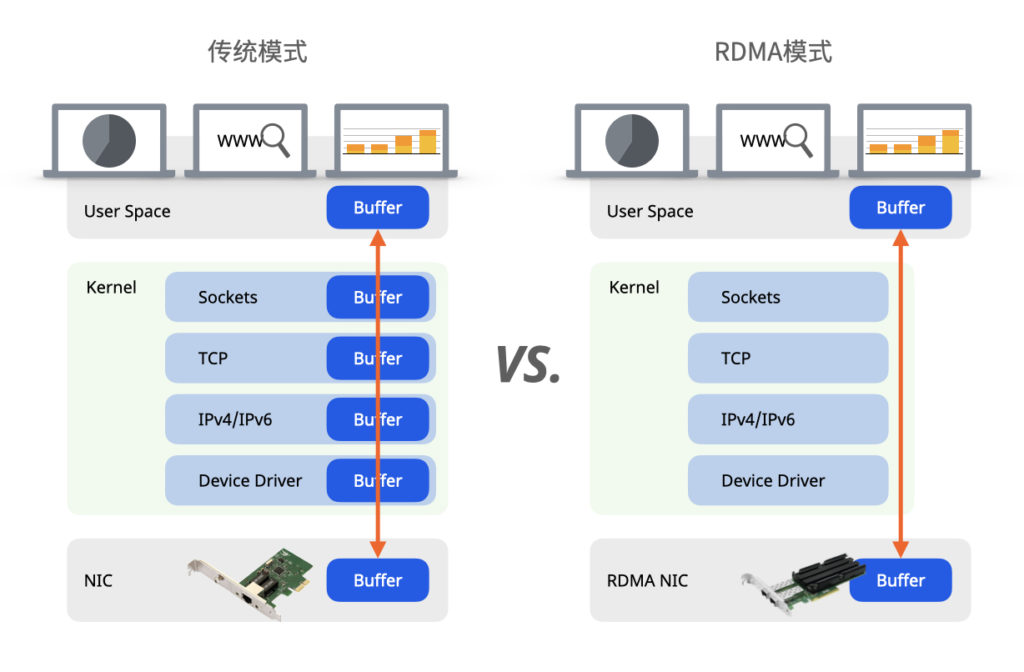

从2021年底ChatGPT上线迅速引发广泛关注后,AI行业持续火爆至今,随着行业巨头纷纷下场,AI基础设备的军备竞赛如火如荼。AI训练模型需要大量数据和计算资源,这对网络基础设施提出较高带宽和低时延的要求,很多人立马会想到InfiniBand,但昂贵的方案价格、无法与其他网络设备互通互访的特性以及较长的供货周期让国内AI厂商犯难,基于Ethernet的RoCE方案成了数据传输的首选:提供媲美InfiniBand的高宽带低时延性能,加上较低的成本,网络使用RoCE方案已经成为AI厂商的必然发展趋势。

AI技术需要强大的计算资源来支撑,具有强并行计算能力的GPU能够大幅提升计算效率,缩短AI训练模型时间,配备合适的网卡能够充分发挥GPU的性能,但GPU芯片供应常年短缺,对AI厂商来说抢到GPU已属不易,更遑论挑选型号,采购GPU和网卡的流程往往同时进行,此时无法预判究竟应该配备200G还是400G的网卡。

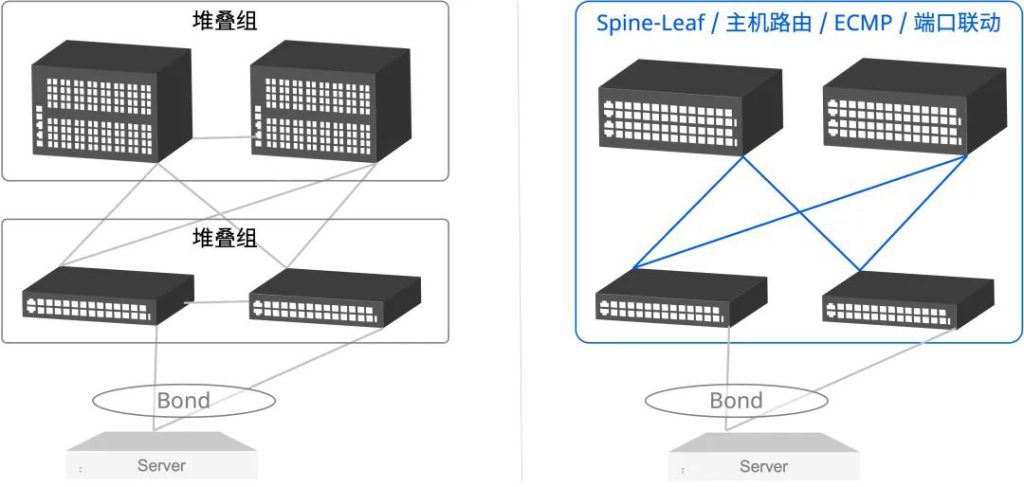

网卡负责处理网络通信与数据传输,无法确定网卡参数时,可以通过200G/400G RoCE的混合组网来简化管理和部署,使数据中心拥有更好的可扩展性。在混合组网的落地过程中,时常有参数流量超越线路带宽、网络丢包的风险,产生训练速度降级,GPU资源闲置率过高等问题,军备竞赛当前,应该挑选哪家厂商承担基础设施建设的重任?

目前中国市场上的交换机有多种规格,1G/10G/25G/40G/100G都比较常见,市面上200G端口的交换机凤毛麟角,少数厂家能提供200G低密度宽口或是框式交换机,在网络扩展升级的灵活性、成本效益方面都存在劣势;400G端口的交换机也较少见,一般用于高性能数据中心或大型企业网络中,因此能够提供200G/400G RoCE混合组网的厂商十分有限。

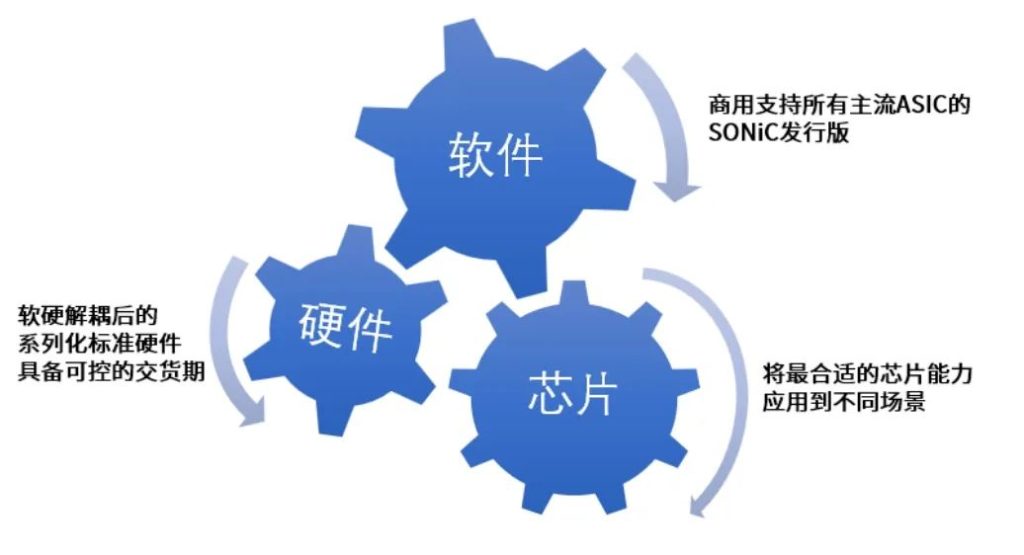

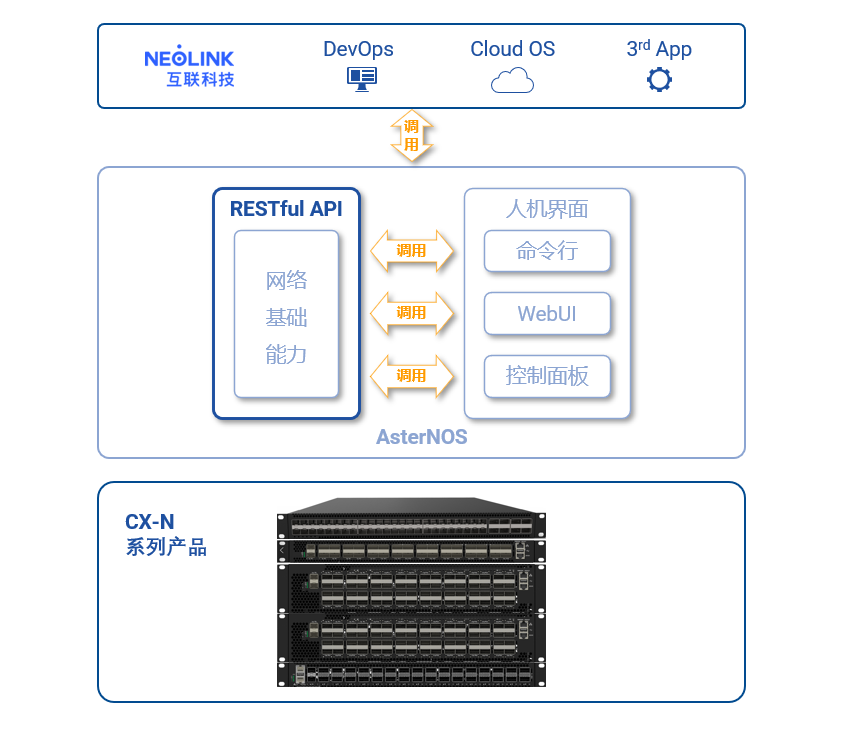

星融元作为国内新一代开放云架构解决方案的提供商,7年来始终大力投入研发,拥有众多技术创新,是业界唯一能够提供200G/400G RoCE混合组网、无缝衔接、且网络无损的开放网络厂商。

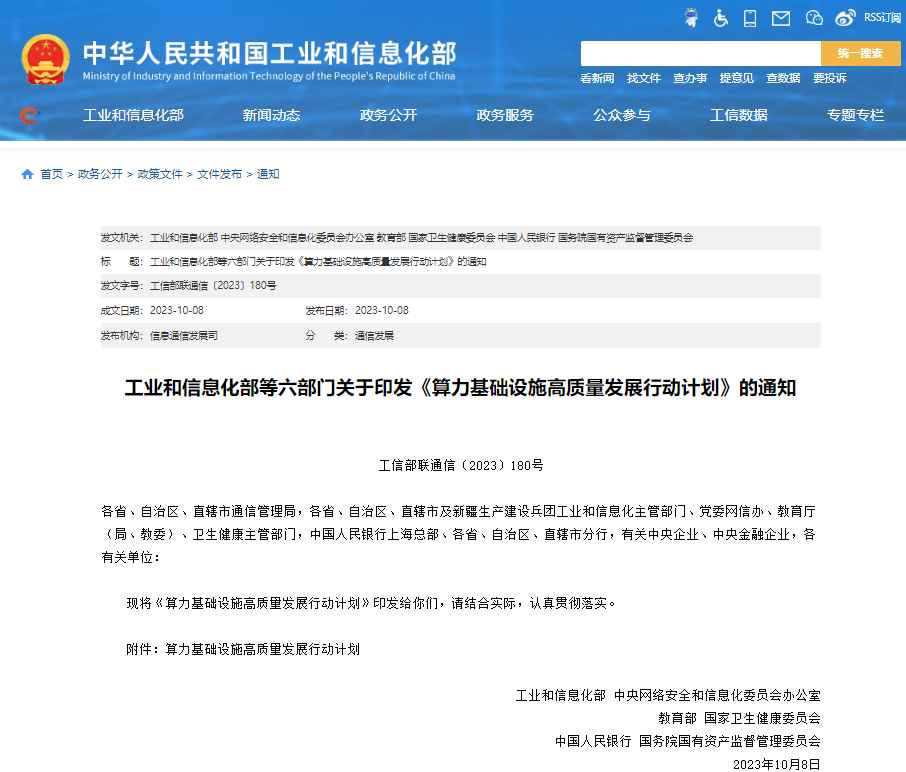

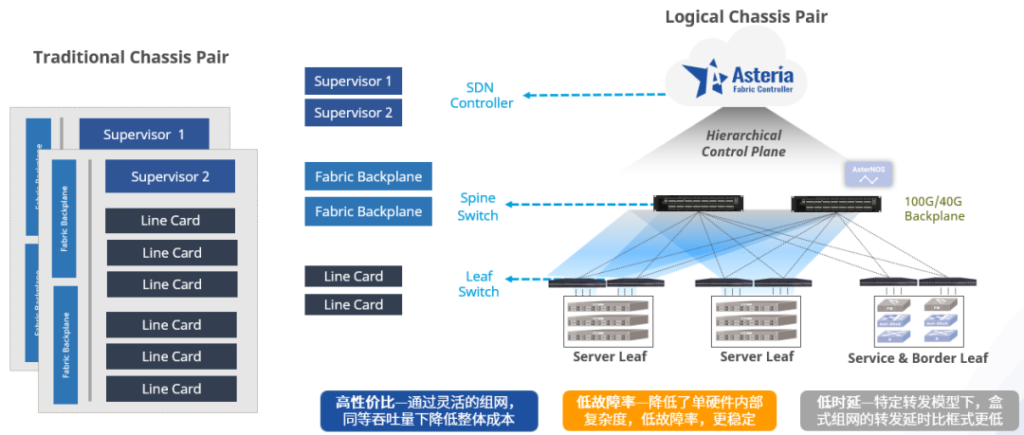

星融元采用基于RoCE的分布式概念替换了传统机框,相比较框式交换机,星融元盒式交换机拥有高性价比、低故障率、低时延等优点,星融元200G交换机在2U盒式形态下提供64高密度端口,能够提供更大的接入能力,与400G交换机混合组网部署网络,充分满足客户需求。另外星融元“零丢包”数据传输特性保障了网络的稳定性和可靠性,让AI厂商模型运行不中断,为高性能计算集群提供了真正意义上的低时延、零丢包、高性能的网络。

| 名称 | 型号 | 硬件指标 | 数量 | 备注 |

|---|---|---|---|---|

| 交换机 | Asterfusion CX664D-N | / | 6 | 64口200G低时延交换机 |

| 服务器 | 超聚变 | CPU:Intel Xeon Platinum 8469C 内存:2048G | 8 | / |

| Mellanox网卡 | MCX755106AS-HEAT | Mellanox CX-7 | 64 | / |

| BlueField-3 | 8 | |||

| 网卡驱动 | MLNX_OFED-5.8 | / | / | / |

| GPU | NVIDIA H800 | NVIDIA Corporation Device 2324 | 64 | / |

| 操作系统 | Ubuntu22.04 | / | / | / |

| CUDA | V12.2 | / | / | / |

| OpenMPI | V4.1.3 | / | / | / |

| GPU驱动 | V535.129.03 | / | / | / |

| NVIDIA Fabricmanager | V535.129.03 | / | / | / |

| NCCL | V2.18.5 | / | / | / |

客户现场软硬件环境&性能测试指标

GPU Server-Leaf-Spine-Leaf-GPU Server

| Bond RoCEv2带宽GB/s | QP=0 | QP=128 | QP=300 | QP=1024 | TX_UTIL |

| Hash enhancement | 186.32 | 300.32 | 344.64 | 355.25 | 98.62% |

| No Hash enhancement | 186.84 | 296.84 | 338.26 | 349.52 | 97.13% |

GPU Server-Leaf-GPU Server

| Bond RoCEv2带宽GB/s | QP=0 | QP=128 | QP=300 | QP=1024 | TX_UTIL |

| Hash enhancement | 187.14 | 301.39 | 342.91 | 351.84 | 98.84% |

| No Hash enhancement | 187.32 | 297.84 | 339.38 | 349.32 | 96.60% |

在多次客户实地RoCE能力测试中,星融元使用Asterfusion CX-N超低时延云交换机搭建AIGC网络,完成RoCEv2吞吐性能测试、网卡Bond性能测试和NCCL all_reduce_perf测试,AIGC计算节点完成RDMA配置和性能优化,获得客户的认可。

AI对市场竞争格局的影响愈发明显,200G/400G交换机的需求越来越多,提出高带宽、低时延、大规模部署的技术要求,同时也带来了诸多市场机会,“重金求设备”便可一窥趋势。

准备好迎接AI基础设施这一波“泼天的富贵”了吗?星融元准备好了。

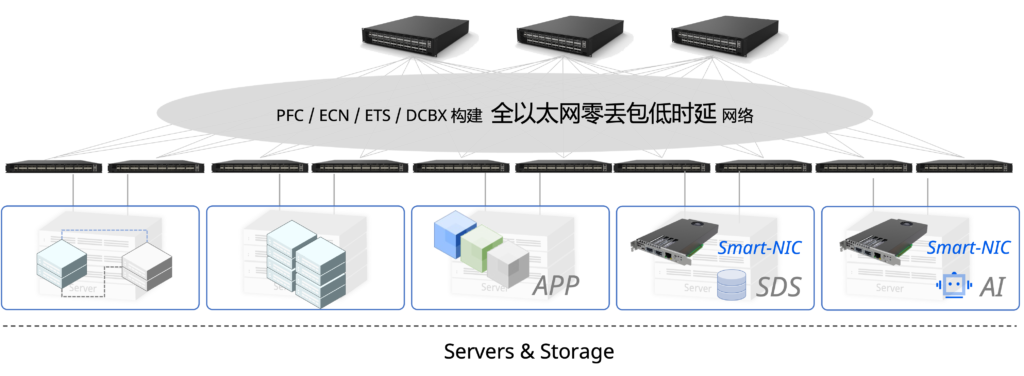

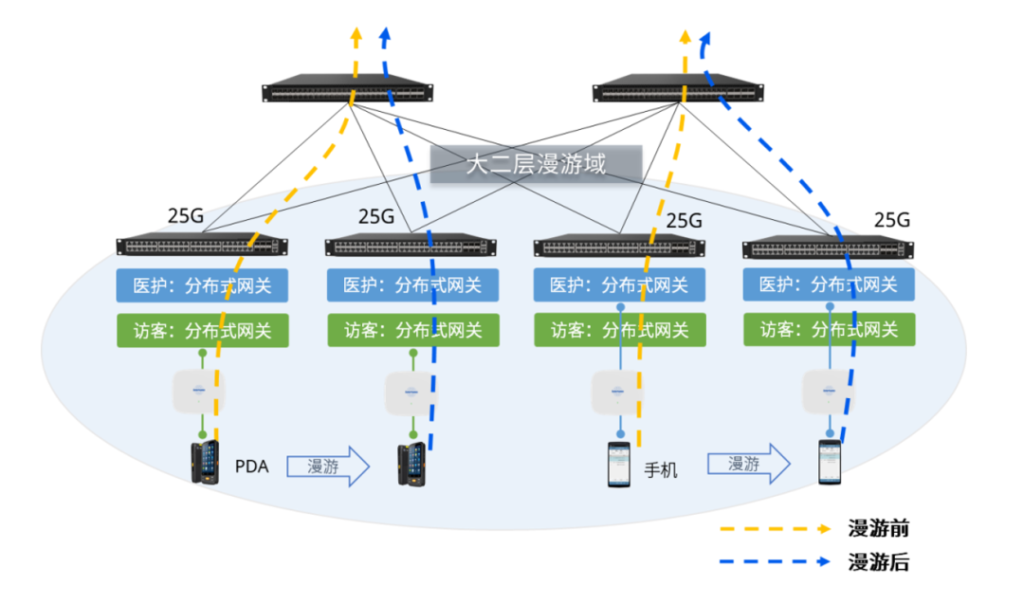

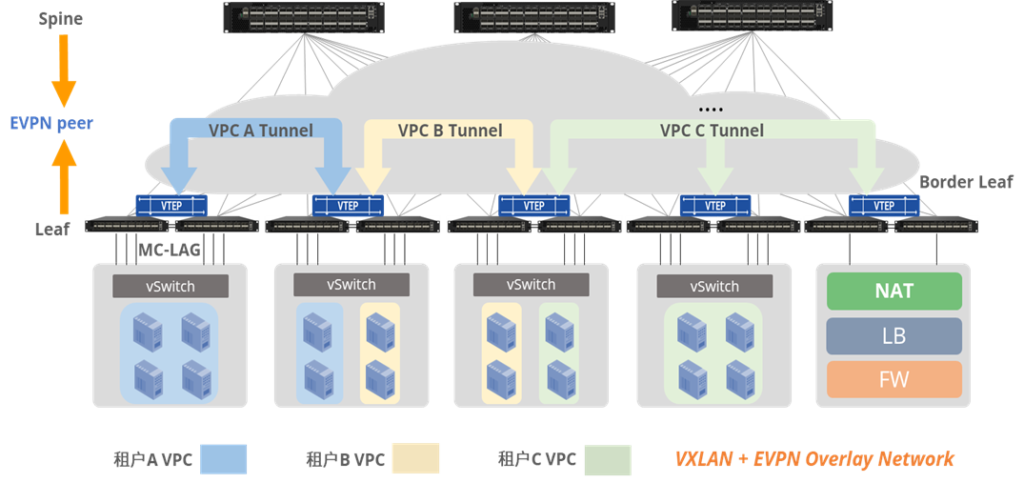

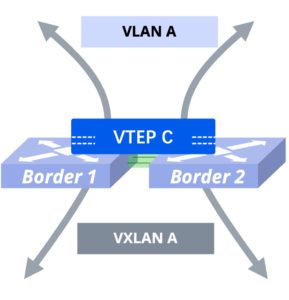

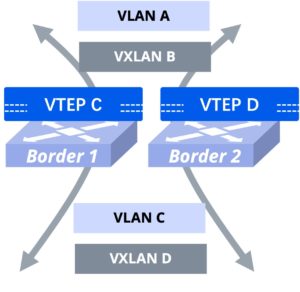

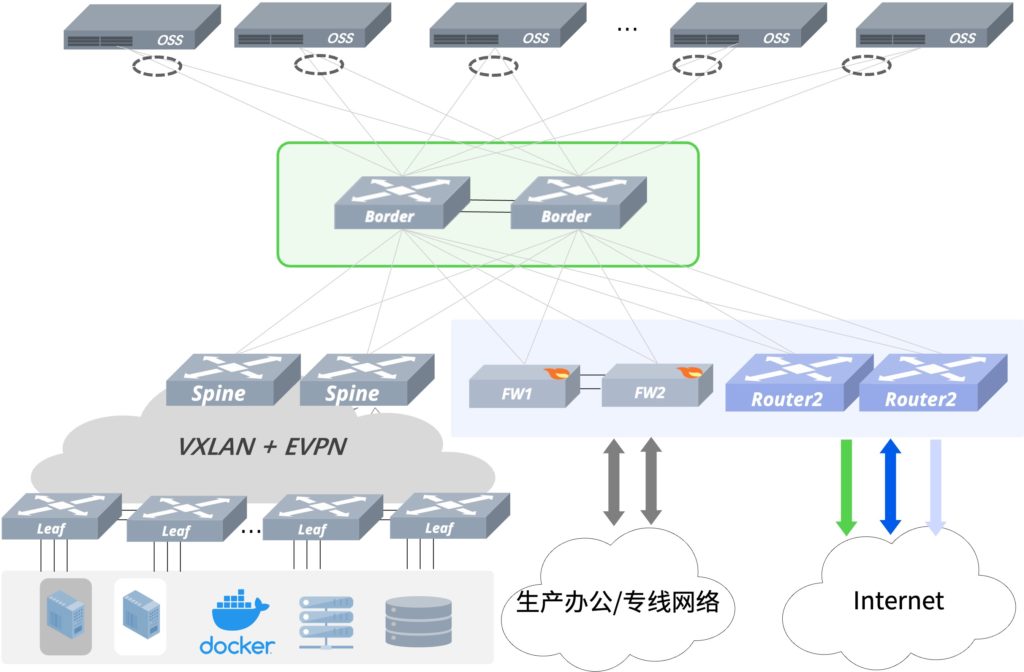

两台Border配置不同的VTEP地址,利用物理三层接口以及三层子接口和边界防火墙和边界路由器对接;同时组建MC-LAG系统,设置Monitor-Link上行口联动与OSS主机相连的下行端口,Border与OSS主机相连端口放通OSS业务VLAN,并在设备内部创建VLAN虚接口作为OSS主机的分布式网关。(该方案适用于防火墙主备场景以及采用动态路由协议的对接场景)

两台Border配置不同的VTEP地址,利用物理三层接口以及三层子接口和边界防火墙和边界路由器对接;同时组建MC-LAG系统,设置Monitor-Link上行口联动与OSS主机相连的下行端口,Border与OSS主机相连端口放通OSS业务VLAN,并在设备内部创建VLAN虚接口作为OSS主机的分布式网关。(该方案适用于防火墙主备场景以及采用动态路由协议的对接场景)