什么是以太网交换机的网络时延?

更多相关内容

网络时延是现代网络的一个重要方面,对数据传输的效率有着深远的影响。以太网时延是一个经常出现的术语,但您对它有深入的了解吗?本文将讨论什么是网络时延、网络时延的原因、如何测量网络时延以及如何使用以太网交换机减少网络时延。请继续阅读,了解更多信息。

什么是网络时延?

网络时延的含义

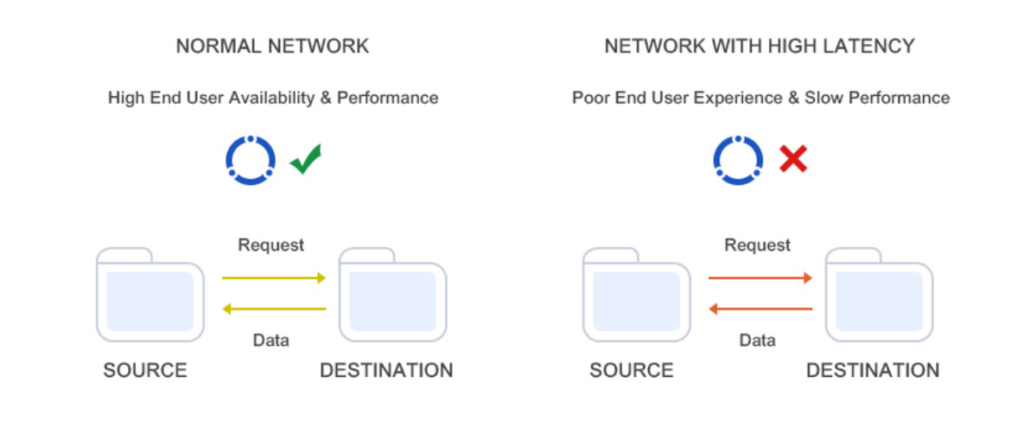

术语 “网络时延 “是指网络数据传输的时延。以太网交换机时延是指以太网数据包通过网络交换机所需的具体时间。时延时间长的网络称为高时延网络,时延时间短的网络称为低时延网络。

以太网交换机时延可从两个角度来理解–单向时延和往返时延。后者通常用作主要指标,包括以太网数据包从源到目的地所需的总时间。如今,往返时延是一个重要指标,因为设备使用 TCP/IP 网络协议将特定数据发送到目的地,并等待回执后再发送另一个数据。因此,这种方法对网络性能有重大影响。

网络时延的意义

随着越来越多的公司进行数字化转型,它们开始采用基于云的应用程序和服务来执行基本业务功能。运营活动还依赖于从连接到互联网的智能设备(统称为物联网 (IoT))上收集的数据。时延会导致效率低下,特别是在依赖传感器数据的实时操作中。此外,即使企业实施了昂贵的网络基础设施,高时延也会降低为提高网络容量所做投资的回报,影响用户体验和客户满意度。

是什么导致了网络时延?

前几节介绍了网络时延的概念。本节将探讨造成时延的原因。造成网络时延的因素很多。以下是可能造成时延的几个潜在因素。

- 传输介质的影响:由于数据是通过传输介质或链路传输的,因此传输介质或链路对时延的影响很大。例如,光纤网络的时延比无线网络低。同样,每次网络从一种介质切换到另一种介质时,总传输时间都会增加几毫秒。

- 报头分析:以太网交换机有时需要额外的时间来分析数据包报头细节并纳入重要数据,因此会产生时延。这会导致通过交换机的数据包的遍历时间延长。

- 与存储相关的数据包时延:当数据包在交换机和网桥等中间设备上遇到存储或磁盘访问时延时,就会出现存储时延。

- 安全处理时延:网络时延可能受到反病毒和安全进程的影响,这些进程在传输前需要时间完成信息重组和分解。

如何测量时延?

IEEE 规范 RFC2544

IEEE RFC2544 规范为评估存储转发设备的时延提供了一种广为接受的方法。RFC2544 要求时延测试至少重复 20 次,测试结果为所有测试结果的平均值。

Netperf

Netperf 是基于 TCP 或 UDP 传输的网络性能测量工具。Netperf 测试结果反映了一个系统向另一个系统发送数据的速度和另一个系统接收数据的速度。

Ping ping

Ping Pong 是一种用于测量高性能计算集群内时延的方法。这种方法可评估通过消息传递接口(MPI)传输的远程过程调用(RPC)的往返持续时间。

如何利用以太网交换机减少网络时延?

使用以太网交换机最大限度地减少网络时延有多种方法。这些方法包括:

增加网络容量

减少时延和碰撞最直接有效的方法之一是为以太网交换机配备所需的容量。 验证交换机是否具备扩展网络容量的能力非常重要。 确保零数据包丢失的以太网交换机在提高网络性能方面发挥着至关重要的作用。链路聚合控制协议(简称 LACP)是一项标准功能,可通过端口中继提高网络性能。了解产品信息,请访问:https://asterfusion.com/product/cx-n/

使用 VLAN 进行网络划分

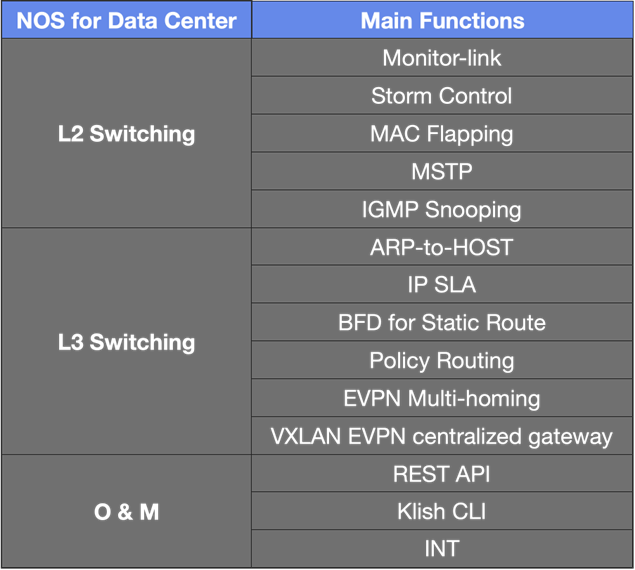

鉴于传统的扁平网络往往会导致链路过载,配备 VLAN 功能的以太网交换机可以有效地将流量路由到预定目的地。 一系列第 2 层和第 3 层 VLAN 以太网交换机可根据端口、动态 VLAN 分配、协议、MAC 地址等因素进行流量划分。

实施穿透技术

这种方法与数据包交换系统有关,旨在最大限度地减少网络时延。 直通式交换通过允许交换机在收到完整数据包之前,即在处理目的地址后立即启动数据包转发,从而减少网络时延。 不过,需要注意的是,这种技术只有在端口以相同速度运行时才能发挥最佳功能。

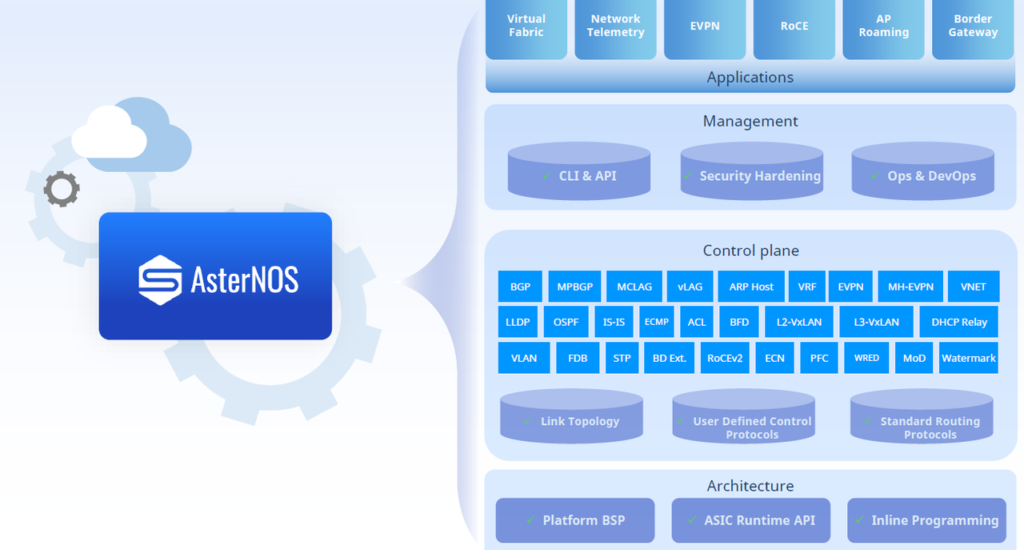

利用 RDMA 减少时延

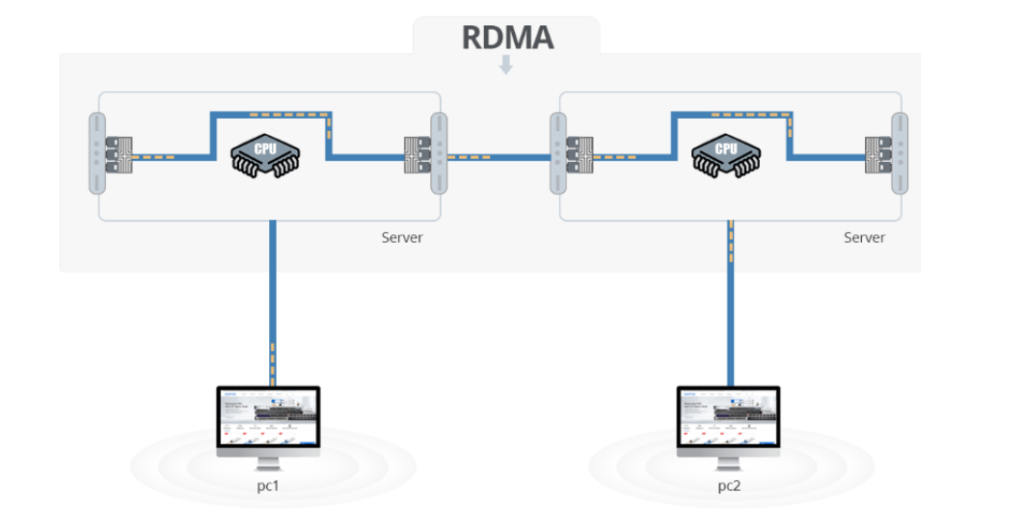

RDMA 或远程直接内存访问是一种尖端网络技术,它彻底改变了数据传输效率。与涉及 CPU 的传统方法不同,RDMA 实现了网络内计算机内存之间的直接数据交换。这避开了中央处理器,减少了时延,从而加快了实时模拟、数据分析和高性能计算等任务的数据通信。QSFPTEK 的 S5600 和 S7600 系列交换机支持 RDMA,可提供高吞吐量和超低时延。

结论

总之,网络时延对以太网交换机的高效数据传输至关重要。本文旨在阐明以太网交换机中以太网时延的概念,并深入探讨减少时延的策略。虽然不可能完全消除网络时延,但我们的目标是尽可能地减少时延。在当今依赖网络的环境中,了解网络时延的影响并应用缓解策略至关重要。

如何计算公有云方案和与本地私有云的总体拥有成本(TCO)?

如何计算公有云方案和与本地私有云的总体拥有成本(TCO)? 洞察成本构成

洞察成本构成

-图1-1024x507.png)

-图2.png)

-图3-1024x220.png)

-图1.png)

-图2.png)

-图3.png)

-图4.png)

-图11.png)

-图10-300x145.png)

-图14-300x222.png)

-图15.png)